Meta AI ha lanzado sorprendentemente un modelo de lenguaje multimodal básico llamado SPIRIT LM, que es un logro histórico que puede mezclar libremente texto y voz. Se basa en un modelo de lenguaje de texto previamente entrenado con 7 mil millones de parámetros y se extiende al modo de voz a través de entrenamiento continuo, logrando comprensión y generación dual de texto y voz, e incluso puede mezclar los dos, generando efectos de aplicación inesperados. El editor de Downcodes lo llevará a comprender en profundidad las poderosas funciones de SPIRIT LM y los avances tecnológicos detrás de él.

Meta AI ha abierto recientemente un modelo de lenguaje multimodal básico llamado SPIRIT LM, que puede mezclar libremente texto y voz, abriendo nuevas posibilidades para tareas multimodales de audio y texto.

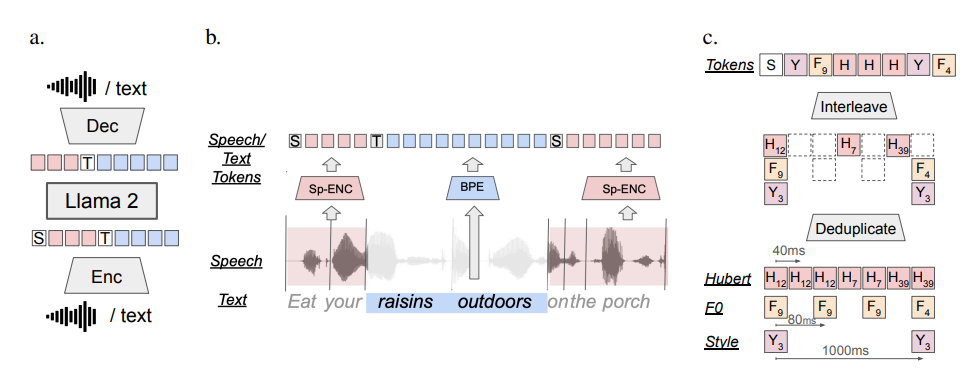

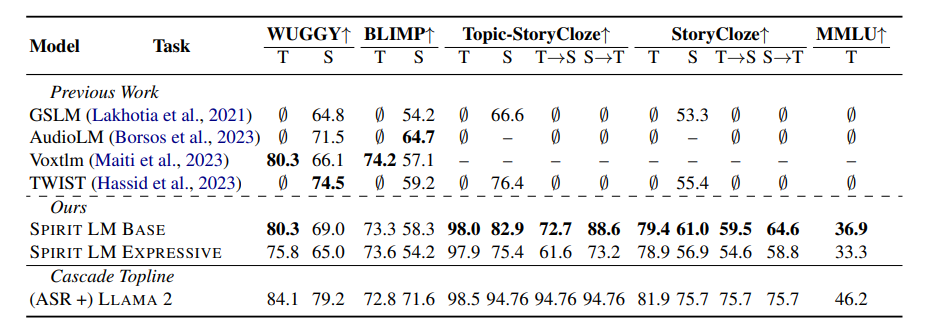

SPIRIT LM se basa en un modelo de lenguaje de texto previamente entrenado con 7 mil millones de parámetros y se extiende a modalidades de voz a través de entrenamiento continuo en unidades de texto y voz. Puede comprender y generar texto como un modelo de texto grande, y también puede comprender y generar voz. Incluso puede mezclar texto y voz para crear varios efectos mágicos. Por ejemplo, puede usarlo para el reconocimiento de voz y convertir voz en. texto; también puede usarlo para síntesis de voz para convertir texto en voz; también puede usarlo para clasificación de voz para determinar qué emoción expresa un discurso;

Lo que es aún más poderoso es que SPIRIT LM también es particularmente bueno en la "expresión emocional". ¡Puede reconocer y generar una variedad de entonaciones y estilos de voz diferentes, haciendo que la voz de la IA suene más natural y emocional! ¡Puedes imaginar que la voz generada por SPIRIT LM ya no es la voz fría de una máquina, sino la de una persona real hablando, llena de alegría, ira, tristeza y alegría!

Para hacer que la IA sea más "emocional", los investigadores de Meta también han desarrollado especialmente dos versiones de SPIRIT LM:

"Edición básica" (BASE): esta versión se centra principalmente en la información de los fonemas del habla, que es la "composición básica" del habla.

"Versión expresiva" (EXPRESSIVE): Además de la información de los fonemas, esta versión también agrega información de tono y estilo, lo que puede hacer que la voz de la IA sea más vívida y expresiva.

Entonces, ¿cómo hace SPIRIT LM todo esto?

En pocas palabras, SPIRIT LM está entrenado en base a LLAMA2, un modelo de texto grande súper poderoso lanzado anteriormente por Meta. Los investigadores "alimentaron" una gran cantidad de datos de texto y voz a LLAMA2 y adoptaron un método especial de "entrenamiento intercalado" para que LLAMA2 pueda aprender las reglas del texto y del habla al mismo tiempo.

Para probar la capacidad de "expresión emocional" de SPIRIT LM, los investigadores de Meta también diseñaron una nueva prueba de referencia: la "Preservación de sentimientos de voz y texto" (STSP). Este punto de referencia de prueba contiene una variedad de indicaciones de voz y texto que expresan diferentes emociones para probar si el modelo de IA puede reconocer y generar con precisión voz y texto con las emociones correspondientes. Los resultados muestran que la "versión de expresión" de SPIRIT LM funciona bien en la retención de emociones y actualmente es el primer modelo de IA que puede retener información emocional en todas las modalidades.

Por supuesto, los investigadores de Meta también admitieron que SPIRIT LM todavía tiene muchas áreas de mejora. Por ejemplo, SPIRIT LM actualmente solo admite inglés y debe expandirse a otros idiomas en el futuro. La escala del modelo de SPIRIT LM no es lo suficientemente grande y es necesario continuar expandiendo la escala del modelo y mejorar el rendimiento del modelo; el futuro.

SPIRIT LM es el mayor avance de Meta en el campo de la IA. Nos abre la puerta al mundo de la IA "sonoro y emocional". Creo que en un futuro próximo veremos más aplicaciones interesantes desarrolladas basadas en SPIRIT LM, para que la IA no solo pueda hablar con elocuencia, sino también expresar emociones como personas reales y comunicarse con nosotros de forma más natural y cordial.

Dirección del proyecto: https://speechbot.github.io/spiritlm/

Dirección del artículo: https://arxiv.org/pdf/2402.05755

Con todo, el código abierto de SPIRIT LM ha traído un progreso emocionante al campo de la IA multimodal. Su aparición presagia que la IA logrará mayores avances en la interacción de voz y la expresión emocional en el futuro. El editor de Downcodes seguirá pagando. Atención a este campo. Las últimas noticias, ¡estén atentos!