El editor de Downcodes se enteró de que el Instituto Allen de Inteligencia Artificial (Ai2) lanzó recientemente Molmo, una nueva familia de modelos de IA multimodal de código abierto. Su rendimiento es sorprendente, superando incluso a GPT-4o de OpenAI y a Anthropic en múltiples pruebas comparativas de terceros. .Claude3.5Sonnet y Gemini1.5 de Google. Molmo no solo analiza las imágenes cargadas por los usuarios, sino que también utiliza 1000 veces menos datos durante el entrenamiento que sus competidores, gracias a sus técnicas de entrenamiento únicas. Este avance demuestra el compromiso de Ai2 con la investigación abierta, haciendo que modelos de alto rendimiento y pesos y datos abiertos estén disponibles para la comunidad y la empresa en general.

Molmo no sólo acepta imágenes cargadas por los usuarios para su análisis, sino que también utiliza "1.000 veces menos datos que la competencia" para la formación, gracias a sus técnicas de formación únicas.

Este lanzamiento demuestra el compromiso de Ai2 con la investigación abierta, proporcionando modelos de alto rendimiento con pesos y datos abiertos para uso de la comunidad y las empresas en general. La familia Molmo incluye cuatro modelos principales: Molmo-72B, Molmo-7B-D, Molmo-7B-O y MolmoE-1B es el modelo insignia, que contiene 7,2 mil millones de parámetros y su rendimiento es particularmente sobresaliente.

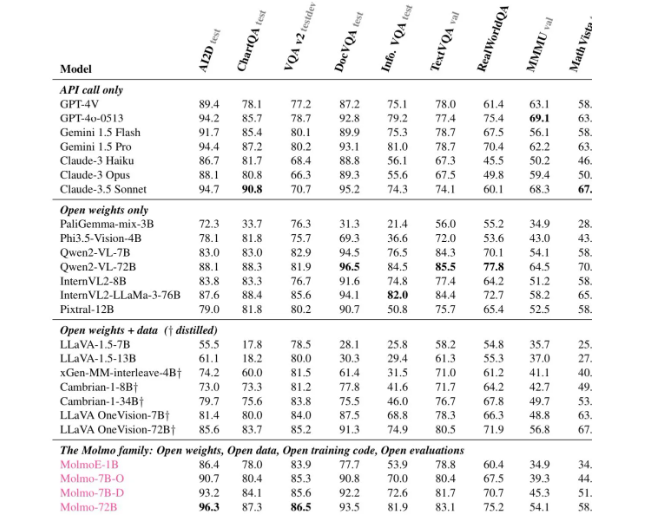

Según diversas evaluaciones, Molmo-72B recibió las puntuaciones más altas en 11 puntos de referencia importantes y ocupó el segundo lugar después de -4o en términos de preferencia de usuario. Ai2 también lanzó un modelo OLMoE, utilizando un enfoque de "combinación de modelos pequeños" para mejorar la rentabilidad.

La arquitectura de Molmo ha sido cuidadosamente diseñada para lograr eficiencia y un rendimiento superior. Todos los modelos utilizan el modelo CLIP ViT-L/14336px de OpenAI como codificador visual para procesar imágenes de múltiples escalas en comandos visuales. La parte del modelo de lenguaje es el decodificador Transformer, que tiene diferentes capacidades y apertura.

En términos de capacitación, Mol se somete a dos etapas de capacitación: la primera, preentrenamiento multimodelo y la segunda, ajuste fino supervisado. A diferencia de muchos modelos modernos, Molmo no se basa en el aprendizaje reforzado con retroalimentación humana, sino que actualiza los parámetros del modelo mediante un proceso de entrenamiento cuidadosamente ajustado.

Molmo tuvo un buen desempeño en múltiples evaluaciones comparativas, especialmente en tareas complejas como lectura de documentos y razonamiento visual, lo que demuestra sus sólidas capacidades. Ai2 ha publicado estos modelos y conjuntos de datos en Hugging Face y lanzará más modelos e informes técnicos ampliados en los próximos meses para proporcionar más recursos a los investigadores.

Si desea conocer las capacidades de Molmo, ahora hay demostraciones públicas disponibles a través del sitio web oficial de Molmo (https://molmo.allenai.org/).

Destacar:

El modelo de IA modal de código abierto de Ai2Molmo supera a los mejores productos de la industria.

Mol-72B funciona bien en múltiples pruebas, solo superado por GPT4o.

Es muy abierto y los investigadores pueden utilizar libremente modelos y conjuntos de datos.

Con todo, la aparición de Molmo marca un avance importante en el campo de la IA multimodal, y su naturaleza de código abierto también proporciona recursos valiosos para investigadores de todo el mundo. El editor de Downcodes espera que Molmo se utilice y desarrolle más ampliamente en el futuro y promueva el progreso continuo de la tecnología de inteligencia artificial.