El rápido desarrollo de los grandes modelos de lenguaje (LLM) es impresionante, pero simplemente perseguir la expansión de la escala del modelo no es suficiente para lograr una verdadera inteligencia de IA. El editor de Downcodes cree que darle al modelo la capacidad de autoevolucionar para que pueda continuar aprendiendo y mejorando durante la etapa de inferencia es crucial para el desarrollo futuro de la IA. Este artículo explorará el factor clave en la autoevolución de la IA: la memoria a largo plazo (LTM) y cómo lograr un progreso continuo en la IA a través de LTM.

Los modelos de lenguajes grandes (LLM), como la serie GPT, han demostrado capacidades asombrosas en la comprensión, el razonamiento y la planificación del lenguaje con sus enormes conjuntos de datos, y han alcanzado niveles comparables a los humanos en diversas tareas desafiantes. La mayoría de las investigaciones se han centrado en mejorar aún más estos modelos entrenándolos en conjuntos de datos más grandes, con el objetivo de desarrollar modelos base más potentes.

Sin embargo, aunque entrenar un modelo básico más potente es crucial, los investigadores creen que darle al modelo la capacidad de continuar evolucionando durante la etapa de inferencia, es decir, la autoevolución de la IA, también es crucial para el desarrollo de la IA. En comparación con el uso de datos a gran escala para entrenar un modelo, es posible que la autoevolución solo requiera datos o interacciones limitados.

Inspirándose en la estructura columnar de la corteza cerebral humana, los investigadores plantearon la hipótesis de que los modelos de IA pueden desarrollar habilidades cognitivas emergentes y construir modelos de representación interna a través de interacciones iterativas con su entorno.

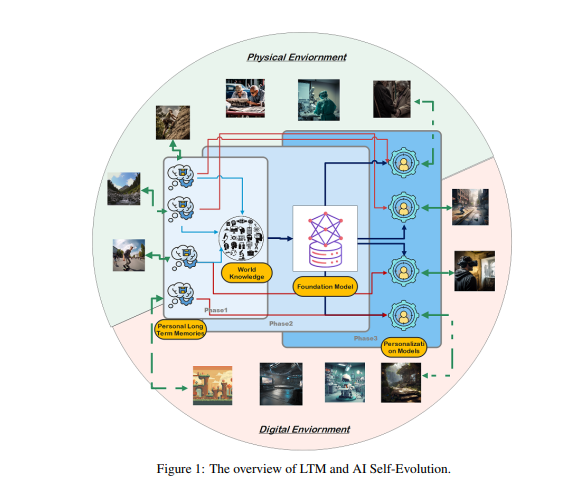

Para lograr este objetivo, los investigadores propusieron que el modelo debe tener memoria a largo plazo (LTM) para almacenar y gestionar datos procesados de interacción del mundo real. LTM no solo es capaz de representar datos individuales de cola larga en modelos estadísticos, sino que también promueve la autoevolución al respaldar diversas experiencias en diversos entornos y agentes.

LTM es la clave para lograr la autoevolución de la IA. De manera similar a cómo los humanos aprenden y mejoran continuamente a través de la experiencia personal y la interacción con el entorno, la autoevolución de los modelos de IA también se basa en los datos LTM acumulados durante las interacciones. A diferencia de la evolución humana, la evolución del modelo impulsado por LTM no se limita a interacciones del mundo real. Los modelos pueden interactuar con el entorno físico como los humanos y recibir retroalimentación directa, que se procesa para mejorar sus capacidades. Esta es también un área de investigación clave en la IA incorporada.

Por otro lado, los modelos también pueden interactuar en entornos virtuales y acumular datos LTM, lo que tiene un costo menor y es más eficiente que la interacción en el mundo real, mejorando así las capacidades de manera más efectiva.

La creación de LTM requiere refinar y estructurar datos sin procesar. Los datos sin procesar se refieren a la recopilación de todos los datos no procesados recibidos por el modelo a través de la interacción con el entorno externo o durante el proceso de capacitación. Estos datos contienen una variedad de observaciones y registros, que pueden contener patrones valiosos y grandes cantidades de información redundante o irrelevante.

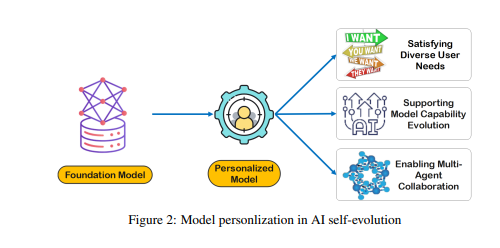

Si bien los datos sin procesar forman la base de la memoria y la cognición del modelo, requieren un procesamiento adicional antes de que puedan usarse de manera efectiva para la personalización o la ejecución eficiente de tareas. LTM refina y estructura estos datos sin procesar para que el modelo pueda utilizarlos. Este proceso mejora la capacidad del modelo para proporcionar respuestas y recomendaciones personalizadas.

La creación de LTM enfrenta desafíos como la escasez de datos y la diversidad de usuarios. En los sistemas LTM que se actualizan continuamente, la escasez de datos es un problema común, especialmente para usuarios con un historial de interacción limitado o actividades dispersas, lo que dificulta el entrenamiento del modelo. Además, la diversidad de usuarios también agrega complejidad, lo que requiere que los modelos se adapten a patrones individuales y se generalicen de manera efectiva entre diferentes grupos de usuarios.

Los investigadores desarrollaron un marco de colaboración de múltiples agentes llamado Omne, que implementa la autoevolución de la IA basada en LTM. En este marco, cada agente tiene una estructura de sistema independiente y puede aprender y almacenar de forma autónoma un modelo de entorno completo para construir una comprensión independiente del entorno. A través de este desarrollo colaborativo basado en LTM, el sistema de IA puede adaptarse a los cambios en el comportamiento individual en tiempo real, optimizar la planificación y ejecución de tareas y promover aún más la autoevolución de la IA personalizada y eficiente.

El marco Omne logró el primer lugar en la prueba comparativa GAIA, lo que demuestra el enorme potencial de aprovechar LTM para la autoevolución de la IA y la resolución de problemas del mundo real. Los investigadores creen que avanzar en la investigación de LTM es crucial para el desarrollo continuo y la aplicación práctica de la tecnología de IA, especialmente en términos de autoevolución.

Con todo, la memoria a largo plazo es clave para la autoevolución de la IA, ya que permite que los modelos de IA aprendan y mejoren a partir de la experiencia como los humanos. Desarrollar y aprovechar LTM requiere superar desafíos como la escasez de datos y la diversidad de usuarios. El marco Omne proporciona una solución factible para la autoevolución de la IA basada en LTM, y su éxito en la prueba comparativa GAIA demuestra el enorme potencial en este campo.

Documento: https://arxiv.org/pdf/2410.15665

Gracias a la investigación sobre la memoria a largo plazo (LTM), la autoevolución de la IA ya no es un sueño lejano. En el futuro, se espera que los modelos de IA basados en LTM demuestren capacidades más potentes en una gama más amplia de campos y aporten mayores beneficios a la sociedad humana. ¡Esperamos resultados más innovadores!