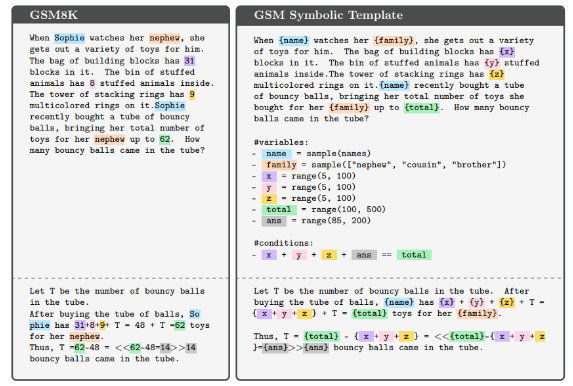

El editor de Downcodes se enteró de que los investigadores de Apple lanzaron una nueva prueba de referencia llamada GSM-Symbolic para las capacidades de razonamiento matemático de modelos de lenguaje grandes (LLM). Esta prueba se basa en GSM8K y está diseñada para evaluar de manera más integral las capacidades de razonamiento de LLM, en lugar de depender únicamente de su coincidencia de patrones probabilísticos. Aunque GSM8K es popular, tiene problemas como contaminación de datos y fluctuaciones de rendimiento. GSM-Symbolic supera estas deficiencias generando problemas matemáticos diversificados a partir de plantillas simbólicas, lo que garantiza una evaluación más precisa.

Recientemente, los investigadores de Apple realizaron un estudio en profundidad de las capacidades de razonamiento matemático de los modelos de lenguaje grandes (LLM) y lanzaron un nuevo punto de referencia llamado GSM-Symbolic.

Este nuevo punto de referencia se desarrolla sobre la base de GSM8K, que se utiliza principalmente para evaluar la capacidad matemática básica. Aunque el rendimiento de muchos LLM ha mejorado con GSM8K, la comunidad científica todavía tiene dudas sobre las capacidades de razonamiento de estos modelos, creyendo que las métricas de evaluación existentes pueden no reflejar completamente sus verdaderas capacidades. Las investigaciones han descubierto que los LLM a menudo se basan en la coincidencia de patrones probabilísticos en lugar de un verdadero razonamiento lógico, lo que los hace muy sensibles a pequeños cambios en los datos de entrada.

En el nuevo estudio, los investigadores utilizaron plantillas simbólicas para generar diversos problemas matemáticos que proporcionan evaluaciones más confiables. Los resultados experimentales muestran que el rendimiento de LLM disminuye significativamente cuando aumenta el valor numérico o la complejidad del problema. Además, incluso agregar información que sea superficialmente relevante para el problema pero que en realidad no sea irrelevante puede hacer que el rendimiento del modelo se degrade hasta en un 65%. Estos resultados confirman una vez más que LLM se basa más en la coincidencia de patrones que en el razonamiento lógico formal al razonar.

El conjunto de datos GSM8K contiene más de 8.000 problemas matemáticos de nivel de grado y su popularidad plantea varios riesgos, como la contaminación de datos y las fluctuaciones de rendimiento causadas por pequeños cambios en los problemas. Para hacer frente a estos desafíos, la aparición de GSM-Symbolic permite controlar eficazmente la diversidad de problemas. Este punto de referencia evalúa más de 20 modelos abiertos y cerrados utilizando 5000 muestras de 100 plantillas, lo que demuestra los conocimientos y las limitaciones de las capacidades de razonamiento matemático de LLM.

Los experimentos preliminares muestran que el rendimiento de diferentes modelos en GSM-Symbolic varía significativamente y la precisión general es menor que el rendimiento informado en GSM8K. El estudio exploró más a fondo el impacto de cambiar los nombres y valores de las variables en LLM, y los resultados mostraron que los cambios en los valores tuvieron un mayor impacto en el rendimiento. Además, la complejidad del problema también afecta directamente a la precisión, y los problemas complejos conducen a una degradación significativa del rendimiento. Estos resultados sugieren que el modelo puede depender más de la coincidencia de patrones que de las verdaderas capacidades de razonamiento cuando se trata de problemas matemáticos.

Este estudio destaca las limitaciones de las evaluaciones actuales de GSM8K e introduce un nuevo punto de referencia, GSM-Symbolic, diseñado para evaluar las capacidades de razonamiento matemático de los LLM. En general, los hallazgos indican que los LLM aún necesitan mejorar aún más sus habilidades de razonamiento lógico cuando se enfrentan a problemas complejos.

Documento: https://arxiv.org/abs/2410.05229

Con todo, el punto de referencia GSM-Symbolic propuesto por Apple proporciona una nueva perspectiva para evaluar las capacidades de razonamiento matemático de grandes modelos de lenguaje. También revela que LLM todavía tiene margen de mejora en el razonamiento lógico, lo que señala el camino para futuras mejoras del modelo. Esperamos realizar más investigaciones en el futuro para promover aún más el desarrollo de las capacidades de razonamiento de LLM.