Recientemente, el editor de Downcodes llamó la atención sobre una noticia preocupante: se descubrió que la herramienta de transcripción de IA ampliamente utilizada en la industria médica, basada en la tecnología Whisper de OpenAI, tenía "alucinaciones" y podía generar contenido falso. Esto ha generado preocupaciones sobre la seguridad y confiabilidad de la tecnología de inteligencia artificial en el campo médico. Este artículo analizará este incidente en detalle, explorará sus riesgos potenciales y la respuesta de OpenAI.

Recientemente, una herramienta de transcripción de IA impulsada por la tecnología Whisper de OpenAI ha ganado popularidad en la industria médica. Muchos médicos y organizaciones sanitarias utilizan esta herramienta para registrar y resumir los encuentros de los pacientes.

Según un informe de ABC News, los investigadores descubrieron que esta herramienta puede causar "alucinaciones" en algunos casos y, a veces, incluso fabricar contenido por completo.

La herramienta de transcripción, desarrollada por una empresa llamada Nabla, ha transcrito con éxito más de 7 millones de conversaciones médicas y actualmente la utilizan más de 30.000 médicos y 40 sistemas de salud. Aún así, Nabla es consciente del potencial de Whisper para provocar alucinaciones y dice que está trabajando para abordar el problema.

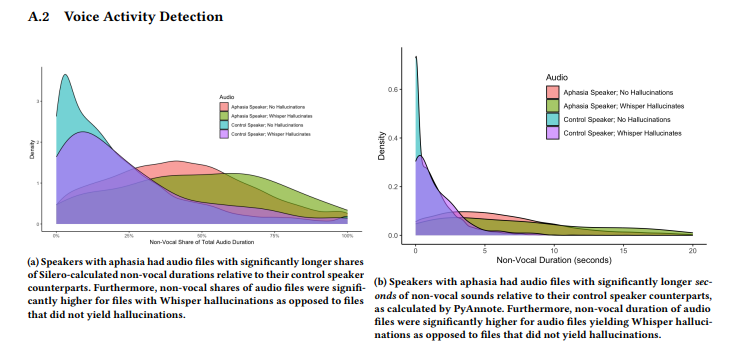

Un estudio realizado por un equipo de investigadores de la Universidad de Cornell, la Universidad de Washington y otros encontró que Whisper alucinaba en aproximadamente el 1% de sus transcripciones. En estos casos, la herramienta genera aleatoriamente frases sin sentido durante los períodos de silencio de la grabación, que en ocasiones expresan emociones violentas. Los investigadores recolectaron muestras de audio de AphasiaBank de TalkBank y observaron que el silencio es particularmente común cuando hablan personas con trastornos del habla.

La investigadora de la Universidad de Cornell, Allison Koenecke, compartió algunos ejemplos en las redes sociales que muestran el contenido alucinatorio generado por Whisper. Los investigadores descubrieron que el contenido generado por la herramienta también incluía términos médicos inventados e incluso frases como "¡Gracias por mirar!" que sonaban como palabras de videos de YouTube.

La investigación fue presentada en la conferencia FAccT de la Association for Computing Machinery en Brasil en junio, pero no está claro si ha sido revisada por pares. Respecto a este tema, la portavoz de OpenAI, Taya Christianson, dijo en una entrevista con "The Verge" que se toman este tema muy en serio y seguirán trabajando duro para mejorarlo, especialmente en la reducción de las alucinaciones. Al mismo tiempo, mencionó que al usar Whisper en su plataforma API, existen políticas de uso claras que prohíben el uso de la herramienta en ciertos entornos de toma de decisiones de alto riesgo.

Destacar:

La herramienta de transcripción Whisper se utiliza ampliamente en la industria médica y ha registrado 7 millones de conversaciones médicas.

⚠️ Las investigaciones han descubierto que Whisper "alucina" en aproximadamente el 1% de las transcripciones, generando a veces contenido sin sentido.

OpenAI dice que está trabajando para mejorar el rendimiento de las herramientas, particularmente en la reducción de las alucinaciones.

En definitiva, la tecnología de IA tiene amplias perspectivas de aplicación en el campo médico, pero también enfrenta muchos desafíos. La aparición del fenómeno de las “alucinaciones” de Whisper nos recuerda que debemos tratar la tecnología de IA con precaución y fortalecer la supervisión de su seguridad y confiabilidad para garantizar su aplicación segura y efectiva en el campo médico y proteger los derechos y la seguridad de los pacientes. El editor de Downcodes seguirá atento al desarrollo posterior de este incidente.