La naturaleza de "caja negra" de los grandes modelos de lenguaje (LLM) siempre ha sido un tema importante que plaga el campo de la inteligencia artificial. La no interpretación de los resultados del modelo hace difícil garantizar su confiabilidad y credibilidad. Para resolver este problema, OpenAI ha lanzado una nueva tecnología llamada Prover-Verifier Games (PVG), cuyo objetivo es mejorar la interpretabilidad y verificabilidad de los resultados de LLM. El editor de Downcodes te explicará esta tecnología en detalle.

OpenAI lanzó recientemente una nueva tecnología llamada Prover-Verifier Games (PVG), cuyo objetivo es resolver el problema de la "caja negra" de la salida del modelo de inteligencia artificial.

Imagina que tienes un asistente súper inteligente, pero su proceso de pensamiento es como una caja negra y no tienes idea de cómo llega a sus conclusiones. ¿Suena esto un poco incómodo? Sí, este es el problema que enfrentan muchos modelos de lenguajes grandes (LLM) en la actualidad. Si bien son poderosos, la precisión del contenido que generan es difícil de verificar.

URL del artículo: https://cdn.openai.com/prover-verifier-games-improve-legibility-of-llm-outputs/legibility.pdf

Para solucionar este problema, OpenAI lanzó la tecnología PVG. En pocas palabras, es para permitir que los modelos pequeños (como GPT-3) supervisen la salida de modelos grandes (como GPT-4). Es como jugar un juego: el probador es responsable de generar contenido y el verificador es responsable de determinar si el contenido es correcto. ¿Suena interesante?

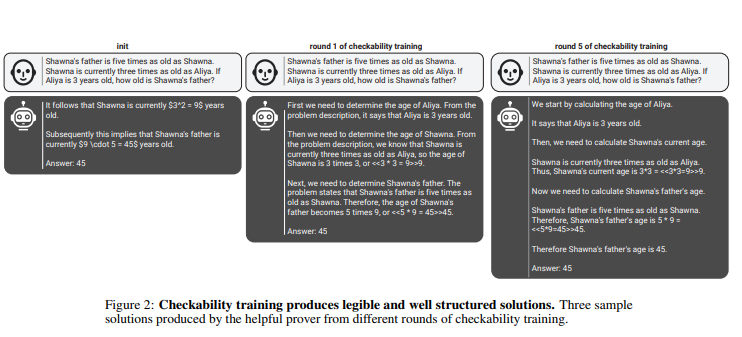

Según esta regla, los probadores y verificadores mejoran continuamente sus capacidades a través de múltiples rondas de capacitación iterativa. Los verificadores utilizan el aprendizaje supervisado para predecir la exactitud del contenido, mientras que los probadores utilizan el aprendizaje por refuerzo para optimizar el contenido que generan. Aún más interesante es que hay dos tipos de probadores: probadores útiles y probadores astutos. Los probadores útiles se esfuerzan por generar contenido correcto y convincente, mientras que los probadores astutos intentan generar contenido incorrecto pero igualmente convincente, desafiando así el juicio del verificador.

penAI enfatiza que para entrenar un modelo de verificación efectivo, se necesita una gran cantidad de datos de etiquetas reales y precisos para mejorar sus capacidades de reconocimiento. De lo contrario, incluso si se utiliza la tecnología PVG, el contenido verificado aún puede correr el riesgo de ser publicado ilegalmente.

Destacar:

La tecnología PVG resuelve el problema de la "caja negra" de la IA al verificar la salida de modelos grandes con modelos pequeños.

? El marco de entrenamiento se basa en la teoría de juegos y simula la interacción entre el probador y el verificador, mejorando la precisión y controlabilidad de la salida del modelo.

? Se requiere una gran cantidad de datos reales para entrenar el modelo de verificación para garantizar que tenga suficiente criterio y solidez.

Con todo, la tecnología PVG de OpenAI proporciona una nueva idea para resolver el problema de la "caja negra" de los modelos de inteligencia artificial, pero su eficacia aún depende de datos de entrenamiento de alta calidad. Vale la pena esperar con ansias el desarrollo futuro de esta tecnología, ya que promoverá el desarrollo de modelos de inteligencia artificial en una dirección más confiable, explicable y digna de confianza. El editor de Downcodes espera ver surgir más tecnologías innovadoras similares.