El campo de la inteligencia artificial cambia cada día que pasa y el razonamiento causal se ha convertido en un tema de investigación candente en los últimos años. Los modelos tradicionales de aprendizaje automático a menudo se quedan cortos en cuanto a razonamiento lógico y les resulta difícil comprender la relación causal detrás de los eventos. Hoy, el editor de Downcodes presentará un artículo de investigación de instituciones como Microsoft y MIT, que propone una innovadora estrategia de capacitación en aprendizaje automático que mejora significativamente las capacidades de razonamiento lógico de modelos grandes, e incluso de modelos Transformer pequeños. Es comparable a GPT-. 4 en capacidad de razonamiento. Echemos un vistazo más de cerca a este impresionante resultado de investigación.

En esta era de explosión de la información, tratamos con dispositivos inteligentes todos los días. ¿Alguna vez te has preguntado cómo estos tipos aparentemente inteligentes saben traer un paraguas cuando está lloviendo? Detrás de esto hay en realidad una profunda revolución en el razonamiento causal.

Un grupo de investigadores de reconocidas instituciones académicas, incluidas Microsoft y MIT, han desarrollado una innovadora estrategia de formación en aprendizaje automático. Esta estrategia no solo supera las deficiencias de los grandes modelos de aprendizaje automático en el razonamiento lógico, sino que también logra mejoras significativas a través de los siguientes pasos:

Método de formación único: los investigadores utilizaron un método de formación novedoso que puede diferir de las técnicas de formación de aprendizaje automático convencionales.

Mejoras en el razonamiento lógico: su enfoque mejora significativamente las capacidades de razonamiento lógico de modelos grandes, resolviendo desafíos previamente existentes.

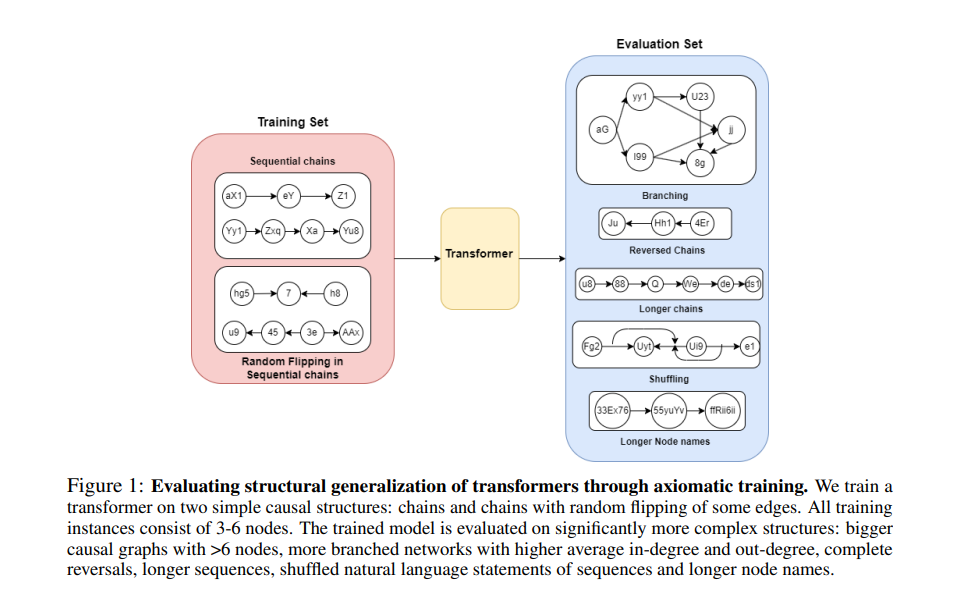

Utilice la causalidad para construir un conjunto de entrenamiento: el equipo de investigación utiliza un modelo de causalidad para construir un conjunto de datos de entrenamiento. Este modelo puede revelar la conexión causal entre variables y ayudar a entrenar un modelo que pueda comprender la lógica causal detrás de los datos.

Enseñan los axiomas básicos del modelo: enseñan directamente las premisas básicas de lógica y matemáticas al modelo para ayudarlo a realizar un mejor razonamiento lógico.

El sorprendente rendimiento del pequeño modelo Transformer: aunque los parámetros del modelo son solo 67 millones, el modelo Transformer entrenado mediante este método es comparable a GPT-4 en términos de capacidades de razonamiento.

El razonamiento causal puede parecer exclusivo de los filósofos, pero en realidad ya ha penetrado en todos los aspectos de nuestras vidas. Para la inteligencia artificial, dominar el razonamiento causal es como aprender a explicar el mundo usando "porque... entonces...". Pero la IA no nace con esto, necesita aprender, y este proceso de aprendizaje es la historia de este artículo.

Método de entrenamiento de axiomas:

Imagina que tienes un estudiante que es muy inteligente pero que no tiene ni idea de la causa y el efecto en el mundo. ¿Cómo se enseña? Los investigadores encontraron una solución: el entrenamiento con axiomas. Esto es como darle a la IA un "manual de causalidad" y permitirle aprender cómo identificar y aplicar reglas causales a través de este manual.

Los investigadores realizaron experimentos con el modelo transformador y descubrieron que este método de entrenamiento realmente funciona. ¡La IA no solo aprendió a identificar relaciones causales en gráficos a pequeña escala, sino que también pudo aplicar este conocimiento a gráficos más grandes, incluso si Nunca antes se había visto un panorama tan grande.

La contribución de esta investigación es que proporciona un nuevo método para que la IA aprenda inferencia causal a partir de datos pasivos. Esto es como darle a la IA una nueva forma de "pensar" para que pueda comprender y explicar mejor el mundo.

Esta investigación no solo nos permite ver la posibilidad de que la IA aprenda el razonamiento causal, sino que también nos abre la puerta a ver posibles escenarios de aplicación de la IA en el futuro. Quizás en un futuro próximo, nuestros asistentes inteligentes no sólo podrán responder preguntas sino también decirnos por qué está sucediendo algo.

Dirección del artículo: https://arxiv.org/pdf/2407.07612v1

En definitiva, esta investigación ha aportado mejoras significativas a las capacidades de razonamiento causal de la inteligencia artificial y ha proporcionado nuevas direcciones y posibilidades para el futuro desarrollo de la IA. El editor de Downcodes espera que esta tecnología se aplique en más campos, permitiendo que la IA comprenda y sirva mejor a los humanos.