La tecnología de generación de imagen a vídeo (I2V) está evolucionando rápidamente con el objetivo de crear vídeos más realistas y controlados. El editor de Downcodes presentará hoy un nuevo marco llamado Motion-I2V, que ha logrado un avance significativo en el campo de la generación I2V a través del modelado de movimiento explícito. Desarrollado por investigadores como Xiaoyu Shi y Zhaoyang Huang, este marco es innovador porque descompone el proceso de conversión de imagen a video en dos etapas y combina inteligentemente la predicción del campo de movimiento y las capas de sincronización de mejora del movimiento para lograr una calidad más alta, más consistente y. Generación de vídeo controlable.

Con el rápido desarrollo de la tecnología de inteligencia artificial, la tecnología de generación de imagen a video (I2V) se ha convertido en un tema de investigación candente. Recientemente, un equipo compuesto por investigadores como Xiaoyu Shi y Zhaoyang Huang introdujo un nuevo marco llamado Motion-I2V, que logra una generación de imagen a video más consistente y controlable a través del modelado de movimiento explícito. Este avance tecnológico no sólo mejora la calidad y consistencia de la generación de video, sino que también brinda a los usuarios una experiencia de control sin precedentes.

En el campo de la generación de imagen a video, cómo mantener la coherencia y controlabilidad de los videos generados siempre ha sido un problema técnico. Los métodos tradicionales I2V aprenden directamente el complejo mapeo de imágenes a videos, mientras que el marco Motion-I2V descompone de manera innovadora este proceso en dos etapas e introduce un modelado de movimiento explícito en ambas etapas.

En la primera etapa, Motion-I2V propone un predictor de campo de movimiento basado en difusión que se centra en derivar las trayectorias de los píxeles de la imagen de referencia. La clave de esta etapa es predecir el mapa del campo de movimiento entre el cuadro de referencia y todos los cuadros futuros utilizando la imagen de referencia y las señales de texto. La segunda etapa es responsable de propagar el contenido de la imagen de referencia al marco compuesto. Al introducir una nueva capa temporal con movimiento aumentado, se mejora la atención temporal unidimensional, se expande el campo receptivo temporal y se alivia la complejidad de aprender directamente patrones espaciotemporales complejos.

En comparación con los métodos existentes, Motion-I2V muestra claras ventajas. Ya sea en escenarios como "un tanque que se mueve rápidamente", "un BMW azul conduciendo rápido", "tres cubitos de hielo transparentes" o un "caracol gateando", Motion-I2V produce vídeos más consistentes, incluso en salidas de alta calidad. Se mantiene bajo una amplia gama de movimientos y cambios de ángulo de visión.

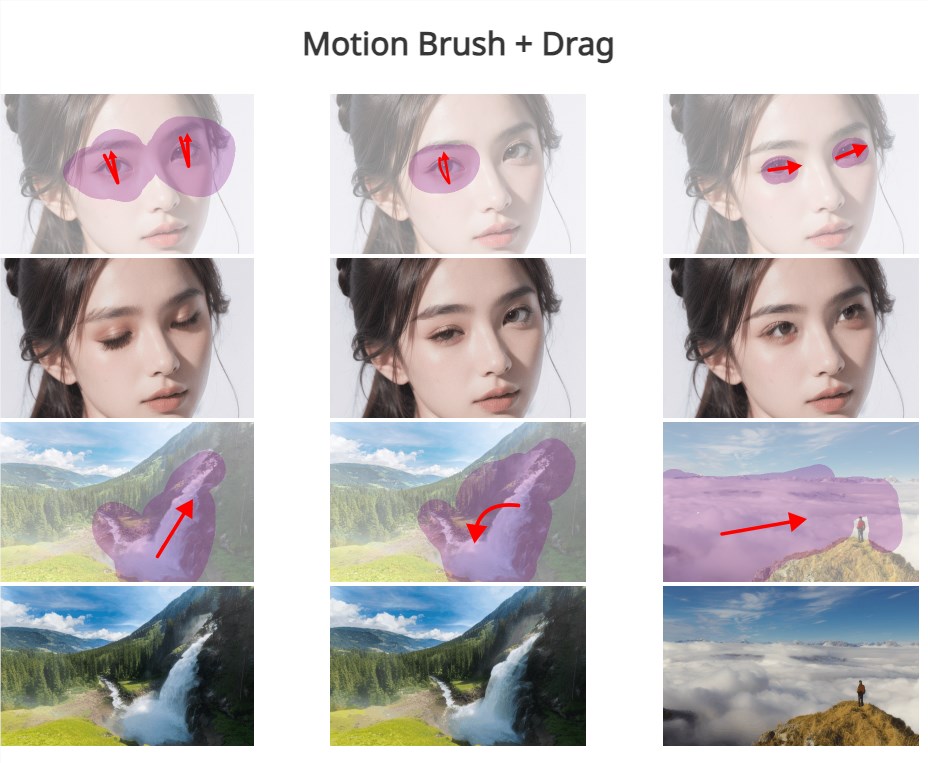

Además, Motion-I2V también permite a los usuarios controlar con precisión las trayectorias y áreas de movimiento a través de trayectorias dispersas y anotaciones de área, proporcionando más capacidades de control que depender únicamente de instrucciones de texto. Esto no sólo mejora la experiencia interactiva del usuario, sino que también brinda la posibilidad de personalizar y personalizar la generación de videos.

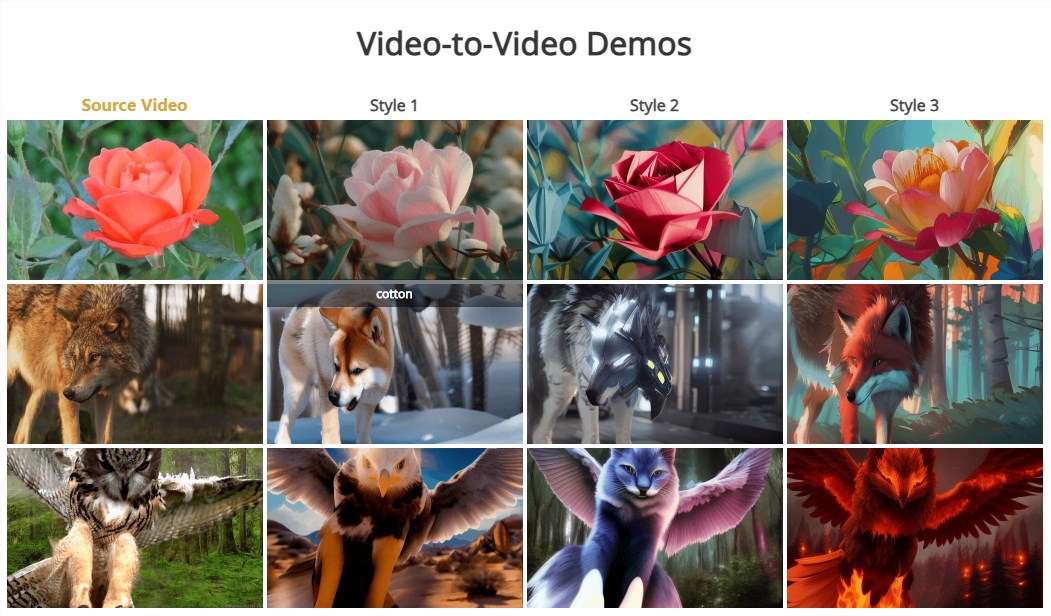

Vale la pena mencionar que la segunda etapa de Motion-I2V también admite naturalmente la conversión de video a video de muestra cero, lo que significa que se puede lograr la conversión de video de diferentes estilos o contenidos sin muestras de entrenamiento.

El lanzamiento del marco Motion-I2V marca una nueva etapa en la tecnología de generación de imagen a video. No sólo logra mejoras significativas en calidad y consistencia, sino que también muestra un gran potencial en el control y personalización del usuario. A medida que la tecnología continúa madurando y mejorando, tenemos razones para creer que Motion-I2V desempeñará un papel importante en la producción de cine y televisión, realidad virtual, desarrollo de juegos y otros campos, brindando a las personas una experiencia visual más rica y vívida.

Dirección del documento: https://xiaoyushi97.github.io/Motion-I2V/

dirección de github: https://github.com/GUN/Motion-I2V

La aparición del marco Motion-I2V ha brindado nuevas posibilidades a la tecnología I2V, y vale la pena esperar sus mejoras en la calidad de generación de video, la consistencia y el control del usuario. En el futuro, con el mayor desarrollo de la tecnología, creo que Motion-I2V se aplicará en más campos y nos brindará una experiencia visual más emocionante. Esperamos más aplicaciones innovadoras basadas en este marco.