Recientemente, la experiencia del usuario del chatbot de IA de Anthropic, Claude, ha provocado acaloradas discusiones. Una gran cantidad de comentarios de usuarios aparecieron en Reddit, diciendo que el rendimiento de Claude ha disminuido, lo que se manifiesta específicamente como pérdida de memoria y disminución de la capacidad de codificación. Este incidente desencadenó debates generalizados sobre la evaluación del desempeño y la experiencia del usuario de grandes modelos de lenguaje, y una vez más destacó los desafíos que enfrentan las empresas de inteligencia artificial para mantener la estabilidad del modelo.

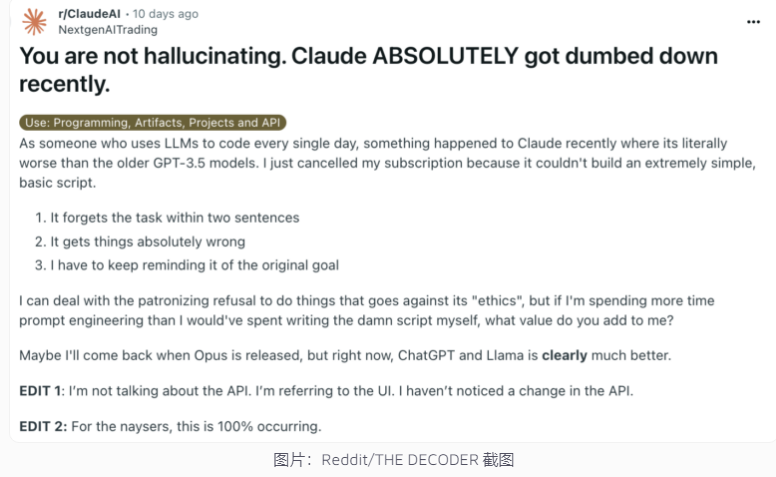

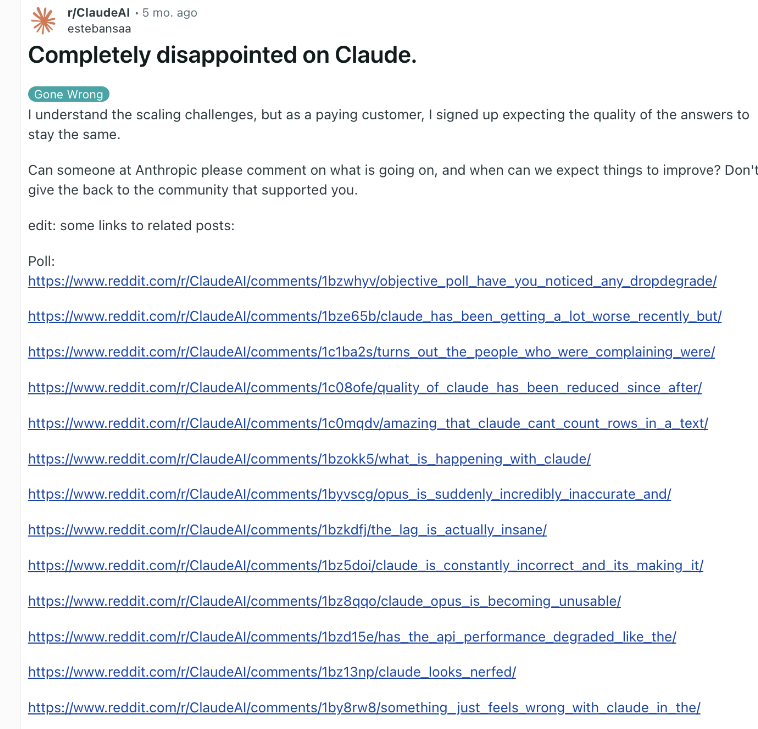

Recientemente, el chatbot de IA de Anthropic, Claude, se ha visto una vez más involucrado en una controversia sobre su desempeño. Una publicación en Reddit que afirmaba que Claude se había vuelto mucho más estúpido atrajo recientemente una atención generalizada, y muchos usuarios informaron que habían experimentado una disminución en las habilidades de Claude, incluida la pérdida de memoria y una disminución en la capacidad de codificación.

En respuesta, el ejecutivo de Anthropic, Alex Albert, respondió que la investigación de la compañía no encontró ningún problema común y confirmó que no se realizaron cambios en el modelo Claude3.5Sonnet ni en el canal de inferencia. Para mejorar la transparencia, Anthropic ha publicado las indicaciones del sistema del modelo Claude en su sitio web oficial.

Esta no es la primera vez que los usuarios informan sobre la degradación de la IA y la empresa lo ha negado. A finales de 2023, ChatGPT de OpenAI también enfrentó dudas similares. Según expertos de la industria, las razones de este fenómeno pueden incluir: las expectativas de los usuarios aumentan con el tiempo, cambios naturales en la producción de IA, limitaciones temporales de los recursos informáticos, etc.

Sin embargo, estos factores aún pueden conducir a una degradación del rendimiento percibida por el usuario incluso si el modelo subyacente no sufre cambios significativos. OpenAI señaló una vez que el comportamiento de la IA en sí es impredecible y que mantener y evaluar el rendimiento de la IA generativa a gran escala es un gran desafío.

Anthropic dijo que seguirá prestando atención a los comentarios de los usuarios y trabajará duro para mejorar la estabilidad del rendimiento de Claude. El incidente destaca los desafíos que enfrentan las empresas de IA para mantener la coherencia del modelo, así como la importancia de aumentar la transparencia en la evaluación y comunicación del desempeño de la IA.

La controversia sobre el rendimiento de Claude refleja la complejidad del desarrollo y la implementación de grandes modelos de lenguaje, así como la brecha entre las expectativas de los usuarios y las aplicaciones reales. En el futuro, las empresas de IA deberán mejorar aún más la estabilidad del modelo y mantener una comunicación más efectiva con los usuarios para garantizar que la tecnología de IA pueda continuar brindando servicios a los usuarios de manera confiable.