El último modelo grande multimodal de uso general de Alibaba, mPLUG-Owl3, ha provocado una tormenta en el campo de la inteligencia artificial con sus poderosas capacidades de comprensión multimodal y su asombrosa eficiencia de razonamiento. Puede comprender 2 horas de contenido de vídeo en 4 segundos y responder con precisión varias preguntas planteadas por los usuarios, demostrando un rendimiento excelente en la comprensión de imágenes, vídeos y textos. Este avance tecnológico no sólo es un hito en el mundo académico, sino que también presagia un cambio futuro en la forma en que la IA interactúa con los humanos.

En esta era de explosión de información, utilizamos imágenes y vídeos para registrar nuestras vidas y compartir nuestra felicidad todos los días. Pero, ¿alguna vez has pensado en lo que pasaría si existiera una tecnología que permitiera a las máquinas no sólo comprender estas imágenes y vídeos como los humanos, sino también comunicarse con nosotros en profundidad?

El último modelo grande multimodal de uso general mPLUG-Owl3 lanzado por el equipo de Alibaba, con su asombrosa eficiencia y capacidad de comprensión, nos permite ver una película de 2 horas en 4 segundos. ¡Esto no es solo un modelo, sino más bien! Es un asistente de IA que puede ver, escuchar, hablar y pensar.

mPLUG-Owl3, el nombre suena como un búho con gafas, inteligente y alerta. Su capacidad principal es la comprensión de largas secuencias de imágenes. Ya sea una serie de fotos o un video, puede comprender el contenido e incluso comprender la trama.

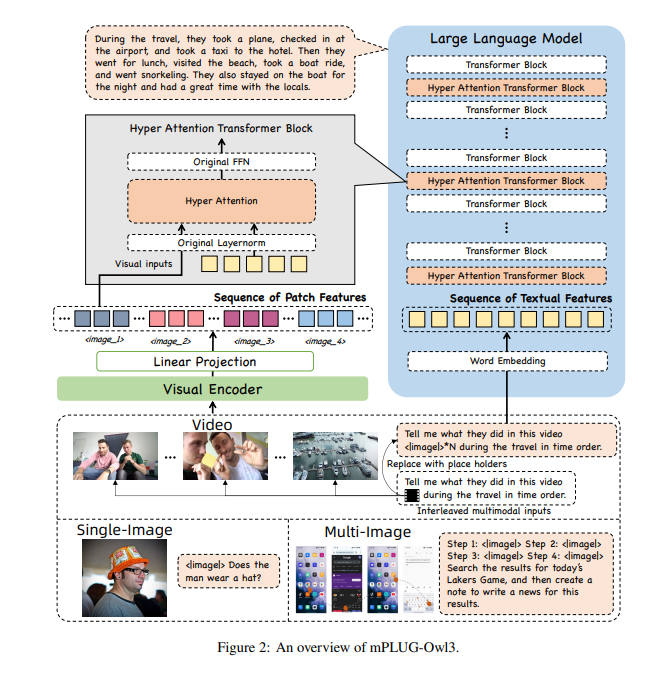

Para permitir que mPLUG-Owl3 procese tanta información, los investigadores lo equiparon con un módulo de hiperatención súper cerebral. Este módulo es como un súper cerebro para la IA, capaz de procesar información visual y lingüística al mismo tiempo, lo que permite a la IA comprender tanto imágenes como información de texto relacionada.

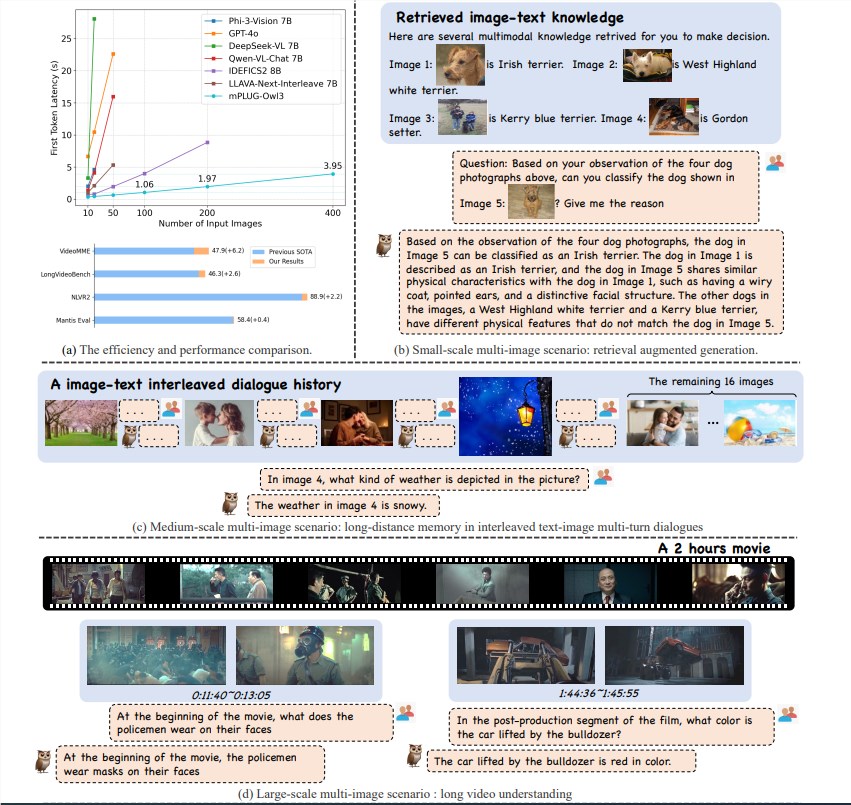

El modelo mPLUG-Owl3 ha logrado un gran avance en el campo de la comprensión multimodal con su excelente eficiencia de razonamiento. No solo alcanza SOTA (Estado del Arte) en puntos de referencia de múltiples escenarios, como imagen única, múltiples imágenes, video, etc., sino que también reduce 6 veces la latencia del primer token y la cantidad de imágenes que se pueden procesar. con una sola tarjeta gráfica A100 aumenta 8 veces, alcanzando las 400 hojas.

mPLUG-Owl3 puede comprender con precisión el conocimiento multimodal entrante y utilizarlo para responder preguntas. Incluso puede decirle en qué conocimiento basa su juicio, así como la base detallada de su juicio.

mPLUG-Owl3 puede comprender correctamente las relaciones de contenido en diferentes materiales y realizar un razonamiento en profundidad. Ya sean diferencias estilísticas o reconocimiento de personajes, lo maneja todo con facilidad.

mPLUG-Owl3 puede ver y comprender videos de hasta 2 horas de duración y puede comenzar a responder preguntas de los usuarios en 4 segundos, sin importar qué parte del video involucre la pregunta.

mPLUG-Owl3 utiliza un módulo ligero Hyper Attention para expandir el Transformer Block en un nuevo módulo capaz de interactuar con características gráficas y de texto y modelar texto. Este diseño reduce en gran medida la cantidad de nuevos parámetros adicionales introducidos, lo que hace que el modelo sea más fácil de entrenar y también se mejora la eficiencia del entrenamiento y la inferencia.

Al experimentar con una amplia gama de conjuntos de datos, mPLUG-Owl3 logra resultados SOTA en la mayoría de los puntos de referencia multimodales de una sola imagen. En evaluaciones de múltiples imágenes, supera a los modelos específicamente optimizados para escenarios de múltiples imágenes. En LongVideoBench, superó a los modelos existentes, mostrando su excelente capacidad para comprender vídeos largos.

El lanzamiento de Alibaba mPLUG-Owl3 no es sólo un salto tecnológico, sino que también ofrece nuevas posibilidades para la aplicación de grandes modelos multimodales. A medida que la tecnología continúa mejorando, esperamos que mPLUG-Owl3 traiga más sorpresas en el futuro.

Dirección del artículo: https://arxiv.org/pdf/2408.04840

Código: https://github.com/X-PLUG/mPLUG-Owl/tree/main/mPLUG-Owl3

Experiencia en línea: https://huggingface.co/spaces/mPLUG/mPLUG-Owl3

La aparición de mPLUG-Owl3 marca una nueva etapa en el desarrollo de la tecnología de modelos grandes multimodales. Sus capacidades de procesamiento eficiente y capacidades de comprensión precisa abren amplias perspectivas para futuras aplicaciones de tecnología de IA. Creo que a medida que la tecnología siga madurando, mPLUG-Owl3 traerá más comodidad y sorpresas a la vida de las personas. Esperamos aplicaciones más innovadoras basadas en mPLUG-Owl3.