La API Anthropic presenta una nueva característica muy esperada: el almacenamiento en caché de sugerencias, que mejorará significativamente la eficiencia y la economía de los modelos Claude. Esta característica permite a los desarrolladores almacenar en caché información contextual de uso frecuente entre llamadas a la API, lo que reduce los cálculos redundantes y reduce el costo y la latencia. Para escenarios de aplicaciones que necesitan procesar grandes cantidades de información contextual, como agentes conversacionales, asistentes de codificación y procesamiento de documentos de gran tamaño, el almacenamiento en caché de sugerencias traerá enormes mejoras de rendimiento. Esta actualización se encuentra actualmente en versión beta pública para Claude3.5 Sonnet y Claude3 Haiku, con planes de expandirse a Claude3 Opus.

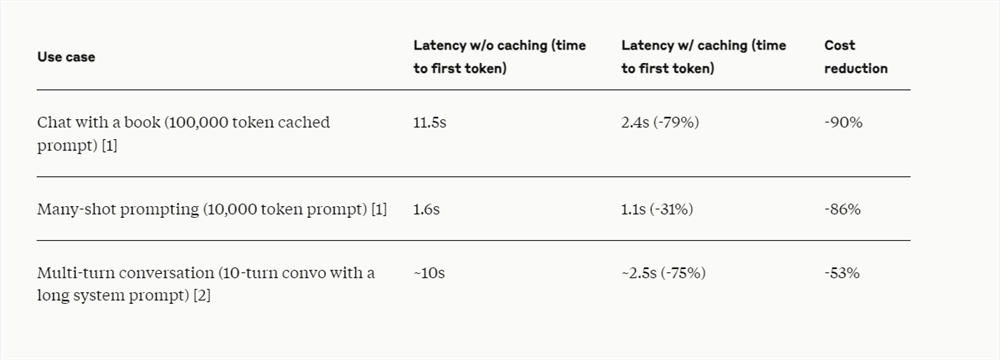

La API Anthropic lanzó recientemente el almacenamiento en caché de mensajes, por lo que los desarrolladores ahora pueden almacenar en caché información contextual de uso común entre llamadas a la API. Con el almacenamiento en caché de sugerencias, los clientes pueden proporcionar a los modelos de Claude más conocimientos previos y resultados de ejemplo, al tiempo que reducen significativamente el costo de las sugerencias largas, reducen las tarifas hasta en un 90 % y reducen la latencia hasta en un 85 %.

Esta función está actualmente disponible en las versiones beta públicas de Claude3.5Sonnet y Claude3Haiku, y también será compatible con Claude3Opus en el futuro.

La función de almacenamiento en caché de avisos es particularmente útil en escenarios donde es necesario hacer referencia repetidamente a una gran cantidad de contextos de avisos en múltiples solicitudes, como en servidores proxy conversacionales para reducir el costo y la latencia de conversaciones largas, especialmente cuando contienen instrucciones complejas o cargas de documentos; El asistente de autocompletar y las preguntas y respuestas sobre la base de código se pueden mejorar conservando una versión resumida de la base de código en el mensaje cuando se trabaja con documentos grandes; el caché del mensaje permite incrustar material completo en formato largo sin aumentar adicionalmente los tiempos de respuesta, para sistemas que involucran múltiples rondas de; llamadas e iteraciones de herramientas Se cambiaron los escenarios de uso de herramientas y búsqueda de proxy, el almacenamiento en caché rápido también puede mejorar significativamente el rendimiento.

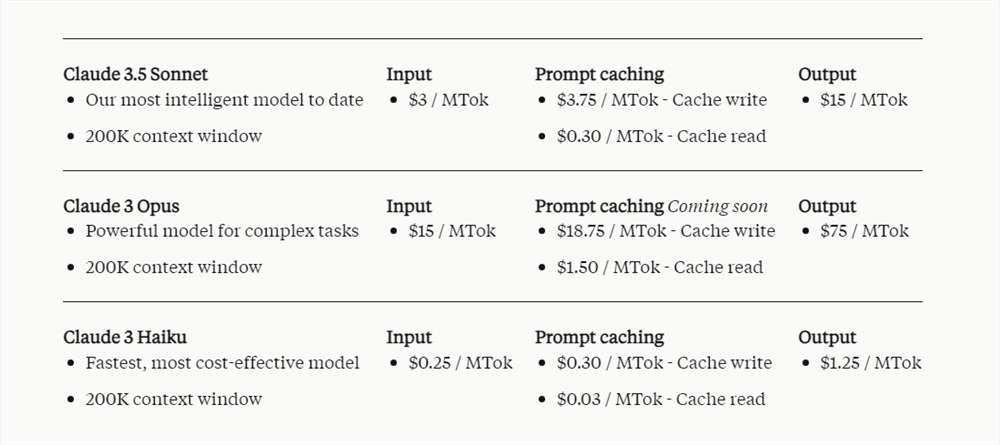

El precio del caché de propinas depende de la cantidad de tokens de entrada almacenados en caché y la frecuencia de uso. Escribir en la caché cuesta un 25% más que el precio base del token de entrada, mientras que usar contenido en caché cuesta significativamente menos, solo el 10% del precio base del token de entrada.

Se informa que Notion, como cliente de Anthropic API, ha integrado la función de almacenamiento en caché de avisos en su asistente de inteligencia artificial Notion AI. Al reducir los costos y aumentar la velocidad, Notion optimiza las operaciones internas y brinda una experiencia más avanzada y rápida a los usuarios.

El lanzamiento de la función de almacenamiento en caché rápido refleja los esfuerzos de Anthropic para optimizar el rendimiento del modelo Claude y reducir los costos de usuario, proporcionando a los desarrolladores soluciones de IA más rentables y mejorando aún más la practicidad del modelo Claude en diversos escenarios de aplicación. Las historias de éxito de Notion también demuestran el valor práctico de esta característica.