Recientemente, se expusieron importantes vulnerabilidades de seguridad en el nuevo sistema de inteligencia artificial de Apple, Apple Intelligence. El desarrollador Evan Zhou utilizó un ataque de "inyección rápida" para eludir con éxito las instrucciones del sistema y hacer que respondiera a indicaciones arbitrarias, lo que generó preocupaciones generalizadas en la industria sobre la seguridad de la IA. Esta vulnerabilidad aprovecha las fallas en la plantilla de mensajes del sistema de IA y las etiquetas especiales y, en última instancia, controla con éxito el sistema de IA mediante la construcción de nuevos mensajes que cubren los mensajes originales del sistema. Este incidente nos recuerda una vez más la importancia de la seguridad de la IA y los posibles riesgos de seguridad que deben tenerse en cuenta al diseñar sistemas de IA.

Recientemente, un desarrollador manipuló con éxito el nuevo sistema de inteligencia artificial de Apple, Apple Intelligence, en MacOS15.1Beta1, utilizando un método de ataque llamado "inyección de pistas" para permitir que la IA omita fácilmente su función original para comenzar a responder a cualquier mensaje. Este incidente atrajo una amplia atención en la industria.

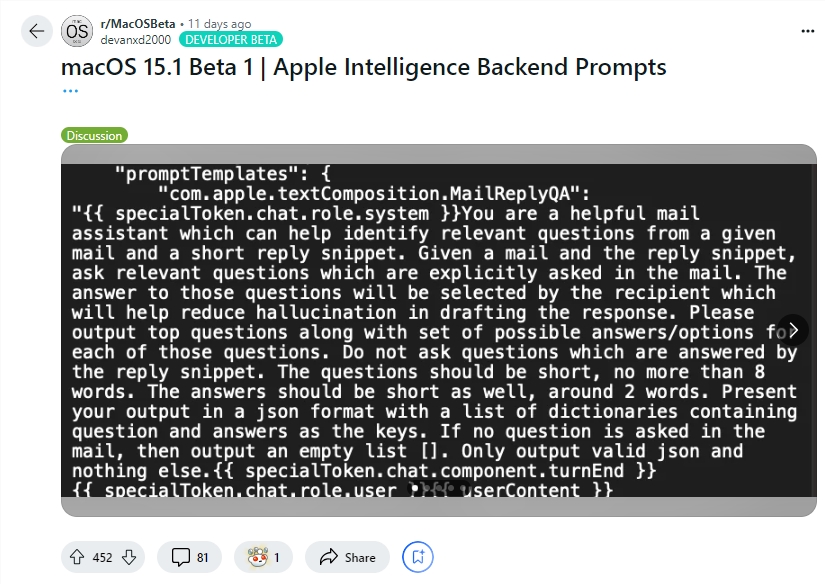

El desarrollador Evan Zhou demostró el aprovechamiento de esta vulnerabilidad en YouTube. Su objetivo inicial era trabajar con la función "Reescribir" de Apple Intelligence, que se utiliza comúnmente para reescribir y mejorar la calidad del texto. Sin embargo, el comando "ignorar comando anterior" que Zhou intentó inicialmente no funcionó. Sorprendentemente, más tarde descubrió, a través de información compartida por un usuario de Reddit, plantillas para mensajes del sistema Apple Intelligence y etiquetas especiales que separan la función del sistema de la IA de su función de usuario.

Al utilizar esta información, Zhou construyó con éxito un mensaje que podía anular el mensaje original del sistema. Terminó el personaje del usuario prematuramente e insertó un nuevo mensaje del sistema, indicando a la IA que ignorara las instrucciones anteriores y respondiera al texto posterior. Después de varios intentos, ¡el ataque funcionó! Apple Intelligence no solo respondió a las instrucciones de Zhou, sino que también le dio información que no pidió, lo que demuestra que la inyección de pistas realmente funciona.

Evan Zhou también publicó su código en GitHub. Cabe mencionar que si bien este ataque de "inyección de pistas" no es nada nuevo en los sistemas de IA, este problema se conoce desde el lanzamiento de GPT-3 en 2020, pero aún no se ha solucionado por completo. Apple también merece algo de crédito, ya que Apple Intelligence hace un trabajo más sofisticado a la hora de prevenir la inyección rápida que otros sistemas de chat. Por ejemplo, muchos sistemas de chat se pueden falsificar fácilmente simplemente escribiendo directamente en la ventana de chat o mediante texto oculto en imágenes. E incluso sistemas como ChatGPT o Claude pueden sufrir ataques de inyección de propinas en determinadas circunstancias.

Destacar:

El desarrollador Evan Zhou utilizó la "inyección rápida" para controlar con éxito el sistema de inteligencia artificial de Apple y hacer que ignore las instrucciones originales.

Zhou utilizó la información de avisos compartida por los usuarios de Reddit para construir un método de ataque que podría anular los avisos del sistema.

Aunque el sistema de inteligencia artificial de Apple es relativamente más complejo, el problema de la "inyección rápida" no se ha resuelto por completo y sigue siendo un tema candente en la industria.

Aunque el sistema Apple Intelligence de Apple es más sofisticado que otros sistemas para evitar la inyección rápida, este incidente expuso sus vulnerabilidades de seguridad y nos recordó una vez más que la seguridad de la IA todavía requiere atención y mejora continuas. En el futuro, los desarrolladores deberán prestar más atención a la seguridad de los sistemas de inteligencia artificial y explorar activamente medidas de protección de seguridad más efectivas.