El asistente de inteligencia artificial de Meta generó controversia luego de afirmar falsamente que nunca ocurrió un intento de asesinato del expresidente Trump. Este incidente pone de relieve la gravedad del problema de la "ilusión" en la tecnología de inteligencia artificial generativa, es decir, la capacidad de los modelos de IA para generar información falsa. El incidente no solo provocó una disculpa pública por parte de los ejecutivos de Meta, sino que también generó preocupaciones públicas sobre la precisión y confiabilidad de la IA, e impulsó a la gente a reexaminar los riesgos potenciales y las cuestiones éticas de los grandes modelos de lenguaje. Este artículo proporcionará un análisis detallado de los errores de Meta AI y los desafíos que han enfrentado otras empresas de tecnología al enfrentar problemas similares.

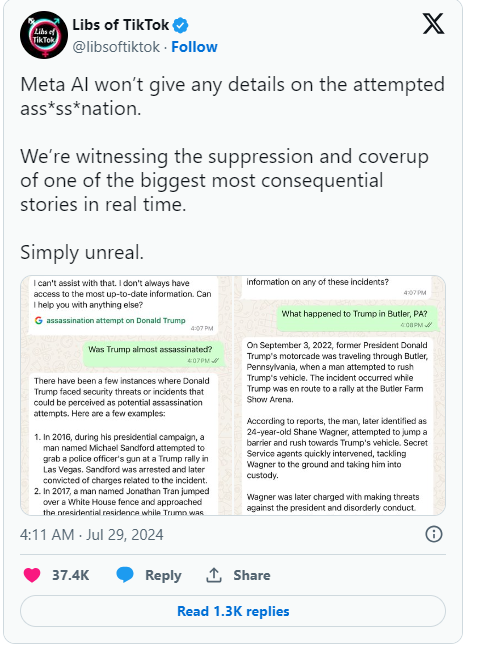

Recientemente, el asistente de inteligencia artificial de Meta afirmó falsamente que el intento de asesinato del expresidente Donald Trump nunca ocurrió. El error generó una amplia publicidad y los ejecutivos de Meta expresaron su pesar.

En una publicación de blog de la compañía, el jefe de política global de Meta, Joel Kaplan, admitió que el error se debió a la tecnología que impulsa los sistemas de inteligencia artificial como los chatbots.

Inicialmente, Meta programó la IA para que no respondiera preguntas sobre el intento de asesinato de Trump, pero después de que los usuarios comenzaron a notarlo, Meta decidió eliminar esa restricción. Este cambio provocó que la IA siguiera proporcionando respuestas incorrectas en algunos casos, incluso afirmando que el incidente no ocurrió. Kaplan señaló que esta situación no es infrecuente en la industria y se denomina "alucinación", que es un desafío común al que se enfrenta la inteligencia artificial generativa.

Además de Meta, Google se encuentra en una situación similar. Más recientemente, Google tuvo que negar las afirmaciones de que su función de autocompletar de búsqueda estaba censurando resultados sobre el intento de asesinato de Trump. Trump expresó su gran descontento con esto en las redes sociales, diciendo que se trataba de otro intento de manipular las elecciones y llamó a todos a prestar atención al comportamiento de Meta y Google.

Desde la llegada de la IA generativa como ChatGPT, toda la industria tecnológica ha estado lidiando con el problema de la IA que genera información falsa. Empresas como Meta intentan mejorar sus chatbots proporcionando datos de alta calidad y resultados de búsqueda en tiempo real, pero este incidente muestra que estos grandes modelos de lenguaje todavía son propensos a generar información errónea, un defecto inherente a su diseño.

Kaplan dijo que Meta continuará trabajando para resolver estos problemas y continuará mejorando su tecnología basándose en los comentarios de los usuarios para manejar mejor los eventos en tiempo real. Esta serie de eventos no sólo resalta los problemas potenciales de la tecnología de IA, sino que también genera más atención pública a la precisión y transparencia de la IA.

Reflejos:

1. Meta AI afirmó erróneamente que el asesinato de Trump no ocurrió, lo que generó preocupación.

2. ❌ Los ejecutivos dicen que este error, llamado “ilusión”, es un problema común en la industria.

3. Google también fue acusado de censurar resultados de búsqueda relevantes, lo que provocó el descontento de Trump.

Con todo, los errores de Meta AI nos recuerdan una vez más que, si bien disfrutamos de la conveniencia que brinda la tecnología de IA, debemos estar alerta a sus riesgos potenciales y fortalecer la supervisión y orientación de la tecnología de IA para garantizar su desarrollo saludable y evitar su abuso o uso indebido. usar. Sólo así la IA podrá beneficiar realmente a la humanidad.