En el campo del desarrollo de software, la aplicación de herramientas de codificación de IA está desencadenando una revolución silenciosa. Los equipos de desarrollo utilizan ampliamente la codificación asistida por IA. Sin embargo, la dirección de la empresa carece de supervisión y control efectivos sobre el uso de las herramientas de IA. Esto desencadenó un "juego del gato y el ratón" entre los desarrolladores y la administración con respecto a la aplicación de herramientas de inteligencia artificial y los riesgos de seguridad resultantes.

En el mundo de la tecnología, existe un juego del gato y el ratón entre los desarrolladores y la dirección. Los protagonistas de este juego son aquellas herramientas de codificación de IA que están explícitamente prohibidas por la empresa pero que los desarrolladores aún utilizan silenciosamente.

Aunque el 15% de las empresas prohíbe explícitamente el uso de herramientas de codificación de IA, casi todos los equipos de desarrollo (99%) las utilizan, según una nueva investigación global de la empresa de seguridad en la nube Checkmarx. Este fenómeno revela los desafíos para controlar el uso de la IA generativa.

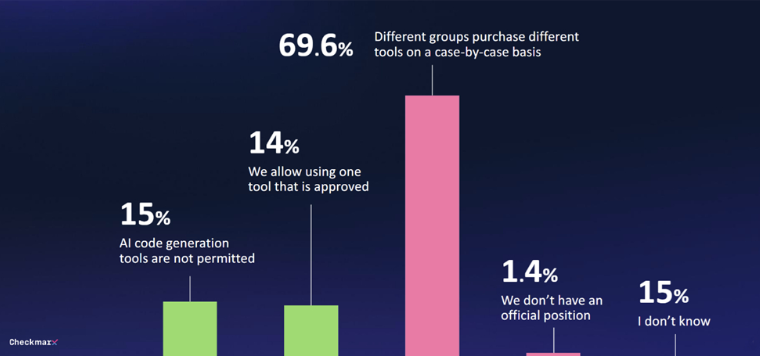

Solo el 29% de las empresas cuenta con alguna forma de gobernanza para las herramientas de IA generativa. En el 70% de los casos no existe una estrategia unificada y las decisiones de compra se toman ad hoc por varios departamentos. Esta situación dificulta que la dirección controle el uso de herramientas de codificación de IA.

Con la popularidad de las herramientas de codificación de IA, los problemas de seguridad se han vuelto cada vez más prominentes. El 80% de los encuestados están preocupados por las amenazas potenciales que los desarrolladores pueden traer al usar la IA, especialmente el 60% que expresa preocupación por las "alucinaciones" causadas por la IA.

A pesar de las preocupaciones, el interés en el potencial de la IA sigue siendo fuerte. El 47% de los encuestados está dispuesto a permitir que la IA realice cambios de código sin supervisión. Sólo el 6% dijo que no confiaría en las medidas de seguridad de la IA en entornos de software.

"Las respuestas de estos CISO globales revelan la realidad de que los desarrolladores están utilizando IA en el desarrollo de aplicaciones incluso si no pueden crear código seguro de manera confiable usando IA, lo que significa que los equipos de seguridad deben lidiar con una avalancha de ataques nuevos y vulnerables", dijo Tzruya. ".

Un informe reciente del Índice de tendencias laborales de Microsoft mostró hallazgos similares, y muchos empleados utilizan sus propias herramientas de inteligencia artificial cuando no se les proporciona ninguna. A menudo no discuten este uso, lo que dificulta la integración sistemática de la IA generativa en los procesos de negocio.

A pesar de las prohibiciones explícitas, el 99% de los equipos de desarrollo todavía utilizan herramientas de inteligencia artificial para generar código. Sólo el 29% de las empresas ha establecido mecanismos de gobernanza para el uso de la IA generativa. En el 70% de los casos, las decisiones sobre el uso de herramientas de IA por parte de varios departamentos se toman ad hoc. Al mismo tiempo, aumentan las preocupaciones por la seguridad. El 47% de los encuestados está dispuesto a permitir que la IA realice cambios de código sin supervisión. Los equipos de seguridad se enfrentan al desafío de lidiar con grandes cantidades de código generado por IA potencialmente vulnerable.

Este "juego del gato y el ratón" entre los desarrolladores y la administración continúa, y tendremos que esperar y ver hacia dónde va el futuro de las herramientas de codificación de IA.

La aplicación de herramientas de codificación de IA se ha convertido en una tendencia, pero no se pueden ignorar los riesgos de seguridad que conlleva. Las empresas deben establecer un mecanismo de gobernanza sólido para equilibrar las mejoras de eficiencia aportadas por la IA con los riesgos potenciales de seguridad para poder adaptarse mejor a esta ola tecnológica.