El último modelo RWKV-CLIP de código abierto de Green Deep Learning ha demostrado un sólido rendimiento en el campo del aprendizaje de representación del lenguaje visual con su diseño innovador que integra la arquitectura Transformer y RNN. Este modelo resuelve eficazmente el problema de los datos ruidosos y mejora significativamente la solidez del modelo y el rendimiento de las tareas posteriores al combinar inteligentemente una arquitectura de torre gemela, módulos de mezcla espacial y de canales, y un marco de generación de descripciones diverso. Ha logrado grandes avances en la comparación y comprensión de imágenes y textos, proporcionando una nueva dirección para la investigación y aplicación de modelos de lenguaje visual.

Gelingshentong ha abierto el modelo RWKV-CLIP, que es un alumno de representación de lenguaje visual que combina las ventajas de Transformer y RNN. El modelo mejora significativamente el rendimiento en tareas visuales y de lenguaje al ampliar el conjunto de datos utilizando pares de imagen y texto obtenidos de sitios web mediante tareas de preentrenamiento de imágenes y texto.

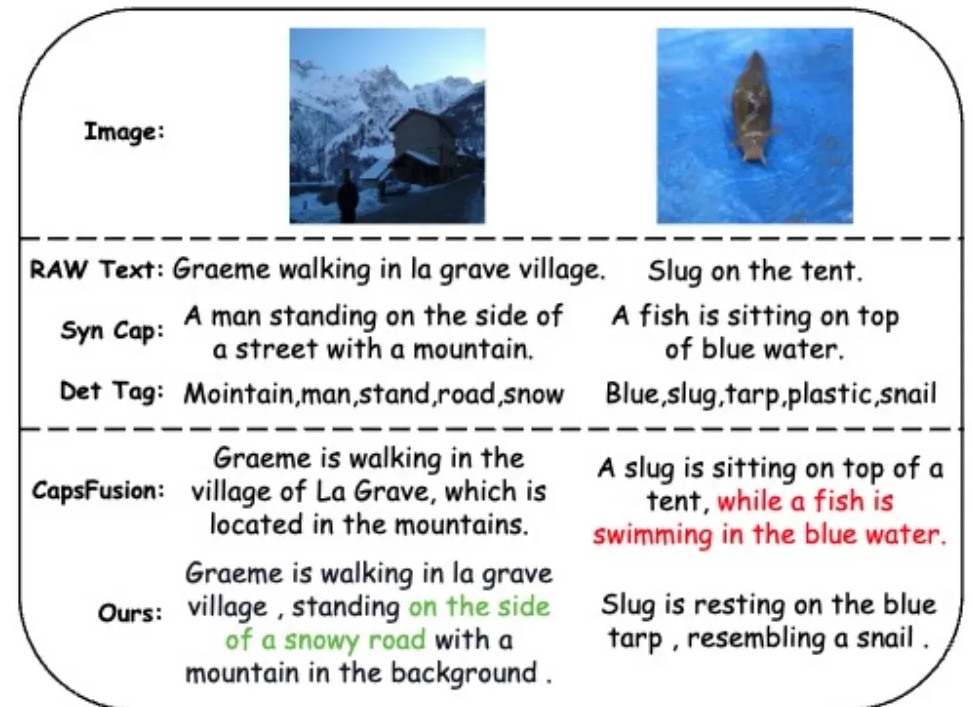

Para abordar el problema de los datos ruidosos y mejorar la calidad de los datos, el equipo de investigación introdujo un marco de generación de descripciones diversas que aprovecha los modelos de lenguaje grande (LLM) para sintetizar y refinar el contenido a partir de texto basado en la web, subtítulos sintetizados y etiquetas detectadas.

El modelo RWKV-CLIP adopta una arquitectura de torre gemela, que integra el entrenamiento paralelo efectivo de Transformer y la inferencia eficiente de RNN. El modelo está apilado por múltiples módulos de combinación espacial y de combinación de canales, que permiten el procesamiento en profundidad de imágenes y texto de entrada. En la etapa de mezcla espacial, el modelo utiliza el mecanismo de atención para realizar cálculos de complejidad lineal global y fortalecer la interacción de características a nivel de canal. La etapa de combinación de canales refina aún más la representación de funciones. En términos de mejora de la entrada, el modelo RWKV-CLIP mejora la solidez del modelo al seleccionar aleatoriamente texto original, subtítulos sintéticos o descripciones generadas como entrada de texto.

Los resultados experimentales muestran que RWKV-CLIP logra un rendimiento de vanguardia en múltiples tareas posteriores, incluida la detección lineal, la clasificación de disparo cero y la recuperación de texto de imágenes de disparo cero. En comparación con el modelo básico, RWKV-CLIP logra importantes mejoras de rendimiento.

El análisis intermodal del modelo RWKV-CLIP muestra que sus representaciones aprendidas exhiben una discriminabilidad más clara dentro de la misma modalidad y exhiben distancias más cercanas en el espacio de modalidad imagen-texto, lo que indica un mejor rendimiento de alineación entre modalidades.

Dirección del modelo: https://wisemodel.cn/models/deepglint/RWKV-CLIP

Con todo, el modelo RWKV-CLIP muestra un gran potencial en el campo del lenguaje visual y su código abierto también proporciona recursos valiosos para investigaciones relacionadas. Los desarrolladores interesados pueden visitar el enlace proporcionado para descargar el modelo y realizar más investigaciones y aplicaciones.