ARC-AGI, un punto de referencia diseñado para evaluar las capacidades de abstracción y razonamiento de la inteligencia artificial general (AGI), ha avanzado recientemente, pero su creador, Francois Cholet, nos recuerda que esto no significa que la AGI se esté acercando. Señaló que el rendimiento de los sistemas de inteligencia artificial actuales en la prueba ARC-AGI todavía está muy por debajo de las expectativas, y la razón principal son las limitaciones de los modelos de lenguaje grande (LLM), que son mejores en el reconocimiento de patrones que en el verdadero razonamiento. Sholay y sus colaboradores lanzaron un concurso de 1 millón de dólares para promover avances en IA de código abierto en ARC-AGI, pero los resultados también confirmaron que la prueba en sí puede tener deficiencias y necesitar más mejoras.

Desde su lanzamiento en 2019, ARC-AGI ha sido el foco de atención en el campo de la inteligencia artificial. Aunque el sistema de IA logró algunos avances en las pruebas, sus puntuaciones aún estaban muy por debajo de los niveles humanos. Esto ha provocado una reflexión sobre la dirección actual del desarrollo de la IA y ha llevado a los investigadores a reexaminar la definición y los métodos de evaluación de la AGI. El artículo analiza en detalle las limitaciones de las pruebas ARC-AGI, así como las perspectivas para futuras direcciones de investigación de AGI, y muestra resultados relevantes de la competencia y las estrategias de afrontamiento de los investigadores.

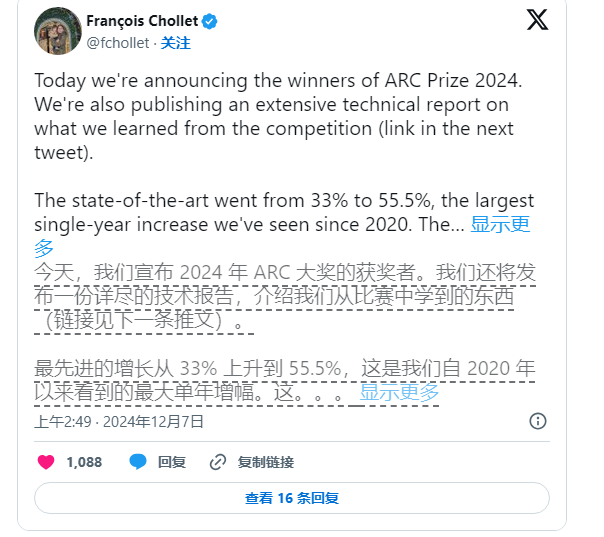

Aun así, Sholay no ha dejado de impulsar la investigación en IA. Él y el fundador de Zapier, Mike Knoop, lanzaron conjuntamente un concurso de 1 millón de dólares en junio de este año para alentar a la IA de código abierto a desafiar el punto de referencia ARC-AGI. Aunque el sistema de IA con mejor rendimiento obtuvo sólo un 55,5% de 17.789 entradas, por debajo de la marca del 85% necesaria para lograr el "rendimiento humano", Sholay y Knoop todavía lo ven como un paso importante.

Knoop señaló en una publicación de blog que este logro no significa que estemos más cerca de realizar AGI. En cambio, resalta que algunas tareas en ARC-AGI dependen demasiado de soluciones de "fuerza bruta" y pueden no proporcionar señales efectivas para un verdadero general. inteligencia. ARC-AGI se diseñó originalmente para probar la capacidad de generalización de la IA proporcionando tareas complejas nunca antes vistas. Sin embargo, todavía existen dudas sobre si estas tareas pueden evaluar la AGI de manera efectiva.

Nota sobre la fuente de la imagen: la imagen es generada por IA y la imagen está autorizada por el proveedor de servicios Midjourney

Las tareas en el punto de referencia ARC-AGI involucran problemas de acertijos, etc., que requieren que la IA infiera respuestas desconocidas basadas en información conocida. Aunque estas tareas parecen promover la adaptación de la IA a nuevas situaciones, los resultados muestran que los modelos existentes parecen encontrar soluciones a través de una gran cantidad de cálculos y no necesariamente demuestran una verdadera adaptabilidad inteligente.

Además, los creadores de ARC-AGI han enfrentado críticas de sus pares, particularmente con respecto a la ambigüedad que rodea la definición de AGI. Un empleado de OpenAI afirmó recientemente que si AGI se define como inteligencia artificial que "se desempeña mejor que la mayoría de los humanos en la mayoría de las tareas", entonces AGI realmente se ha logrado. Sin embargo, Cholet y Knoop sostienen que los diseños existentes para el punto de referencia ARC-AGI aún no han logrado completamente este objetivo.

En el futuro, Sholay y Knoop planean lanzar un punto de referencia ARC-AGI de segunda generación y celebrarán una nueva competencia en 2025 para abordar las deficiencias de la prueba actual. Dijeron que el nuevo punto de referencia se centrará más en promover el desarrollo de la investigación de IA en una dirección más importante y acelerar la implementación de AGI.

Sin embargo, corregir los puntos de referencia existentes no es una tarea fácil. Los esfuerzos de Sholay y Knoop muestran que definir la inteligencia en inteligencia artificial, especialmente en el campo de la inteligencia general, sigue siendo una tarea difícil y compleja.

Con todo, el progreso del punto de referencia ARC-AGI y las discusiones relacionadas reflejan que la exploración de la inteligencia artificial general en el campo de la inteligencia artificial aún está en curso, con avances y desafíos en el futuro, definiciones más rigurosas y evaluaciones más efectivas. Se necesitan métodos para promover el desarrollo real de la AGI.