ByteDance Doubao Big Model Team ha lanzado un nuevo punto de referencia de evaluación de modelos grandes de código: FullStack Bench. Este punto de referencia cubre 11 escenarios de la vida real, 16 lenguajes de programación y 3374 preguntas. En comparación con los estándares de evaluación anteriores, FullStack Bench puede funcionar mejor. Evaluación precisa de las capacidades de desarrollo de código para modelos grandes. Examina los datos de Stack Overflow y la IA y los humanos lo validan de forma cruzada para garantizar la confiabilidad y amplitud de los datos. Al mismo tiempo, el equipo también abrió la herramienta de código sandbox SandboxFusion para facilitar a los desarrolladores la realización de pruebas de modelos grandes.

El 5 de diciembre, el equipo de modelos grandes de Byte Doubao lanzó el último punto de referencia de evaluación de modelos de código grande: FullStack Bench, que cubre más de 11 tipos de escenarios reales, admite 16 lenguajes de programación y contiene 3374 preguntas. Este punto de referencia puede evaluar con mayor precisión las capacidades de desarrollo de código de modelos grandes en una gama más amplia de campos de programación que los estándares de evaluación anteriores y promueve la optimización de modelos en tareas de programación del mundo real.

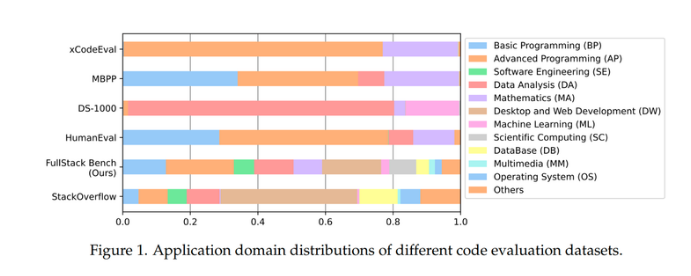

Los puntos de referencia actuales de evaluación de código, como HumanEval y MBPP, generalmente se centran en problemas de programación básicos y avanzados, mientras que DS-1000 se centra en análisis de datos y tareas de aprendizaje automático, y solo es compatible con Python. xCodeEval se centra en programación y matemáticas avanzadas y tiene grandes escenarios de aplicación y limitaciones de cobertura de lenguaje. Por el contrario, FullStack Bench ha mejorado significativamente la cobertura de datos, cubriendo más de 11 áreas de aplicación y cubriendo escenarios de programación más complejos y diversos.

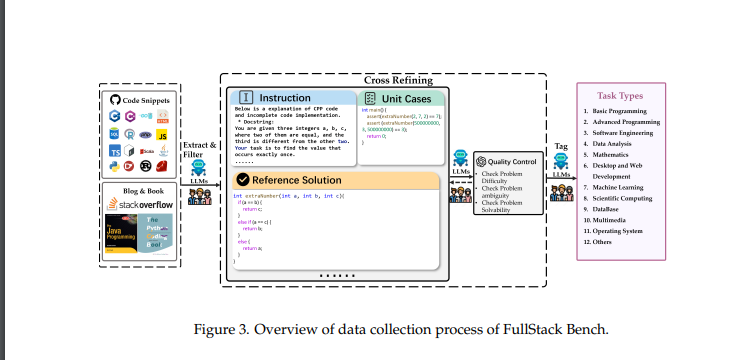

El conjunto de datos de FullStack Bench proviene de Stack Overflow, la plataforma de preguntas y respuestas de programación más grande del mundo. El equipo de investigación seleccionó el 88,1% de los campos de aplicación principales entre 500.000 preguntas, lo que garantiza la amplitud y solidez del conjunto de datos. Cada pregunta incluye una descripción detallada del problema, soluciones de referencia y casos de prueba unitaria para garantizar la precisión de la evaluación. El equipo también realizó una evaluación cruzada de la calidad de los datos mediante IA y revisión manual para mejorar aún más la confiabilidad de los datos.

Para facilitar que los desarrolladores utilicen este conjunto de datos, el equipo de Byte Doubao también ha abierto la herramienta de código abierto SandboxFusion para respaldar la ejecución eficiente de tareas de programación en varios idiomas. SandboxFusion es compatible con más de 10 conjuntos de datos de evaluación de código ampliamente utilizados y admite 23 lenguajes de programación, lo que ayuda a los desarrolladores a probar fácilmente modelos grandes en diferentes entornos.

Además, el equipo de modelos grandes de Byte Doubao también demostró por primera vez su modelo de código grande de desarrollo propio, Doubao-Coder, y evaluó las capacidades de programación de más de 20 modelos de código grande en todo el mundo. El progreso continuo de Byte en el campo de la programación de IA, especialmente a través de su modelo base de código de desarrollo propio MarsCode, aporta millones de códigos a los usuarios cada mes, lo que demuestra su posición de liderazgo en este campo.

Dirección de código abierto del conjunto de datos: https://huggingface.co/datasets/ByteDance/FullStackBench

Dirección de código abierto de Sandbox: https://github.com/bytedance/SandboxFusion

Dirección del artículo: https://arxiv.org/pdf/2412.00535v2

El lanzamiento de FullStack Bench y el código abierto de herramientas relacionadas marcan el progreso significativo de ByteDance en el campo del código de IA y han hecho importantes contribuciones para promover la evaluación y el desarrollo de grandes modelos de código. Los desarrolladores pueden utilizar estos recursos para mejorar el rendimiento de sus propios modelos y promover el avance de la tecnología de código de IA.