Los modelos de lenguaje visual (VLM) han logrado avances significativos en el campo de la inteligencia artificial, pero aún enfrentan desafíos en el procesamiento de imágenes de alta resolución y textos diversos. Los modelos existentes suelen utilizar codificadores visuales estáticos, que son ineficientes y carecen de precisión en diferentes conjuntos de datos. La falta de diversidad y especificidad de las tareas en el conjunto de datos de entrenamiento también limita su rendimiento, especialmente en tareas de dominio especializado como la interpretación de gráficos.

Con el rápido desarrollo de la inteligencia artificial, la integración de capacidades visuales y lingüísticas ha llevado a avances revolucionarios en los modelos de lenguaje visual (VLM). Estos modelos están diseñados para procesar y comprender datos visuales y de texto simultáneamente, y se utilizan ampliamente en escenarios como descripción de imágenes, respuesta visual a preguntas, reconocimiento óptico de caracteres y análisis de contenido multimodal.

Los VLM han desempeñado un papel importante en el desarrollo de sistemas autónomos, una interacción mejorada entre humanos y computadoras y herramientas eficientes de procesamiento de documentos, cerrando con éxito la brecha entre estas dos modalidades de datos. Sin embargo, todavía existen muchos desafíos en el procesamiento de datos visuales de alta resolución y diversas entradas de texto.

La investigación actual ha abordado parcialmente estas limitaciones, pero los codificadores visuales estáticos adoptados por la mayoría de los modelos carecen de adaptabilidad a altas resoluciones y tamaños de entrada variables. Al mismo tiempo, la combinación de modelos de lenguaje previamente entrenados con codificadores visuales a menudo resulta en ineficiencias porque no están optimizados para tareas multimodales. Aunque algunos modelos introducen escasas técnicas informáticas para gestionar la complejidad, la precisión de diferentes conjuntos de datos sigue siendo insuficiente. Además, los conjuntos de datos de entrenamiento de los modelos existentes a menudo carecen de diversidad y especificidad de tareas, lo que limita aún más su rendimiento. Por ejemplo, muchos modelos funcionan mal en tareas especializadas como la interpretación de gráficos o el análisis de documentos densos.

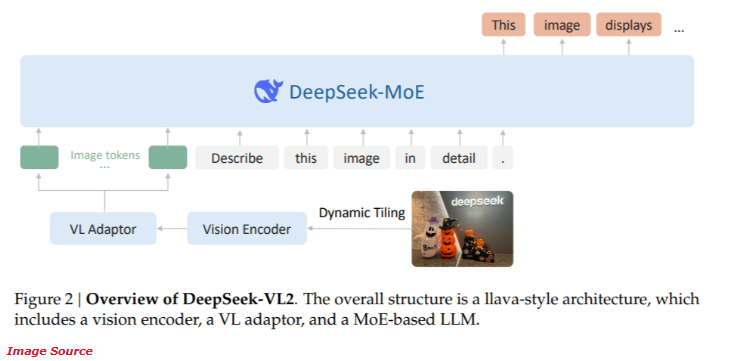

Recientemente, DeepSeek-AI lanzó la nueva serie DeepSeek-VL2 de modelos de lenguaje visual de expertos híbridos (MoE) de código abierto. Esta serie de modelos combina tecnologías innovadoras de vanguardia, incluida la división dinámica de codificación visual, el mecanismo de atención latente de múltiples cabezales y el marco DeepSeek-MoE.

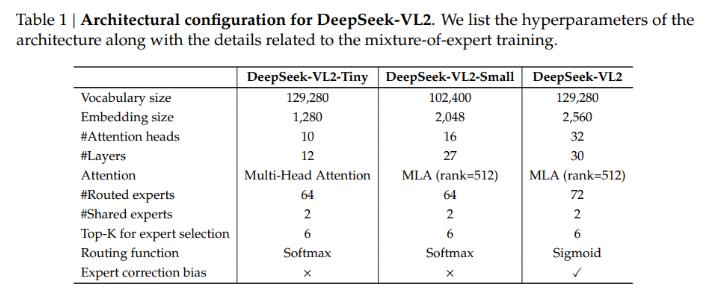

La serie DeepSeek-VL2 proporciona tres configuraciones de parámetros diferentes:

- DeepSeek-VL2-Tiny: 3,37 mil millones de parámetros (mil millones de parámetros de activación)

- DeepSeek-VL2-Small: 16,1 mil millones de parámetros (2,8 mil millones de parámetros de activación)

- DeepSeek-VL2: 27,5 mil millones de parámetros (4,5 mil millones de parámetros de activación)

Esta escalabilidad garantiza su capacidad para adaptarse a diferentes necesidades de aplicaciones y presupuestos informáticos.

La arquitectura de DeepSeek-VL2 está diseñada para optimizar el rendimiento y al mismo tiempo reducir los requisitos computacionales. El método de corte dinámico garantiza que las imágenes de alta resolución se procesen sin perder detalles críticos, lo que lo hace ideal para análisis de documentos y tareas de localización visual. Además, el mecanismo de atención latente de múltiples cabezas permite que el modelo procese eficientemente grandes cantidades de datos de texto, reduciendo la sobrecarga computacional típicamente asociada con el procesamiento de entradas de lenguaje denso. La capacitación de DeepSeek-VL2 cubre diversos conjuntos de datos multimodales, lo que le permite desempeñarse bien en una variedad de tareas como el reconocimiento óptico de caracteres, la respuesta visual a preguntas y la interpretación de gráficos.

Según las pruebas de rendimiento, la configuración Pequeña logró una precisión del 92,3% en la tarea de reconocimiento óptico de caracteres, superando significativamente a los modelos existentes. En la prueba comparativa de posicionamiento visual, el modelo mejoró la precisión en un 15 % en comparación con el producto de la generación anterior.

Al mismo tiempo, DeepSeek-VL2 reduce los requisitos de recursos informáticos en un 30 % manteniendo al mismo tiempo una precisión de última generación. Estos resultados demuestran la superioridad de este modelo en el procesamiento de imágenes y textos de alta resolución.

Entrada del proyecto: https://huggingface.co/collections/deepseek-ai/deepseek-vl2-675c22accc456d3beb4613ab

Reflejos:

La serie DeepSeek-VL2 proporciona una variedad de configuraciones de parámetros para adaptarse a las diferentes necesidades de las aplicaciones.

La tecnología de corte dinámico mejora la eficiencia del procesamiento de imágenes de alta resolución y es adecuada para el análisis de documentos complejos.

El modelo funciona bien en tareas de reconocimiento óptico de caracteres y localización visual, con una precisión significativamente mejorada.

Los modelos de la serie DeepSeek-VL2 han aportado nuevos avances al campo de los modelos de lenguaje visual con su arquitectura innovadora y excelente rendimiento. Sus ventajas en el procesamiento de imágenes de alta resolución y texto complejo hacen que muestre un gran potencial en muchos escenarios de aplicación y merezca más atención e investigación.