IBM anunció el lanzamiento de su modelo de lenguaje grande de código abierto de nueva generación Granite3.1, con el objetivo de liderar el campo de la IA a nivel empresarial. Granite3.1 tiene muchos aspectos destacados, incluida una longitud de contexto ampliada a 128 K, modelos de incrustación eficientes, capacidades integradas de detección de alucinaciones y un rendimiento general significativamente mejorado. Según IBM, su modelo Granite8B Instruct funciona mejor entre los modelos de código abierto de la misma escala, superando a competidores como Llama3.1 de Meta, Qwen2.5 y Gemma2 de Google. El lanzamiento de este nuevo modelo sigue al lanzamiento de Granite 3.0 en octubre, lo que refleja la rápida iteración y la inversión continua de IBM en el campo de la IA generativa, con ingresos comerciales relacionados que alcanzan los 2 mil millones de dólares.

IBM lanzó oficialmente su nueva generación de modelo de lenguaje grande de código abierto Granite3.1, esforzándose por ocupar una posición de liderazgo en el campo de la IA a nivel empresarial. Esta serie de modelos presenta una longitud de contexto ampliada de 128 KB, modelos integrados, capacidades integradas de detección de alucinaciones y mejoras significativas en el rendimiento.

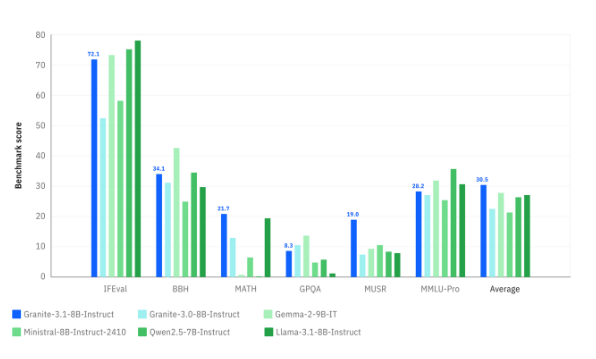

IBM afirma que el modelo Granite8B Instruct funciona mejor entre competidores de código abierto del mismo tamaño, incluidos Llama3.1 de Meta, Qwen2.5 y Gemma2 de Google.

El lanzamiento del modelo Granite3.1 se produce en el contexto de la rápida iteración de la serie Granite3.0 de IBM que se lanzó ya en octubre. IBM reveló que sus ingresos comerciales relacionados con la generación de IA han alcanzado los 2 mil millones de dólares. La idea central de la nueva versión es integrar más funciones en un modelo más pequeño para que pueda ejecutarse de manera más fácil y rentable para los usuarios comerciales.

David Cox, vicepresidente de IBM Research, dijo que el modelo Granite se usa ampliamente en los productos internos, servicios de consultoría y servicios al cliente de IBM, y también se lanza en forma de código abierto, por lo que debe alcanzar un alto nivel en todos los aspectos. La evaluación del desempeño del modelo se basa no solo en la velocidad sino también en la eficiencia, lo que ayuda a los usuarios a ahorrar tiempo al obtener resultados.

En términos de longitud del contexto, la mejora de Granite3.1 es particularmente obvia, extendiéndose desde la primera versión de 4K a 128K, lo cual es particularmente importante para los usuarios de IA empresarial, especialmente en términos de generación mejorada de recuperación (RAG) y IA de agente inteligente. La longitud de contexto extendida permite que el modelo procese documentos, registros y conversaciones más largos, lo que le permite comprender y responder mejor a consultas complejas.

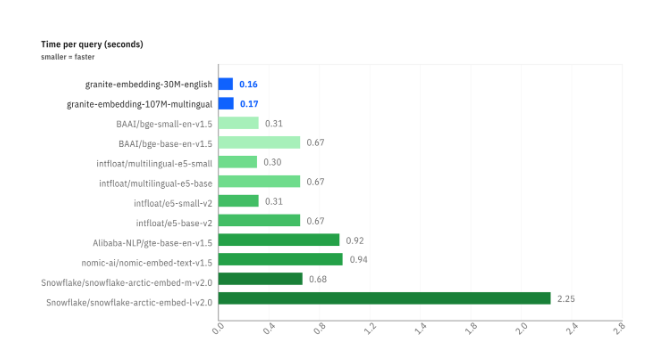

IBM también ha lanzado una serie de modelos de integración para acelerar el proceso de conversión de datos en vectores. Entre ellos, el tiempo de consulta del modelo Granite-Embedding-30M-English es de 0,16 segundos, que es más rápido que el de los productos de la competencia. Para lograr la mejora del rendimiento de Granite3.1, IBM ha innovado en el proceso de capacitación de múltiples etapas y el uso de datos de capacitación de alta calidad.

En términos de detección de alucinaciones, el modelo Granite3.1 integra protección contra alucinaciones en el modelo, que puede autodetectar y reducir los resultados falsos. Esta detección incorporada optimiza la eficiencia general y reduce la cantidad de llamadas de inferencia.

Actualmente, el modelo Granite3.1 está abierto a usuarios empresariales de forma gratuita y se proporciona a través del servicio de IA empresarial Watsonx de IBM. En el futuro, IBM planea mantener un ritmo rápido de actualizaciones y Granite 3.2 lanzará una funcionalidad multimodal a principios de 2025.

Blog oficial: https://www.ibm.com/new/announcements/ibm-granite-3-1-powerful-performance-long-context-and-more

Destacar:

IBM lanzó el modelo Granite3.1 con el objetivo de tomar una posición de liderazgo en el mercado de modelos de lenguajes grandes de código abierto.

El nuevo modelo admite una longitud de contexto de 128 K, lo que mejora significativamente las capacidades de procesamiento y la eficiencia.

Las capacidades de detección de ilusiones están integradas en el modelo, optimizando el rendimiento y la precisión generales.

Con todo, el lanzamiento de Granite3.1 marca otro avance importante para IBM en el campo de los modelos de lenguajes grandes de código abierto. Su potente rendimiento y sus ricas funciones brindarán una experiencia de IA más conveniente y eficiente a los usuarios empresariales. Vale la pena esperar futuras iteraciones.