La startup china de inteligencia artificial DeepSeek ha lanzado su último modelo ultragrande DeepSeek-V3, que se ha convertido en el foco de la industria con su código fuente abierto y su potente rendimiento. Con parámetros 671B y una arquitectura híbrida experta, DeepSeek-V3 supera a los principales modelos de código abierto en múltiples pruebas e incluso funciona de manera similar a algunos modelos de código cerrado. Su innovación radica en su estrategia auxiliar de equilibrio de carga sin pérdidas y su tecnología de predicción de múltiples tokens, que mejora significativamente la eficiencia del entrenamiento del modelo y la velocidad de carrera. El lanzamiento de DeepSeek-V3 marca un gran avance en la tecnología de IA de código abierto, reduciendo aún más la brecha con la IA de código cerrado y allanando el camino para el desarrollo de la inteligencia artificial general (AGI).

El 26 de diciembre de 2024, la startup china de inteligencia artificial DeepSeek lanzó su último modelo ultragrande DeepSeek-V3, conocido por su tecnología de código abierto y sus desafíos innovadores que lideran a los proveedores de inteligencia artificial. DeepSeek-V3 tiene parámetros 671B y utiliza una arquitectura mixta de expertos para activar parámetros específicos para manejar una tarea determinada de manera precisa y eficiente. Según los puntos de referencia proporcionados por DeepSeek, este nuevo modelo ha superado a los principales modelos de código abierto, incluido Llama3.1-405B de Meta, y tiene un rendimiento similar al de los modelos cerrados de Anthropic y OpenAI.

El lanzamiento de DeepSeek-V3 marca una mayor reducción de la brecha entre la IA de código abierto y la IA de código cerrado. DeepSeek, que comenzó como una rama del fondo de cobertura cuantitativo chino High-Flyer Capital Management, espera que estos desarrollos allanen el camino para la inteligencia artificial general (AGI), donde los modelos podrán comprender o aprender cualquier tarea intelectual que un ser humano pueda realizar. .

Las características principales de DeepSeek-V3 incluyen:

Al igual que su predecesor DeepSeek-V2, el nuevo modelo se basa en la arquitectura básica de atención latente de múltiples cabezas (MLA) y DeepSeekMoE, lo que garantiza un entrenamiento e inferencia eficientes.

La compañía también lanzó dos innovaciones: una estrategia auxiliar de equilibrio de carga sin pérdidas y Predicción de múltiples tokens (MTP), que permite a los modelos predecir múltiples tokens futuros simultáneamente, mejorando la eficiencia del entrenamiento y permitiendo que los modelos se ejecuten tres veces más rápido, por generar 60 tokens por segundo. .

En la fase previa al entrenamiento, DeepSeek-V3 se entrenó en 14.8T de tokens diversos y de alta calidad y realizó una expansión de la longitud del contexto en dos etapas, y finalmente realizó un entrenamiento posterior con ajuste fino supervisado (SFT) y aprendizaje por refuerzo (RL). para alinear el modelo con las preferencias humanas y desbloquear aún más su potencial.

En la fase de capacitación, DeepSeek utiliza una variedad de optimizaciones de hardware y algoritmos, incluido el marco de capacitación de precisión mixta FP8 y el algoritmo DualPipe para la paralelización de tuberías, lo que reduce los costos de capacitación. Se afirma que todo el proceso de entrenamiento de DeepSeek-V3 se completa en 2788K horas de GPU H800 o aproximadamente $ 5,57 millones, que es mucho menos que los cientos de millones de dólares que normalmente se gastan en el entrenamiento previo de grandes modelos de lenguaje.

DeepSeek-V3 se ha convertido en el modelo de código abierto más potente del mercado. Múltiples pruebas comparativas realizadas por la compañía mostraron que superó al GPT-4o de código cerrado en la mayoría de las pruebas, excepto en SimpleQA y FRAMES, centrados en inglés, donde el modelo OpenAI lideró con puntuaciones de 38,2 y 80,5 respectivamente (las puntuaciones de DeepSeek-V3 son 24,9 y 73,3). respectivamente). DeepSeek-V3 tuvo un desempeño particularmente bueno en los puntos de referencia de chino y matemáticas, con una puntuación de 90,2 en la prueba Math-500, seguido por el 80 de Qwen.

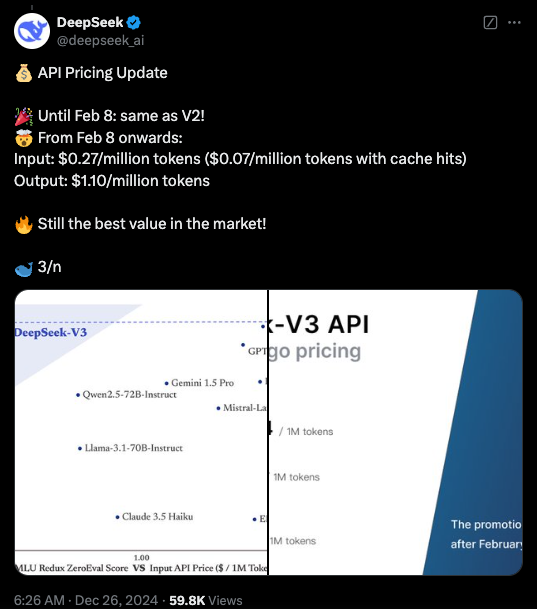

Actualmente, el código de DeepSeek-V3 está disponible bajo una licencia MIT en GitHub y el modelo se proporciona bajo la licencia de modelo de la empresa. Las empresas también pueden probar nuevos modelos a través de DeepSeek Chat, una plataforma similar a ChatGPT, y acceder a API para uso comercial. DeepSeek proporcionará la API al mismo precio que DeepSeek-V2 hasta el 8 de febrero. Después de eso, se cobrarán tarifas de $0,27 por millón de tokens de entrada ($0,07 por millón de tokens para visitas de caché) y $1,10 por millón de tokens de salida.

Destacar:

Se lanza DeepSeek-V3, con un rendimiento que supera a Llama y Qwen.

Adopte parámetros 671B y una arquitectura híbrida experta para mejorar la eficiencia.

Las innovaciones incluyen estrategias de equilibrio de carga sin pérdidas y predicción de múltiples tokens para mejorar la velocidad.

Los costos de capacitación se reducen significativamente, lo que promueve el desarrollo de la IA de código abierto.

El código abierto y el alto rendimiento de DeepSeek-V3 tendrán un profundo impacto en el campo de la inteligencia artificial, promoverán el desarrollo de la tecnología de inteligencia artificial de código abierto y promoverán su aplicación en diversos campos. DeepSeek seguirá trabajando en el desarrollo de modelos de IA más avanzados y contribuirá a la realización de AGI. En el futuro, tenemos motivos para esperar más avances de DeepSeek.