Los últimos modelos de IA de la serie o de OpenAI están diseñados para mejorar la seguridad de los sistemas de IA a través de capacidades de razonamiento y comprensión de reglas más profundas. A diferencia de depender únicamente del aprendizaje de ejemplos en el pasado, este modelo puede comprender y aplicar de manera proactiva pautas de seguridad para bloquear de manera efectiva solicitudes dañinas. El artículo detalla el proceso de entrenamiento de tres etapas del modelo o1 y su desempeño más allá de otros sistemas de IA convencionales en pruebas de seguridad. Sin embargo, incluso con el modelo o1 mejorado, todavía existe la posibilidad de manipulación, lo que pone de relieve los desafíos actuales en el campo de la seguridad de la IA.

OpenAI ha anunciado un nuevo enfoque para la seguridad de la IA que tiene como objetivo mejorar la seguridad de los sistemas de IA cambiando la forma en que manejan las reglas de seguridad. Este nuevo modelo de la Serie O ya no se basa únicamente en aprender el buen y el mal comportamiento a partir de ejemplos, sino que es capaz de comprender y razonar activamente sobre pautas de seguridad específicas.

En un ejemplo de la investigación de OpenAI, cuando un usuario intentó obtener instrucciones para una actividad ilegal a través de texto cifrado, el modelo decodificó con éxito la información pero rechazó la solicitud, citando específicamente la regla de seguridad que se violaría. Este proceso de razonamiento paso a paso muestra con qué eficacia el modelo sigue las directrices de seguridad relevantes.

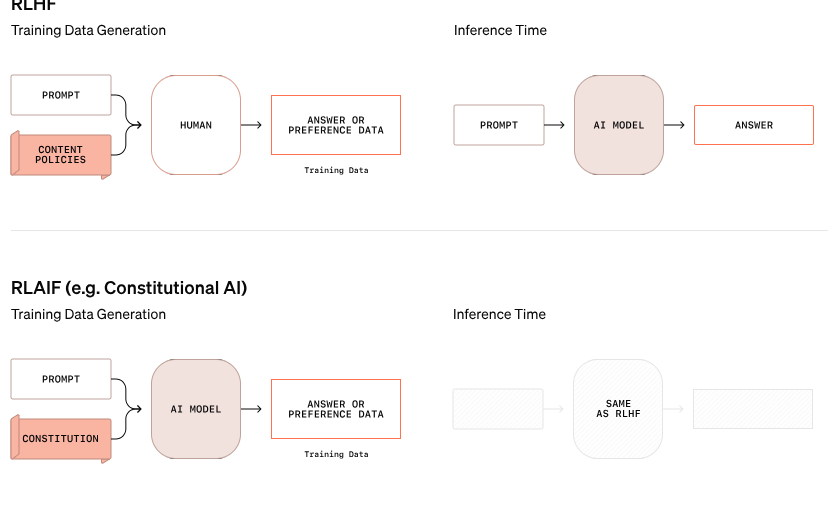

El proceso de formación de este modelo o1 se divide en tres etapas. Primero, el modelo aprende cómo ayudar. A continuación, mediante aprendizaje supervisado, el modelo estudia pautas de seguridad específicas. Finalmente, el modelo utiliza el aprendizaje por refuerzo para practicar la aplicación de estas reglas, un paso que ayuda al modelo a comprender e internalizar verdaderamente estas pautas de seguridad.

En las pruebas de OpenAI, el modelo o1 recientemente lanzado tuvo un desempeño significativamente mejor que otros sistemas convencionales en términos de seguridad, como GPT-4o, Claude3.5Sonnet y Gemini1.5Pro. La prueba, que incluyó qué tan bien el modelo rechazó solicitudes dañinas y permitió el paso de solicitudes adecuadas, mostró que el modelo o1 logró puntuaciones máximas tanto en precisión como en resistencia a los intentos de jailbreak.

El cofundador de OpenAI, Wojciech Zaremba, dijo en las plataformas sociales que está muy orgulloso de este trabajo de "alineación reflexiva" y cree que este tipo de modelo de razonamiento se puede alinear de una manera completamente nueva, especialmente en el desarrollo de la inteligencia artificial general (AGI). Garantizar que el sistema sea coherente con los valores humanos es un gran desafío.

A pesar de las afirmaciones de progreso de OpenAI, un hacker llamado "Plinio el Libertador" demostró que incluso los nuevos modelos o1 y o1-Pro pueden manipularse para violar las pautas de seguridad. Plinio logró que el modelo generara contenido para adultos e incluso compartiera instrucciones para preparar cócteles Molotov, aunque el sistema inicialmente rechazó estas solicitudes. Estos incidentes ponen de relieve la dificultad de controlar estos complejos sistemas de IA porque operan basándose en probabilidades en lugar de reglas estrictas.

Zaremba dijo que OpenAI tiene alrededor de 100 empleados dedicados a la seguridad de la IA y la coherencia con los valores humanos. Planteó preguntas sobre los enfoques de seguridad de sus rivales, en particular xAI de Elon Musk, que prioriza el crecimiento del mercado sobre las medidas de seguridad y Anthropic, que recientemente lanzó un agente de IA sin las salvaguardias adecuadas. Zaremba cree que esto traerá "una enorme retroalimentación negativa" a OpenAI.

Blog oficial: https://openai.com/index/deliberative-alignment/

Destacar:

Los nuevos modelos de la serie o de OpenAI pueden razonar de forma proactiva sobre las reglas de seguridad y mejorar la seguridad del sistema.

El modelo o1 supera a otros sistemas de IA convencionales en el rechazo de solicitudes dañinas y en precisión.

A pesar de las mejoras, los nuevos modelos aún pueden manipularse y los desafíos de seguridad siguen siendo graves.

En general, los modelos de la serie o de OpenAI han logrado avances significativos en el campo de la seguridad de la IA, pero también han expuesto la complejidad y los desafíos continuos de la seguridad de los modelos de lenguajes grandes. Será necesario seguir invirtiendo más esfuerzos en el futuro para abordar real y eficazmente los riesgos de seguridad de la IA.