El equipo de Kunlun Wanwei Yan Shuicheng colaboró con la Universidad Tecnológica de Nanyang en Singapur para lanzar un proyecto innovador llamado Q*, cuyo objetivo es mejorar significativamente las capacidades de razonamiento de modelos de lenguaje pequeños. A diferencia de otros modelos de lenguajes grandes en el mercado, Q* se enfoca en mejorar el rendimiento de los modelos pequeños, haciendo que sus capacidades de razonamiento sean comparables a modelos con parámetros docenas o incluso cientos de veces más grandes. Se espera que el resultado de esta investigación cambie las limitaciones de los modelos pequeños en aplicaciones prácticas y brinde nuevas oportunidades de desarrollo al campo de la inteligencia artificial. A través de algoritmos innovadores, Q* ha mejorado significativamente las capacidades de razonamiento de los modelos pequeños y ha logrado excelentes resultados superando a los modelos grandes en múltiples pruebas comparativas.

Recientemente, el equipo nacional Kunlun Wanwei Yan Shuicheng y el equipo de investigación de la Universidad Tecnológica de Nanyang en Singapur lanzaron un proyecto llamado Q*, cuyo objetivo es mejorar las capacidades de razonamiento de modelos pequeños. Este proyecto es diferente de OpenAI, pero puede permitir que modelos pequeños alcancen las capacidades de razonamiento de modelos con parámetros que son docenas o incluso cientos de veces mayores que él.

El equipo de investigación logró resultados notables gracias al rendimiento experimental del algoritmo Q*: en el conjunto de datos GSM8K, Q* ayudó a Llama-2-7b a mejorar hasta una precisión del 80,8%, superando a ChatGPT.

En el conjunto de datos MATH, Q* ayudó a DeepSeek-Math-7b a mejorar hasta una precisión del 55,4%, superando a Gemini Ultra.

En el conjunto de datos MBPP, Q * ayudó a CodeQwen1.5-7b-Chat a aumentar la precisión al 77,0 %, reduciendo la brecha en el nivel de programación con GPT-4. Estos resultados muestran el potencial del algoritmo Q* para mejorar las capacidades de razonamiento de modelos pequeños.

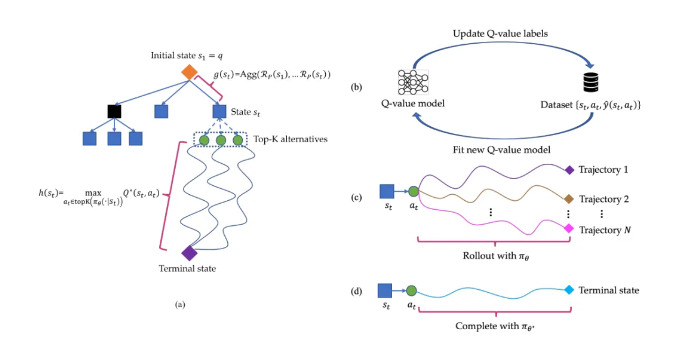

El principio de funcionamiento del algoritmo Q* es descomponer la trayectoria de razonamiento del modelo de lenguaje grande en varios estados, realizar una planificación general para cada estado y utilizar el algoritmo de búsqueda A* para lograr una búsqueda prioritaria para tareas de razonamiento complejas. Al mismo tiempo, también entrenaron un modelo de valor Q del agente mediante aprendizaje supervisado para obtener el valor Q óptimo del par estado-acción, mejorando así el rendimiento del modelo.

Destacar:

OpenAI no publica el proyecto Q *. A través del algoritmo del equipo de investigación, la capacidad de razonamiento del modelo pequeño ha mejorado enormemente.

El proyecto logró resultados experimentales notables en múltiples conjuntos de datos, lo que demuestra el potencial y la eficacia del algoritmo Q*.

Enlace del artículo: https://arxiv.org/abs/2406.14283

Los resultados de la investigación del proyecto Q* proporcionan una nueva dirección para el desarrollo de modelos pequeños. Su algoritmo eficiente y su importante efecto de mejora son dignos de atención. En el futuro, se espera que este algoritmo se aplique en más campos y promueva el avance de la tecnología de inteligencia artificial. Se ha proporcionado un enlace al artículo para que los lectores interesados conozcan más detalles.