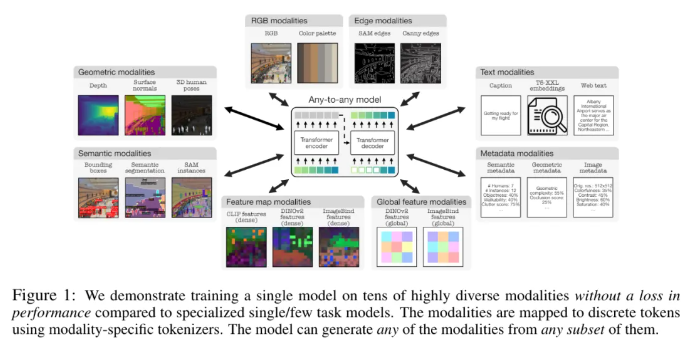

Apple y la Ecole Polytechnique Fédérale de Lausanne (EPFL) en Suiza han colaborado para desarrollar un modelo multimodal innovador, 4M-21. El modelo se puede entrenar en 21 modalidades diferentes, su rendimiento es significativamente mejor que el de los modelos existentes y realiza múltiples funciones, como la recuperación intermodal y la generación controlable. Esta investigación mejoró enormemente el rendimiento y la adaptabilidad del modelo al expandir el tamaño del modelo y del conjunto de datos, aumentar el tipo y la cantidad de modalidades de capacitación y adoptar una estrategia de capacitación conjunta. El modelo 4M-21 adopta una arquitectura de codificador-decodificador basada en Transformer y agrega incorporaciones modales adicionales para adaptarse a nuevas modalidades. Su proceso de capacitación considera completamente las características de diferentes modalidades y utiliza un método de tokenización específico para modal.

Este estudio adoptó una solución de preentrenamiento de 4M, que puede mejorar el rendimiento y la adaptabilidad del modelo al expandir el tamaño del modelo y los conjuntos de datos, aumentar el tipo y la cantidad de modalidades involucradas en el entrenamiento del modelo y realizar un entrenamiento conjunto en múltiples conjuntos de datos. Los investigadores utilizan diferentes métodos de tokenización para discretizar modalidades con diferentes características, como incrustaciones de imágenes globales, poses humanas e instancias semánticas. En términos de selección de arquitectura, este estudio adopta la arquitectura codificador-decodificador 4M basada en Transformer y agrega incorporaciones modales adicionales para adaptarse a nuevas modalidades.

Este modelo no solo puede realizar una serie de tareas de visión comunes listas para usar, como estimación de profundidad y normal de superficie DIODE, segmentación de instancias y semántica COCO, estimación de pose humana 3DPW3D, etc., sino que también puede generar modalidades de entrenamiento arbitrarias y admitir varias Se realiza una generación detallada y multimodal, y se pueden recuperar imágenes RGB u otras modalidades utilizando otras modalidades como consultas. Además, los investigadores también realizaron experimentos de transmisión multimodal en NYUv2, segmentación semántica Hypersim y ARKitScenes.

Sus características funcionales importantes incluyen:

Modalidades cualquiera a cualquiera: aumentó de 7 modalidades del mejor modelo cualquiera a cualquiera existente a 21 modalidades diferentes, lo que permite la recuperación intermodal, la generación controlable y un potente rendimiento listo para usar.

Soporte de diversidad: agregue soporte para datos más estructurados, como poses humanas, instancias SAM, metadatos y más.

Tokenización: estudie la tokenización discreta para diferentes modalidades utilizando métodos específicos de cada modalidad, como incrustaciones de imágenes globales, poses humanas e instancias semánticas.

Escalado: amplíe el tamaño del modelo a 3 mil millones de parámetros y el conjunto de datos a 0,5 mil millones de muestras.

Formación colaborativa: formación colaborativa sobre visión y lenguaje al mismo tiempo.

Dirección del artículo: https://arxiv.org/pdf/2406.09406

Destacar:

- Investigadores de Apple y la Ecole Polytechnique Fédérale de Lausanne (EPFL) en Suiza desarrollaron conjuntamente un modelo único de modalidad cualquiera que se puede entrenar en 21 modalidades diferentes.

- El modelo puede realizar una variedad de tareas de visión comunes listas para usar y también es capaz de generar modalidades de entrenamiento arbitrarias, admitiendo varios métodos para realizar una generación multimodal y detallada.

- Los investigadores también realizaron experimentos de transmisión multimodal en NYUv2, segmentación semántica Hypersim y ARKitScenes.

En definitiva, el modelo 4M-21 ha logrado avances significativos en el campo de la investigación multimodal. Su potente rendimiento y amplias perspectivas de aplicación proporcionan una nueva dirección para el desarrollo futuro de la inteligencia artificial multimodal. Vale la pena esperar con ansias el código abierto y las aplicaciones futuras de este modelo.