Equipos de investigación de la Universidad de Nanjing, la Universidad de Fudan y el Laboratorio Arca de Noé de Huawei han logrado importantes avances en el campo de los humanos digitales en 3D, resolviendo los problemas de coherencia de múltiples vistas y expresividad emocional insuficientes en los métodos existentes. Han desarrollado un nuevo método que permite la síntesis de avatares parlantes en 3D con emociones controlables y logra mejoras significativas en la sincronización de labios y la calidad de renderizado. Los resultados de la investigación se basan en el conjunto de datos EmoTalk3D recientemente construido, que contiene videos calibrados de vistas múltiples, anotaciones emocionales e información geométrica 3D cuadro por cuadro, y se ha hecho público para uso de investigación no comercial. A través del marco de mapeo de "del habla a la geometría y la apariencia", este método captura con precisión expresiones faciales sutiles y logra una representación de alta fidelidad en ángulos de visión libres.

Entrada del producto: https://nju-3dv.github.io/projects/EmoTalk3D/

Recopilaron el conjunto de datos EmoTalk3D con videos calibrados de vistas múltiples, anotaciones de emociones y geometría 3D cuadro por cuadro. Y se propone un nuevo método para sintetizar avatares parlantes en 3D con emociones controlables, con mejoras significativas en la sincronización de labios y la calidad de renderizado.

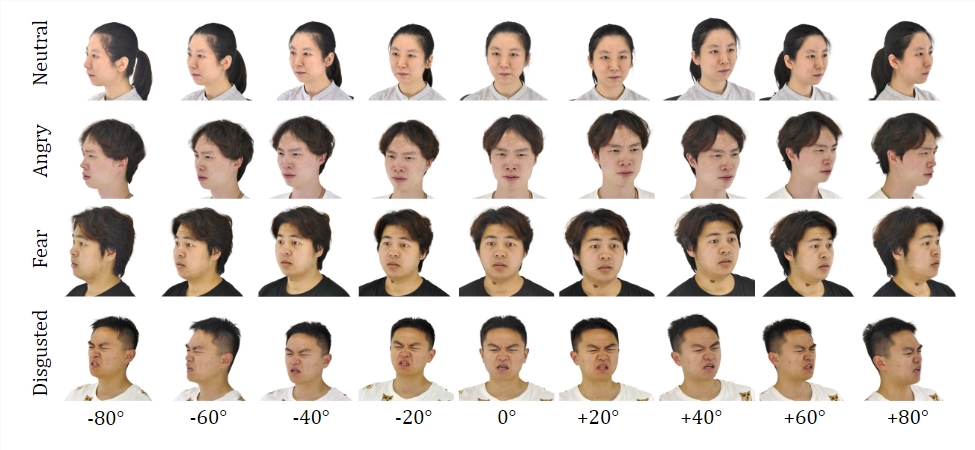

Conjunto de datos:

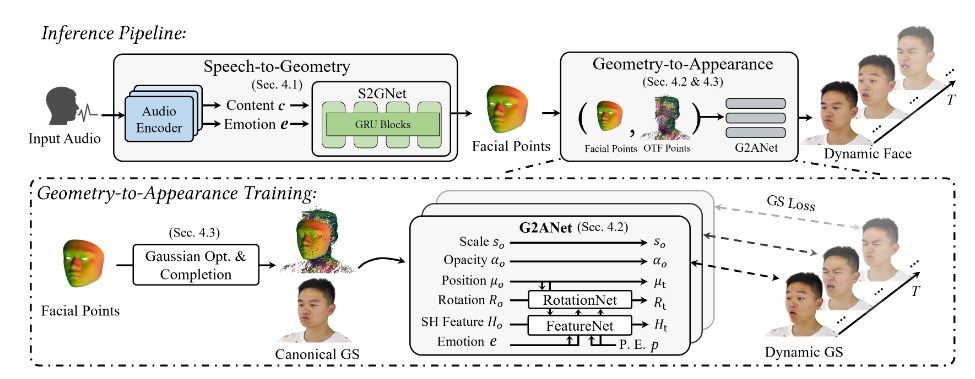

Al entrenarse en el conjunto de datos EmoTalk3D, el equipo de investigación construyó un marco de mapeo "desde el habla hasta la geometría y la apariencia". Primero se predice una secuencia geométrica 3D realista a partir de características de audio, y luego se sintetiza la apariencia de una cabeza parlante 3D representada por un gaussiano 4D en función de la geometría predicha. Las apariencias se descomponen aún más en gaussianos estándar y dinámicos, se aprenden de videos de múltiples vistas y se fusionan para representar animaciones de cabezas parlantes de vista libre.

El modelo permite emociones controlables en avatares parlantes generados y los representa en una amplia gama de ángulos de visión. Se demostró una mejor calidad de renderizado y estabilidad en la generación de movimiento de los labios al tiempo que se capturan detalles faciales dinámicos, como arrugas y expresiones sutiles. En el ejemplo de los resultados generados, las expresiones felices, enojadas y frustradas del humano digital 3D se muestran con precisión.

Su proceso general contiene cinco módulos:

El primero es un codificador de descomposición de contenido emocional, que analiza el contenido y las características emocionales del habla de entrada; el segundo es una red de conversión de voz a geometría, que predice nubes de puntos 3D dinámicas a partir de características; el tercero es un módulo de optimización y finalización gaussiano para establecer; una apariencia estándar; el cuarto es la geometría a la apariencia. La red sintetiza la apariencia facial basada en una nube de puntos dinámica en 3D; el quinto es el módulo de renderizado, que convierte el gaussiano dinámico en una animación de vista libre.

Además, crearon el conjunto de datos EmoTalk3D, un conjunto de datos de cabezas parlantes de múltiples vistas anotadas por emociones con formas faciales en 3D cuadro por cuadro, que se pondrá a disposición del público con fines de investigación no comerciales.

Destacar:

Proponer un nuevo método para sintetizar humanos digitales con emociones controlables.

Construya un marco de mapeo "desde el habla hasta la geometría y la apariencia".

El conjunto de datos de EmoTalk3D está establecido y listo para abrirse.

Esta investigación proporciona una nueva dirección para el desarrollo de la tecnología humana digital 3D. Los métodos y conjuntos de datos propuestos proporcionarán recursos valiosos para investigaciones futuras y promoverán el desarrollo de una tecnología humana digital 3D que sea más realista y emocionalmente expresiva. La apertura del conjunto de datos EmoTalk3D también promueve la cooperación y los intercambios en la comunidad académica.