Adobe, como gigante en el campo del software creativo, ha causado una gran controversia al actualizar sus términos de servicio. Esta actualización permite a Adobe acceder a los trabajos de los usuarios para mejorar su modelo de IA Firefly, una medida que ha sido ampliamente criticada como una "cláusula suprema" que viola los derechos de autor y la privacidad de los usuarios. Este artículo analizará en profundidad la polémica suscitada por la actualización de las condiciones de servicio de Adobe, explorará los motivos que hay detrás y la relación cada vez más tensa entre las empresas tecnológicas y los usuarios.

Adobe, un nombre muy conocido en las industrias creativas, es conocido como el "Guardián de los derechos de autor" por su postura sobre la protección de los derechos de autor. Pero recientemente, la compañía ha quedado atrapada en el torbellino de la opinión pública debido a unas condiciones de servicio silenciosamente actualizadas.

En febrero de este año, Adobe actualizó silenciosamente los términos de servicio de su producto, agregando una adición llamativa: los usuarios deben aceptar que Adobe pueda acceder a sus obras a través de medios automatizados y manuales, incluidos aquellos protegidos por acuerdos de confidencialidad. Adobe utilizará estos trabajos para mejorar sus servicios y software a través de tecnologías como el aprendizaje automático. Si los usuarios no aceptan estos nuevos términos, no podrán utilizar el software de Adobe.

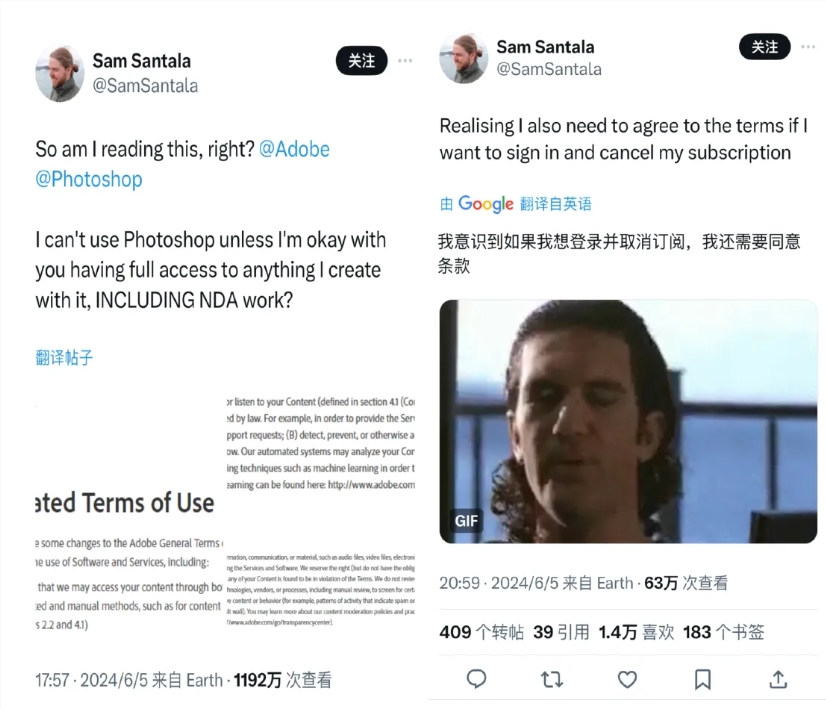

El cambio se reveló recientemente, lo que provocó una reacción violenta por parte de los principales usuarios de Adobe, incluidos creativos, artistas digitales y diseñadores. Creen que se trata de una autorización obligatoria, esencialmente una "cláusula de señor supremo", y su verdadero propósito es entrenar el modelo de IA generativa de Adobe "Firefly". Un bloguero llamado Sam Santala cuestionó esta disposición en Twitter y su tweet recibió decenas de millones de visitas.

Muchos usuarios han expresado preocupaciones sobre su privacidad y derechos de autor y han optado por dejar de utilizar los productos de Adobe. Al mismo tiempo, Meta tomó medidas similares y actualizó su política de privacidad para permitir el uso de información compartida por los usuarios sobre los productos y servicios de Meta para entrenar IA. Si los usuarios no están de acuerdo con la nueva política de privacidad, deberían considerar dejar de usar productos de redes sociales como Facebook e Instagram.

Con el rápido desarrollo de la tecnología de inteligencia artificial, la batalla entre las empresas de tecnología y los usuarios por la privacidad de los datos, la propiedad y el control del contenido se ha vuelto cada vez más feroz. Adobe afirma que los datos de entrenamiento para su modelo Firefly provienen de cientos de millones de imágenes en la biblioteca de imágenes de Adobe, algunas imágenes con licencia pública e imágenes públicas cuya protección de derechos de autor ha expirado. Sin embargo, otras herramientas de generación de imágenes de IA, como Stable Diffusion de Stability AI, Dall-E2 y Midjourney de OpenAI, han sido controvertidas debido a problemas de derechos de autor.

Adobe está tratando de adoptar un posicionamiento de mercado diferenciado en esta área y convertirse en un "caballero blanco" en la carrera armamentista de la IA, enfatizando la legitimidad de los datos de entrenamiento de su modelo y prometiendo pagar las reclamaciones en disputas de derechos de autor causadas por el uso de imágenes generadas. por Adobe Firefly. Pero la estrategia no calmó las preocupaciones de todos los usuarios. Algunos usuarios, como el diseñador senior Ajie, se llaman a sí mismos en broma "víctimas genuinas de Adobe" y creen que Adobe utiliza su enorme ecosistema creativo para entrenar la IA. Aunque es una estrategia comercial inteligente, para los usuarios, la plataforma y la creación de la distribución de intereses entre ellos. faltan los usuarios y el derecho del usuario a saber.

Además, las disputas de derechos de autor con Adobe han quedado expuestas repetidamente en el extranjero, lo que ha provocado que los usuarios se pregunten si Adobe realmente respeta los derechos de autor de los creadores. Por ejemplo, el artista Brian Kesinger descubrió que imágenes generadas por IA similares a su trabajo se vendían bajo su nombre en la biblioteca de imágenes de Adobe sin su consentimiento. Los herederos del fotógrafo Ansel Adams también han acusado públicamente a Adobe de supuestamente vender imitaciones de IA generativa del trabajo del difunto fotógrafo.

Bajo la presión de la opinión pública, Adobe revisó sus términos de servicio el 19 de junio, dejando claro que no utilizará el contenido del usuario almacenado localmente o en la nube para entrenar modelos de IA. Pero la aclaración no disipó por completo las preocupaciones de los creadores. Algunos blogueros conocidos en el círculo de la IA en el extranjero señalaron que los términos de servicio revisados de Adobe aún permiten el uso de los datos de la nube privada de los usuarios para entrenar modelos de aprendizaje automático de herramientas de IA no generativas. Aunque los usuarios pueden optar por no participar en el "análisis de contenido", la complicada operación de cancelación a menudo aleja a muchos usuarios.

Diferentes países y regiones tienen diferentes regulaciones sobre la protección de datos de los usuarios, lo que también afecta las estrategias de las plataformas de redes sociales al formular los términos de servicio de los usuarios. Por ejemplo, según el Reglamento General de Protección de Datos (GDPR), los usuarios en el Reino Unido y la UE tienen un "derecho a oponerse" y pueden optar explícitamente por no utilizar sus datos personales para entrenar los modelos de inteligencia artificial de Meta. Sin embargo, los usuarios estadounidenses no tienen el mismo derecho a saber. Según la política de intercambio de datos existente de Meta, el contenido publicado por usuarios estadounidenses en los productos de redes sociales de Meta puede haber sido utilizado para entrenar IA sin consentimiento explícito.

Los datos han sido aclamados como el “nuevo petróleo” en la era de la IA, pero todavía hay muchas áreas grises en la “explotación” de los recursos. Algunas empresas de tecnología han adoptado un enfoque vago a la hora de obtener los datos de los usuarios, lo que ha desencadenado un doble dilema sobre los derechos de información personal de los usuarios: la propiedad de los derechos de autor digitales y los problemas de privacidad de los datos, dañando gravemente la confianza de los usuarios en la plataforma.

En la actualidad, la plataforma todavía tiene importantes deficiencias a la hora de garantizar que la IA generativa no infrinja los derechos de los creadores y también carece de una supervisión adecuada. Algunos desarrolladores y creadores han tomado medidas y han lanzado una serie de herramientas "anti-IA", desde la herramienta de protección laboral Glaze hasta la herramienta de envenenamiento de datos de IA Nightshade, pasando por la comunidad anti-IA Cara, que se hizo popular frente a El uso no autorizado de usuarios / creadores por parte de las empresas de tecnología con el consentimiento del autor, se capturan datos relevantes para entrenar el modelo de IA y la ira de la gente se ha intensificado.

Hoy en día, con el rápido desarrollo de la tecnología de inteligencia artificial, la forma de equilibrar la innovación tecnológica y la seguridad de la privacidad del usuario y proteger los derechos e intereses de los creadores aún espera un mayor desarrollo de la industria y una mejora continua de las medidas regulatorias legales. Al mismo tiempo, los usuarios deben estar más atentos, comprender sus derechos sobre los datos y tomar medidas cuando sea necesario para proteger sus creaciones y su privacidad.

El incidente de Adobe es solo la punta del iceberg de los problemas de compensación de datos en la era de la IA. En el futuro, cómo encontrar un equilibrio entre el progreso tecnológico y los derechos de los usuarios se convertirá en una cuestión importante para todas las empresas de tecnología y agencias reguladoras. . Sólo fortaleciendo la supervisión y aclarando las reglas de uso de datos podremos construir un entorno ecológico de IA más saludable y sostenible.