Hoy en día, con el rápido desarrollo de la tecnología de inteligencia artificial, la experiencia personalizada se ha convertido en el foco de atención de los usuarios. Cómo hacer que la IA comprenda realmente las necesidades de los usuarios y proporcione servicios personalizados se ha convertido en un gran desafío en el campo de la inteligencia artificial. La tecnología PMG (Generación Multimodal Personalizada) desarrollada conjuntamente por Huawei y la Universidad de Tsinghua proporciona una nueva idea para resolver este problema. Esta tecnología puede generar contenido multimodal personalizado basado en los comportamientos y preferencias históricos de los usuarios, como emoticones, diseños de camisetas y carteles de películas, brindando a los usuarios una experiencia de IA más reflexiva y conveniente.

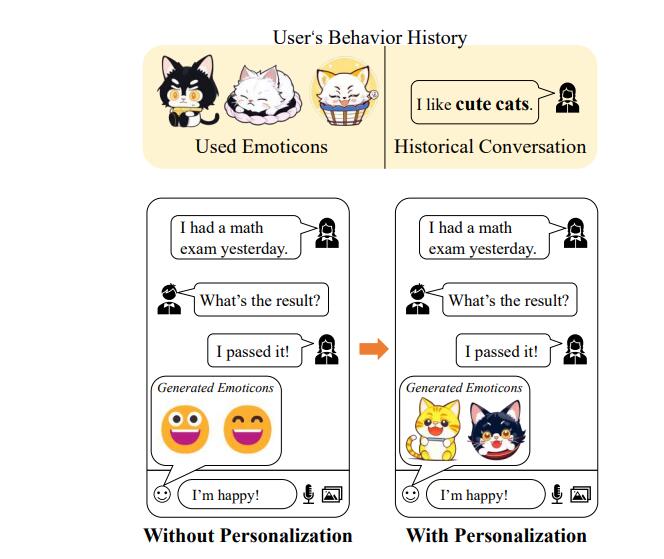

En esta era en la que la personalización es primordial, ¿cómo puede la IA comprenderte mejor? Imagina que cuando escribes "¡Aprobé, estoy muy feliz!" en el software de chat, una IA que comprende tus pensamientos no solo reconoce tu emoción, sino que también recuerda. que prefieres las expresiones de gatos sonrientes, por eso ha creado una serie de paquetes de expresiones de gatos sonrientes únicos diseñados para ti.

En el campo de la generación personalizada de inteligencia artificial, Huawei y la Universidad de Tsinghua han unido fuerzas para crear una nueva tecnología denominada PMG (Personalized Multimodal Generation). Esta tecnología puede generar contenido multimodal que satisfaga las necesidades personalizadas del usuario en función del comportamiento histórico y las preferencias del usuario, como emoticones, diseños de camisetas, carteles de películas, etc.

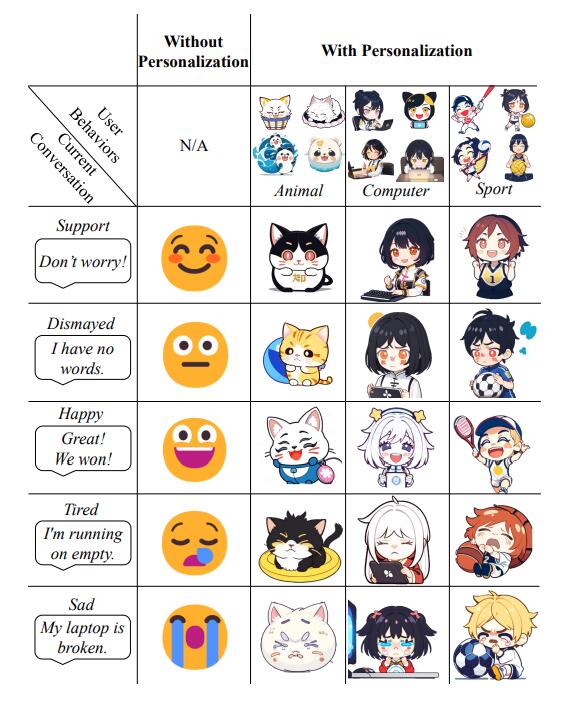

¿Cómo funciona PMG? Extrae las preferencias del usuario analizando el historial de visualización y conversación del usuario, combinado con las capacidades de razonamiento del modelo de lenguaje grande. Este proceso incluye la generación explícita de palabras clave y la generación implícita de vectores de preferencias del usuario. La combinación de ambos proporciona una rica base de información para la generación de contenido multimodal.

En aplicaciones prácticas, la tecnología PMG puede lograr las siguientes funciones:

Generación de palabras clave: cree palabras clave para guiar al modelo grande a extraer las preferencias del usuario como palabras clave.

Generación de vectores ocultos: combinación de palabras clave de preferencia del usuario y palabras clave del elemento objetivo, utilizando el modelo grande de corrección de sesgo ajustado por P-Tuning V2 para aprender capacidades de generación multimodal.

Balance de preferencias del usuario y elementos objetivo: Calculando el nivel de personalización y precisión, midiendo cuantitativamente el efecto de generación y optimizando el contenido generado.

El equipo de investigación verificó la eficacia de la tecnología PMG a través de tres escenarios de aplicación: generación de imágenes de ropa de comercio electrónico, escenas de carteles de películas y generación de expresiones. Los resultados experimentales muestran que PMG es capaz de generar contenido personalizado que refleja las preferencias del usuario y funciona bien en los indicadores de similitud de imágenes LPIPS y SSIM.

Esta tecnología no sólo es innovadora en teoría, sino que también muestra un gran potencial y valor comercial en aplicaciones prácticas. Con la creciente demanda de personalización, se espera que la tecnología PMG experimente un crecimiento explosivo en el futuro, brindando a los usuarios una experiencia más rica y personalizada.

Dirección del proyecto: https://github.com/mindspore-lab/models/tree/master/research/huawei-noah/PMG

Con todo, la tecnología PMG logra una generación de contenido altamente personalizada al combinar grandes modelos de lenguaje y capacidades de generación multimodal, brindando a los usuarios una experiencia de IA más creativa y más cercana a sus necesidades. Tiene amplias perspectivas de aplicación en el comercio electrónico, el entretenimiento y otros campos, y vale la pena esperar su desarrollo y aplicación futuros.