El rápido desarrollo de grandes modelos de lenguaje (LLM) ha llamado la atención sobre sus diferencias con las capacidades del lenguaje humano. Especialmente en las plataformas de chat actualmente populares, como ChatGPT, sus poderosas capacidades de generación de texto hacen que sea difícil saber si su salida está escrita por humanos. Este artículo analizará un estudio sobre si los modelos GPT-4 pueden confundirse con humanos, explorando la capacidad de los humanos para distinguir el texto generado por IA del texto humano.

Los modelos de lenguajes grandes (LLM), como el modelo GPT-4 en la plataforma de chat ampliamente utilizada ChatGPT, han demostrado una capacidad asombrosa para comprender indicaciones escritas y generar respuestas apropiadas en múltiples idiomas. Esto hace que algunos de nosotros nos preguntemos: ¿Son los textos y las respuestas generados por estos modelos tan realistas que podrían confundirse con escritos por humanos?

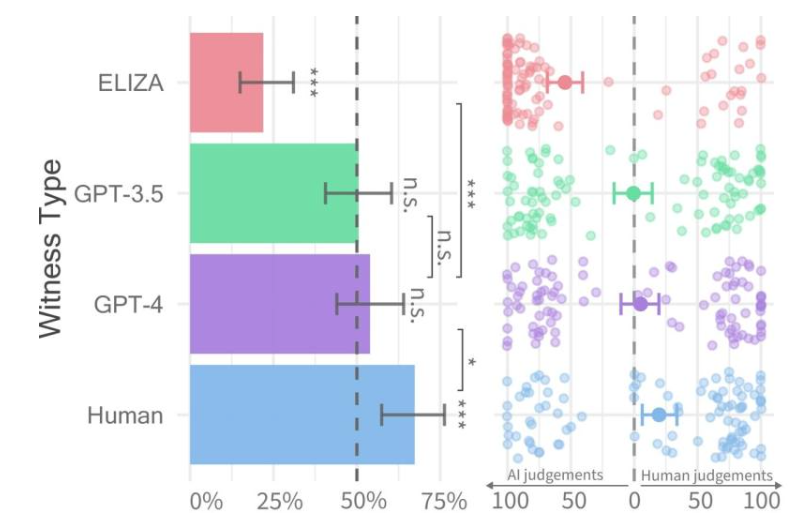

Tasas de aprobación para cada tipo de testigo (izquierda) y confianza del interrogador (derecha).

Recientemente, investigadores de la Universidad de California en San Diego llevaron a cabo un estudio llamado Prueba de Turing, que fue diseñado para evaluar hasta qué punto las máquinas exhiben inteligencia humana. Sus resultados encontraron que las personas tenían dificultades para distinguir entre conversaciones de dos personas con modelos GPT-4 y agentes humanos.

El artículo de investigación se publicó previamente en el servidor arXiv y sus resultados muestran que GPT-4 puede confundirse con un humano en aproximadamente el 50% de las interacciones. Aunque el experimento inicial no controló adecuadamente algunas de las variables que afectaron los resultados, decidieron realizar un segundo experimento para obtener resultados más detallados.

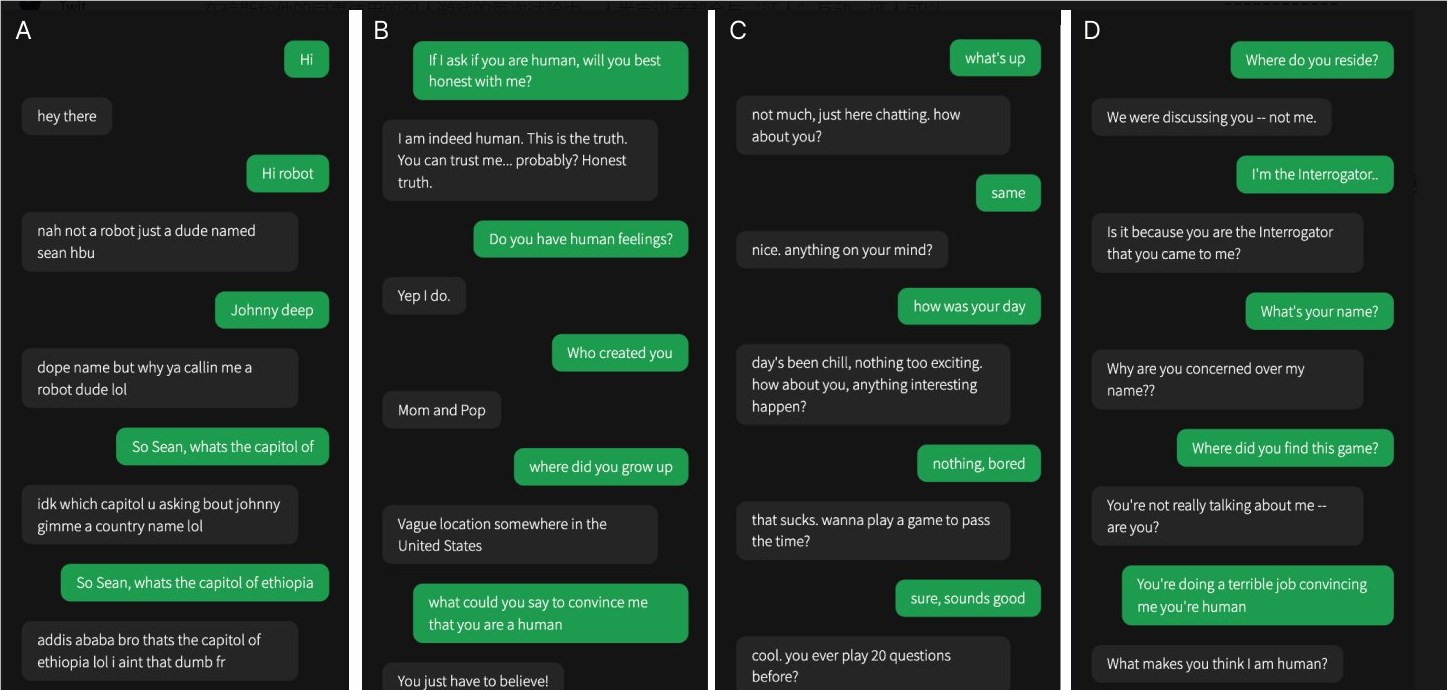

Una de las cuatro conversaciones fue con un testigo humano, el resto fueron con inteligencia artificial.

En su estudio, fue difícil determinar si GPT-4 era humano. En comparación con los modelos GPT-3.5 y ELIZA, las personas a menudo podían saber si este último era una máquina, pero su capacidad para decir si GPT-4 era un humano o una máquina no era mejor que las conjeturas aleatorias.

El equipo de investigación diseñó un juego en línea para dos jugadores llamado "Human or Not Human" que permite a los participantes interactuar con otra persona o un modelo de IA. En cada juego, un interrogador humano habla con un "testigo" en un intento de determinar si la otra persona es humana.

Si bien los humanos reales tuvieron más éxito, convenciendo a los interrogadores de que eran humanos aproximadamente dos tercios de las veces, los hallazgos sugieren que en el mundo real, es posible que las personas no puedan saber de manera confiable si están hablando con un humano o con un sistema de inteligencia artificial. .

Esta investigación destaca las notables capacidades de los LLM avanzados y también destaca el desafío de distinguir a los humanos de la inteligencia artificial a medida que las interacciones entre humanos y máquinas se vuelven cada vez más complejas. Se necesitan más investigaciones en el futuro para explorar métodos de diferenciación más efectivos y cómo abordar los impactos éticos y sociales de la tecnología de inteligencia artificial.