Con el rápido desarrollo de los modelos multimodales de lenguaje grande (MLLM), la integración efectiva de las modalidades visuales, lingüísticas y del habla se ha convertido en un punto de investigación. Sin embargo, los desafíos que plantean las diferencias esenciales en los diferentes datos modales, como la información espacial de la visión y la información de series temporales del habla, obstaculizan la interacción multimodal eficiente. Los métodos existentes a menudo se basan en módulos ASR y TTS independientes, lo que aumenta la latencia y reduce la fluidez de la interacción. Este artículo presenta VITA-1.5, un modelo de lenguaje multimodal a gran escala que integra visión, lenguaje y habla, con el objetivo de resolver estos problemas.

Recientemente, se han logrado avances significativos en los modelos de lenguajes grandes multimodales (MLLM), especialmente en la integración de modalidades visuales y textuales. Sin embargo, con la creciente popularidad de la interacción persona-computadora, la importancia de las modalidades del habla se ha vuelto cada vez más prominente, especialmente en los sistemas de diálogo multimodal. La voz no sólo es un medio clave para la transmisión de información, sino que también mejora significativamente la naturalidad y comodidad de las interacciones.

Sin embargo, debido a las diferencias esenciales entre los datos visuales y de voz, integrarlos en MLLM no es trivial. Por ejemplo, los datos visuales transmiten información espacial, mientras que los datos de voz transmiten cambios dinámicos en series de tiempo. Estas diferencias fundamentales plantean desafíos para la optimización simultánea de las dos modalidades, lo que a menudo genera conflictos durante el proceso de formación. Además, los sistemas tradicionales de voz a voz se basan en módulos separados de reconocimiento automático de voz (ASR) y texto a voz (TTS), lo que aumenta la latencia y reduce la coherencia, lo que limita su utilidad en aplicaciones en tiempo real.

Para abordar estos desafíos, los investigadores lanzaron VITA-1.5, un modelo de lenguaje multimodal a gran escala que integra visión, lenguaje y habla. VITA-1.5 utiliza un método de entrenamiento de tres etapas cuidadosamente diseñado para introducir gradualmente datos visuales y de voz para aliviar los conflictos modales mientras se mantiene un sólido rendimiento multimodal.

En la primera etapa, el modelo se centra en el entrenamiento visual-lingüístico, desarrollando capacidades visuales sólidas mediante el entrenamiento de adaptadores visuales y el ajuste del modelo utilizando leyendas descriptivas y datos visuales de preguntas y respuestas.

La segunda etapa introduce el procesamiento de entrada de audio, entrenando el codificador de audio utilizando datos emparejados de transcripción de voz y luego ajustándolo utilizando datos de preguntas y respuestas de voz, para que el modelo pueda comprender y responder de manera efectiva a la entrada de audio. Finalmente, en la tercera etapa, el decodificador de audio está entrenado para lograr una salida de voz de extremo a extremo sin la necesidad de módulos TTS externos, lo que permite que VITA-1.5 genere respuestas de voz fluidas y mejore la naturalidad y la interactividad del diálogo multimodal. sistemas.

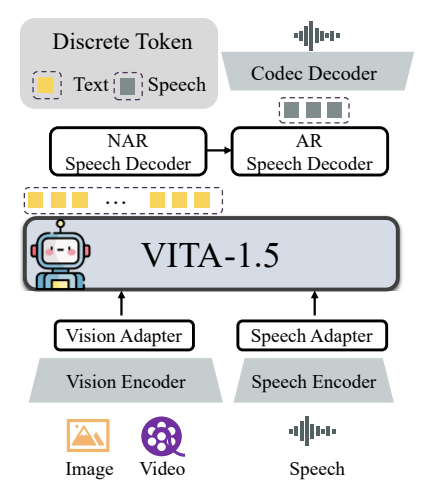

La arquitectura general de VITA-1.5 incluye codificadores y adaptadores visuales y de audio para conectarse a modelos de lenguaje de gran tamaño. La salida tiene un módulo de generación de voz de extremo a extremo en lugar de utilizar un modelo TTS externo como la versión original VITA-1.0. El codificador visual utiliza InternViT-300M, el tamaño de la imagen de entrada es de 448 × 448 píxeles y cada imagen genera 256 tokens visuales.

Para imágenes de alta resolución, VITA-1.5 adopta una estrategia de parcheo dinámico para capturar detalles locales. El vídeo se trata como un tipo de entrada especial de múltiples imágenes, con fotogramas muestreados según la duración del vídeo. El módulo de codificación de audio consta de múltiples capas convolucionales de submuestreo y 24 bloques Transformer, con una velocidad de fotogramas de salida de 12,5 Hz. El adaptador de audio consta de múltiples capas convolucionales con reducción de resolución 2x. TiCodec se utiliza como modelo de códec, que codifica una señal de voz continua en tokens de voz discretos con una frecuencia de 40 Hz y es capaz de decodificarlos nuevamente en una señal de voz con una frecuencia de muestreo de 24 000 Hz. Para permitir que el modelo genere tokens de voz, se agregan dos decodificadores de voz después de los tokens de texto: un decodificador de voz no autorregresivo (NAR) y un decodificador de voz autorregresivo (AR).

Los datos de entrenamiento de VITA-1.5 cubren una amplia gama de categorías, como datos de subtítulos y datos de preguntas y respuestas, incluidos chino e inglés. En diferentes etapas de entrenamiento, se muestrean selectivamente subconjuntos de todo el conjunto de datos para cumplir diferentes objetivos. La estrategia de formación se lleva a cabo en tres etapas:

La primera fase: entrenamiento visual-lingüístico, que incluye alineación visual, comprensión visual y ajuste visual supervisado, tiene como objetivo cerrar la brecha entre la visión y el lenguaje y permitir que el modelo comprenda el contenido de la imagen y responda preguntas visuales.

Fase 2: el ajuste de la entrada de audio, incluida la alineación del audio y el ajuste fino supervisado del audio, está diseñado para permitir que el modelo comprenda la entrada de audio e interactúe a través de preguntas de voz y respuestas de texto.

La tercera etapa: ajuste de salida de audio, incluido el entrenamiento de códec y el entrenamiento de decodificador NAR + AR, está diseñado para permitir que el modelo genere salida de voz y logre una interacción de voz de un extremo a otro.

Los investigadores llevaron a cabo una evaluación exhaustiva de varios puntos de referencia para la comprensión de imágenes, vídeos y voz y compararon los resultados con modelos propietarios y de código abierto. Los resultados muestran que VITA-1.5 exhibe capacidades de percepción y razonamiento comparables a las del MLLM líder en tareas de imagen y video, y logra mejoras significativas en las capacidades del habla. Por ejemplo, en el punto de referencia de comprensión de imágenes, VITA-1.5 funciona a la par con los modelos de código abierto más modernos e incluso supera algunos modelos de código cerrado. En términos de comprensión de vídeo, VITA-1.5 funciona a la par de los mejores modelos de código abierto. Además, VITA-1.5 logró una precisión líder en tareas ASR tanto en chino como en inglés, superando los modelos de habla profesionales.

En general, VITA-1.5 integra con éxito la visión y el habla a través de una estrategia de entrenamiento de tres etapas cuidadosamente diseñada, logrando sólidas capacidades de comprensión visual y del habla, lo que permite una interacción eficiente de voz a voz sin depender de un módulo ASR o TTS separado. Se espera que esta investigación promueva el avance de los modelos de código abierto en el campo de la interacción multimodal en tiempo real.

Dirección del proyecto: https://github.com/VITA-MLLM/VITA

La aparición de VITA-1.5 marca una nueva etapa en el desarrollo de modelos de lenguaje multimodales a gran escala. Sus capacidades de generación de voz de extremo a extremo y su excelente rendimiento en tareas de comprensión de imágenes, videos y voz construirán una experiencia más natural y fluida. Modelo de lenguaje multimodal para el futuro. Los sistemas interactivos dinámicos ofrecen nuevas posibilidades. El resultado de esta investigación merece atención y se espera que desempeñe un papel importante en aplicaciones prácticas.