El último marco de sincronización de labios LatentSync lanzado por ByteDance utiliza el modelo de difusión latente condicional de audio basado en Difusión estable para lograr un efecto de sincronización de labios más preciso y eficiente. A diferencia de los métodos anteriores, LatentSync adopta un enfoque de extremo a extremo para modelar directamente la compleja relación entre audio y visión sin requerir representación de movimiento intermedia, lo que mejora significativamente la eficiencia del procesamiento y la precisión de la sincronización. Este marco utiliza inteligentemente Whisper para la incrustación de audio y lo combina con el mecanismo TREPA para mejorar la consistencia temporal, asegurando que el video de salida mantenga la coherencia temporal mientras mantiene la precisión de la sincronización de labios.

Recientemente, ByteDance lanzó un nuevo marco de sincronización de labios llamado LatentSync, cuyo objetivo es utilizar el modelo de difusión latente de condición de audio para lograr una sincronización de labios más precisa. El marco se basa en Difusión estable y está optimizado para lograr coherencia temporal.

A diferencia de los métodos anteriores basados en la difusión espacial de píxeles o la generación en dos etapas, LatentSync adopta un enfoque de extremo a extremo sin la necesidad de representación de movimiento intermedia y puede modelar directamente relaciones audiovisuales complejas.

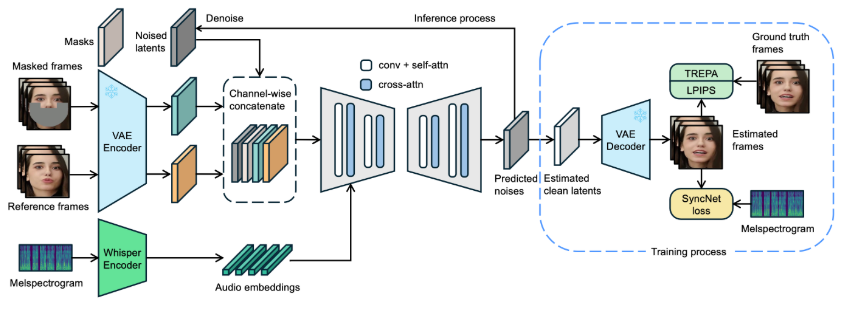

En el marco de LatentSync, Whisper se utiliza por primera vez para convertir espectrogramas de audio en incrustaciones de audio y se integra en el modelo U-Net a través de capas de atención cruzada. El marco realiza una concatenación a nivel de canal de marcos de referencia y marcos de máscara con variables latentes de ruido como entrada a U-Net.

Durante el entrenamiento, se utiliza un enfoque de un solo paso para estimar variables latentes limpias a partir del ruido de predicción y luego decodificarlas para generar fotogramas limpios. Al mismo tiempo, el modelo introduce el mecanismo de Alineación de Representación Temporal (TREPA) para mejorar la consistencia temporal y garantizar que el video generado pueda mantener la coherencia temporal mientras mantiene la precisión de la sincronización de labios.

Para demostrar la eficacia de esta tecnología, el proyecto proporciona una serie de vídeos de muestra, que muestran el vídeo original y el vídeo sincronizado con los labios. A través de ejemplos, los usuarios pueden sentir intuitivamente el importante progreso de LatentSync en la sincronización de labios de vídeo.

Vídeo original:

Vídeo de salida:

Además, el proyecto también planea abrir el código de inferencia y los puntos de control para facilitar la capacitación y las pruebas de los usuarios. Para los usuarios que quieran probar la inferencia, simplemente descarguen los archivos de peso del modelo necesarios y estará listo para comenzar. También se ha diseñado un proceso completo de procesamiento de datos, que cubre cada paso, desde el procesamiento de archivos de video hasta la alineación facial, lo que garantiza que los usuarios puedan comenzar fácilmente.

Entrada del proyecto modelo: https://github.com/bytedance/LatentSync

Reflejos:

LatentSync es un marco de sincronización de extremo a puerto basado en el modelo de difusión latente condicional de audio sin necesidad de representaciones de movimiento intermedias.

El marco utiliza Whisper para convertir espectrogramas de audio en incrustaciones, lo que mejora la precisión del modelo y la coherencia temporal durante la sincronización de labios.

El proyecto proporciona una serie de videos de muestra y planea abrir códigos relevantes y procesos de procesamiento de datos para facilitar el uso y la capacitación de los usuarios.

El código abierto y la facilidad de uso de LatentSync promoverán un mayor desarrollo y aplicación de la tecnología de sincronización de labios, brindando nuevas posibilidades a los campos de la edición de video y la creación de contenido. Esperando actualizaciones posteriores de este proyecto, que traerán más sorpresas.