Google Gemini AI Chat Robot ha lanzado recientemente la muy esperada función de "memoria". Pero esta característica actualmente está limitada a los suscriptores de Google One Ai Premium ($ 20 por mes), y solo admite páginas web y la entrada en inglés. Aunque poderoso, también despertó preocupaciones sobre la seguridad de los datos y la protección de la privacidad.

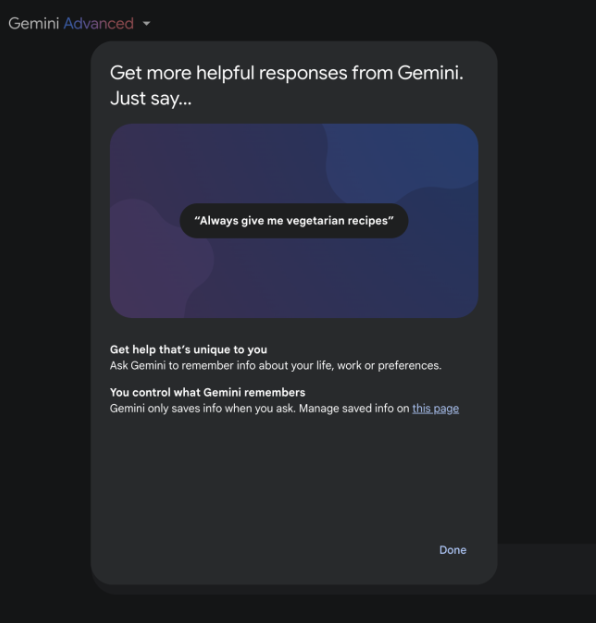

El robot de chat de IA de Google, Gemini, lanzó recientemente una función de actualización importante: la función de "memoria", lo que permite a los asistentes de IA recordar la información de la vida, el contenido laboral y las preferencias personales de los usuarios, proporcionando así una experiencia de servicio más personalizada.

Esta nueva característica está actualmente abierta a los usuarios que se suscriben al programa de $ 20 Google One AI Premium, y temporalmente solo admiten la página web. Vale la pena señalar que solo la entrada en inglés es actualmente compatible.

Específicamente, la función de memoria de Gemini puede ayudar a los usuarios a realizar una variedad de escenarios prácticos. Por ejemplo, cuando el usuario le dice a la comida favorita de Gemini, al preguntar la recomendación del restaurante la próxima vez, la IA puede proporcionar sugerencias más específicas de acuerdo con la preferencia de sabor del usuario. Google también muestra otros ejemplos prácticos en la interfaz, como "usar un lenguaje simple para evitar términos profesionales", "Solo voy a la programación de JavaScript" y "La planificación de viajes incluirá tarifas diarias".

Google enfatiza que los usuarios pueden apagar la función de memoria en cualquier momento, pero el contenido de memoria almacenado debe eliminarse manualmente para desaparecer. Más importante aún, el portavoz de Google declaró claramente que esta información de memoria no se utilizará para el entrenamiento de modelos y no se compartirá con otros.

Sin embargo, la seguridad de tales funciones de memoria es digna de atención. A principios de este año, un investigador de seguridad descubrió que los piratas informáticos pueden implantar memoria "falsa" en ChatGPT, robando continuamente los datos de los usuarios. Este descubrimiento nos recuerda que la función de memoria del sistema AI requiere medidas de protección de seguridad más estrictas.

El lanzamiento de esta característica refleja la tendencia del desarrollo de asistentes de IA hacia una dirección más personalizada e inteligente, pero también ha desencadenado el pensamiento de la protección de la privacidad del usuario y la seguridad de los datos. Cómo garantizar la seguridad de los datos del usuario mientras proporciona conveniencia será un problema importante al que los proveedores de servicios de IA deben prestar atención.

La función de "memoria" de Gemini, sin duda, mejora la experiencia del usuario, pero sus problemas de protección de seguridad y privacidad aún deben mejorarse aún más, que será el desafío que enfrenta Google e incluso toda la industria de la IA. Solo bajo la premisa de garantizar que la seguridad pueda servir mejor a los humanos.