DeepSeek lanzó su primer modelo de inferencia DeepSeek-R1 basado en entrenamiento de aprendizaje por refuerzo el 20 de enero de 2025. El modelo mostró un rendimiento comparable o incluso mejor que OpenAI-o1-1217 en múltiples pruebas comparativas. DeepSeek-R1 no se entrena directamente, sino que supera los problemas causados por el uso exclusivo del modelo de entrenamiento de aprendizaje reforzado (DeepSeek-R1-Zero) a través de entrenamiento de múltiples etapas y datos de arranque en frío. Problemas como la mala legibilidad y la mezcla de idiomas finalmente dieron como resultado mejoras significativas en el rendimiento. El modelo es de código abierto y ofrece precios competitivos para el acceso a la API, lo que brinda a los usuarios una opción más conveniente y económica.

El 20 de enero de 2025, DeepSeek anunció el lanzamiento de su primer modelo de inferencia DeepSeek-R1 entrenado mediante aprendizaje por refuerzo (RL), que logró un rendimiento comparable al de OpenAI-o1-1217 en múltiples puntos de referencia de inferencia. DeepSeek-R1 se basa en el modelo DeepSeek-V3-Base y utiliza entrenamiento de varias etapas y datos de arranque en frío para mejorar las capacidades de inferencia.

Los investigadores de DeepSeek desarrollaron por primera vez DeepSeek-R1-Zero, un modelo entrenado íntegramente mediante aprendizaje por refuerzo a gran escala sin ningún paso preparatorio para un ajuste fino supervisado. DeepSeek-R1-Zero ha demostrado un rendimiento excelente en pruebas comparativas de inferencia. Por ejemplo, en el examen AIME2024, su puntuación pass@1 aumentó del 15,6 % al 71,0 %. Sin embargo, DeepSeek-R1-Zero también tiene algunos problemas, como mala legibilidad y mezcla de idiomas.

Para resolver estos problemas y mejorar aún más el rendimiento de la inferencia, el equipo de DeepSeek desarrolló DeepSeek-R1. DeepSeek-R1 introduce entrenamiento en varias etapas y datos de arranque en frío antes del aprendizaje por refuerzo. Específicamente, los investigadores primero recopilaron miles de datos de arranque en frío para ajustar el modelo DeepSeek-V3-Base. Luego, realizaron un aprendizaje por refuerzo orientado a la inferencia mientras entrenaban a DeepSeek-R1-Zero. Cuando el proceso de aprendizaje por refuerzo estuvo cerca de la convergencia, crearon nuevos datos de ajuste fino supervisados mediante el muestreo de rechazo de los puntos de control del aprendizaje por refuerzo, combinados con los datos supervisados de DeepSeek-V3 en áreas como escritura, respuesta a hechos y autoconciencia, y luego volvieron a entrenar. Modelo DeepSeek-V3-Base. Finalmente, se realiza un aprendizaje de refuerzo adicional en los puntos de control ajustados utilizando señales de todos los escenarios.

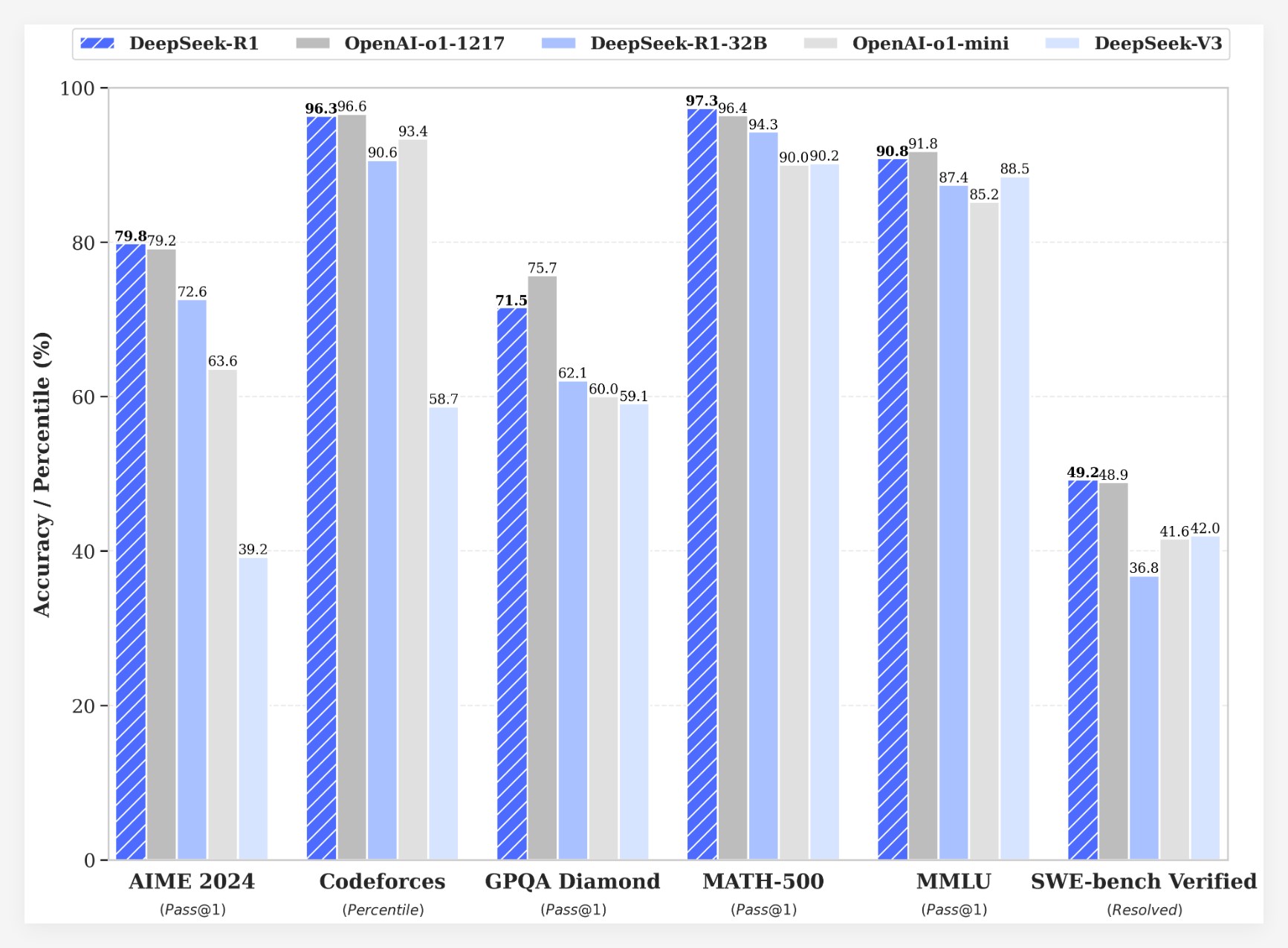

DeepSeek-R1 logra resultados impresionantes en múltiples puntos de referencia:

•En el examen AIME2024, la puntuación pass@1 de DeepSeek-R1 alcanzó el 79,8 %, ligeramente superior a la de OpenAI-o1-1217.

•En el examen MATH-500, la puntuación pass@1 de DeepSeek-R1 alcanzó el 97,3%, que es lo mismo que OpenAI-o1-1217.

•En la tarea de competencia de código, DeepSeek-R1 logró una calificación Elo de 2029 en Codeforces, superando el 96,3% de los participantes humanos.

•En pruebas de conocimiento como MMLU, MMLU-Pro y GPQA Diamond, DeepSeek-R1 obtiene puntuaciones de 90,8%, 84,0% y 71,5% respectivamente, significativamente mejor que DeepSeek-V3.

•DeepSeek-R1 también funciona bien en otras tareas como escritura creativa, preguntas y respuestas generales, edición, resúmenes, etc.

Además, DeepSeek también explora la posibilidad de resumir las capacidades de inferencia de DeepSeek-R1 en modelos más pequeños. Se descubrió que la destilación directamente de DeepSeek-R1 funcionó mejor que aplicar el aprendizaje por refuerzo en un modelo pequeño. Esto sugiere que los patrones de inferencia descubiertos por los modelos de base grandes son fundamentales para mejorar las capacidades de inferencia. DeepSeek tiene DeepSeek-R1-Zero, DeepSeek-R1 de código abierto y seis modelos densos (1.5B, 7B, 8B, 14B, 32B, 70B) destilados de DeepSeek-R1 basados en Qwen y Llama. El lanzamiento de DeepSeek-R1 marca un progreso significativo en el aprendizaje por refuerzo al mejorar las capacidades de razonamiento de grandes modelos de lenguaje.

ventaja de costosEn términos de coste, DeepSeek-R1 ofrece una estrategia de precios muy competitiva. Su precio de acceso a la API es de 0,14 dólares (acierto de caché) y 0,55 dólares (fallo de caché) por millón de tokens de entrada, y 2,19 dólares por millón de tokens de salida. Esta estrategia de precios es más atractiva que otros productos similares y los usuarios la han descrito como un "cambio de juego". ¡El sitio web oficial y la API ya están en línea! ¡Visite https://chat.deepseek.com para experimentar DeepThink!

El lanzamiento de DeepSeek-R1 provocó acaloradas discusiones en la comunidad. Muchos usuarios aprecian la naturaleza de código abierto y las ventajas de costos del modelo, creyendo que brinda a los desarrolladores más opciones y libertad. Sin embargo, algunos usuarios han planteado preguntas sobre el tamaño de la ventana de contexto del modelo y esperan que las versiones futuras puedan optimizarse aún más.

El equipo de DeepSeek declaró que continuarán trabajando para mejorar el rendimiento y la experiencia del usuario del modelo, y planean lanzar más funciones en el futuro, incluido el análisis de datos avanzado, para cumplir con las expectativas de los usuarios para AGI (Inteligencia General Artificial).

El lanzamiento de DeepSeek-R1 no sólo demuestra el gran potencial del aprendizaje por refuerzo para mejorar las capacidades de razonamiento de grandes modelos de lenguaje, sino que también aporta nuevas direcciones y posibilidades al desarrollo del campo de la IA. Sus funciones de código abierto y su estrategia de precios competitivos promoverán aún más la popularización y aplicación de la tecnología de inteligencia artificial.