Los modelos visuales de gran tamaño (LVLM) han logrado avances significativos en el campo de la comprensión de imágenes, pero el "fenómeno de la ilusión" se ha convertido en un cuello de botella en su desarrollo. Para abordar este problema, el equipo del Laboratorio de Vida Futura del Grupo Taotian propuso un nuevo método llamado "Optimización de preferencia de token" (TPO), que mejora efectivamente el impacto visual del modelo al introducir un mecanismo de recompensa de anclaje visual autocalibrado, reduciendo así la dependencia de la información. probabilidad de alucinaciones. El núcleo de TPO es automatizar la generación de señales de recompensa a nivel de token, evitando tediosas anotaciones manuales y asignando recompensas a cada token que reflejen su dependencia de la información visual, mejorando el rendimiento del modelo.

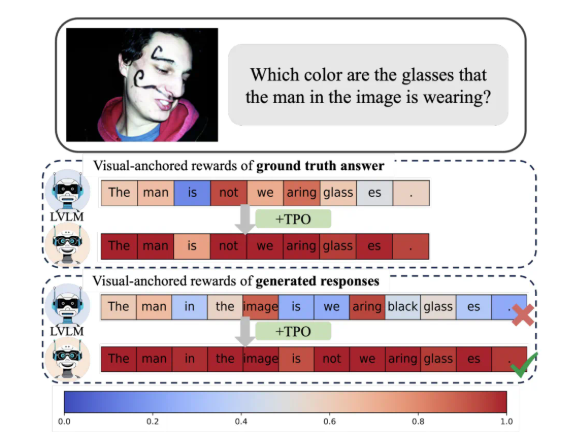

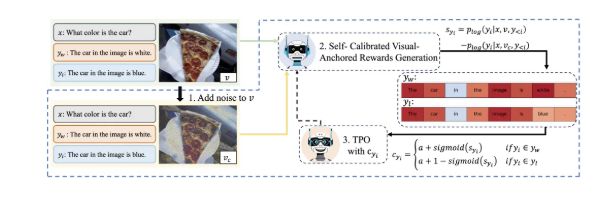

La mayor innovación de TPO es que implementa señales de recompensa automatizadas a nivel de token. Este método puede identificar automáticamente tokens anclados visualmente en datos de preferencia, evitando la tediosa anotación detallada manual, mientras asigna recompensas a cada token durante el proceso de capacitación que reflejan su dependencia de la información visual. Esta señal de recompensa autocalibrada y anclada visualmente está diseñada para optimizar la dependencia del modelo de la información visual, mitigando así eficazmente la aparición de alucinaciones.

Las investigaciones muestran que los modelos que utilizan TPO superan significativamente a los métodos tradicionales en múltiples puntos de referencia de evaluación, especialmente en tareas más complejas, donde las respuestas generadas por el modelo dependen cada vez más de la información de la imagen en lugar del conocimiento previo del modelo de lenguaje. Este progreso no sólo mejora la comprensión del modelo, sino que también proporciona una base teórica importante para futuras investigaciones.

Además, el equipo de investigación también realizó experimentos de ablación en diferentes configuraciones de parámetros de TPO y descubrió que los pasos optimizados de adición de ruido y las estrategias de distribución de recompensas pueden mejorar aún más el rendimiento del modelo. Este descubrimiento, sin duda, señala la dirección para futuras investigaciones y aplicaciones de grandes modelos visuales.

En resumen, este logro innovador de Taotian proporciona una nueva idea para la tecnología de alineación multimodal y promueve la aplicación en profundidad de la tecnología de IA en los campos de la vida y el consumo.

Mediante la aplicación del método TPO, se resuelve eficazmente el problema de la "ilusión" de los modelos visuales grandes, se mejora la confiabilidad y precisión del modelo y se proporciona una nueva dirección para el desarrollo futuro de modelos visuales grandes. Nueva dirección para la aplicación de la inteligencia artificial en la vida real. La aplicación ha sentado una base sólida y tiene una importancia teórica y un valor de aplicación importantes. El resultado de esta investigación aporta nuevas fuerzas al desarrollo de la tecnología multimodal.