Este artículo presenta el método LLM2Clip desarrollado por Microsoft en colaboración con la Universidad de Tongji, cuyo objetivo es mejorar el rendimiento del codificador visual del modelo de clip y resolver sus limitaciones en el manejo de descripciones de texto largas y complejas. LLM2CLIP mejora significativamente la capacidad del modelo para hacer coincidir las imágenes y el texto integrando modelos de lenguaje grandes (LLM) e introducir la tecnología de "Título Contrast Fin-Auting". Los resultados experimentales de este método en múltiples conjuntos de datos muestran que en las tareas de recuperación de imagen a texto y texto a imagen, especialmente tareas de recuperación de texto largas y cortas, superan los modelos tradicionales de clip y EVA y muestran un poderoso procesamiento de lenguaje cruzado capacidad.

En el campo de la ciencia y la tecnología actual, el clip (pre-entrenamiento de imagen de lenguaje contrastante) es un modelo básico multimodal importante. Combina señales visuales y de texto en un espacio de características compartidas mediante el uso de pérdidas de aprendizaje de contraste en pares de texto de imagen a gran escala.

Como buscador, el clip puede admitir varias tareas, como clasificación de cero disparos, detección, segmentación y recuperación de texto de imagen. Mientras tanto, como extractor de características, domina casi todas las tareas de representación intermodal, como la comprensión de la imagen, la comprensión de video y la generación de texto a imagen o video. Lo poderoso de Clip es su capacidad para conectar imágenes al lenguaje natural y capturar el conocimiento humano, gracias a su capacitación en datos de red a gran escala, que contiene descripciones de texto detalladas.

Sin embargo, el clip tiene ciertas limitaciones en el tratamiento de descripciones de texto largas y complejas. Para superar este problema, los investigadores de la Universidad de Microsoft y Tongji propusieron el método LLM2Clip, con el objetivo de mejorar el aprendizaje de representación visual mediante la integración de modelos de idiomas grandes (LLM). Este método reemplaza audazmente el codificador de texto de clip original y utiliza el rico conocimiento de LLM para mejorar el rendimiento del codificador visual del clip. El estudio encontró que la integración directa de LLM en el clip da como resultado la degradación del rendimiento, por lo que este desafío debe abordarse.

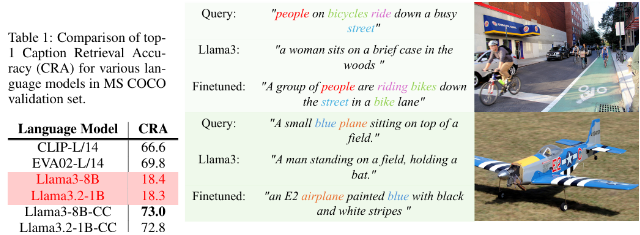

El método LLM2Clip mejora enormemente la capacidad de LLM para separar los títulos de imágenes mediante la introducción de la tecnología de "ajuste de fino de contraste de título", logrando así una mejora significativa del rendimiento.

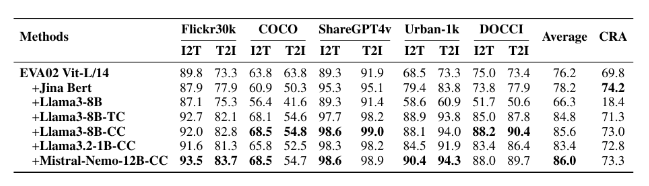

Los investigadores utilizaron conjuntos de datos de diferentes tamaños para experimentos de ajuste fino, incluidos pequeños CC-3M, CC-3M mediano y CC-12M, así como grandes CC-3M, CC-12M, YFCC-15M y Recaption-1B. Los resultados muestran que el modelo entrenado con LLM2Clip funciona mejor que los modelos tradicionales de clip y EVA en tareas de recuperación de imagen a texto y texto a imagen.

Al combinar el entrenamiento multimodal con modelos como Llava 1.5, LLM2Clip funcionó bien en casi todos los puntos de referencia, especialmente cuando se trata de tareas de recuperación de texto largas y cortas, mejorando el rendimiento del modelo EVA02 anterior en un 16.5%. Este enfoque innovador no solo transforma el clip de simplemente procesar datos en inglés a un poderoso modelo de lenguaje cruzado, sino que también sienta las bases para futuras investigaciones sobre la capacitación de clips.

Modelo: https://huggingface.co/collections/microsoft/llm2clip-672323a266173cfa40b32d4c

Código: https://github.com/microsoft/llm2clip/

Documento: https://arxiv.org/abs/2411.04997

Agujas:

LLM2Clip es un enfoque innovador propuesto por Microsoft y la Universidad de Tongji en colaboración con la Universidad de Tongji, con el objetivo de mejorar el rendimiento de su codificador visual al reemplazar el codificador de texto de Clip.

Este método mejora significativamente la capacidad del modelo para hacer coincidir las imágenes con el texto a través de la técnica de "ajuste fino de contraste de título", superando los modelos de vanguardia existentes.

Los experimentos de LLM2Clip en múltiples conjuntos de datos muestran que funciona mejor que los modelos tradicionales en tareas de recuperación de texto largas y cortas, lo que impulsa el desarrollo de modelos de lenguaje cruzado.

En resumen, el método LLM2Clip proporciona nuevas ideas para la mejora del modelo de clip. Los enlaces de recursos relacionados son convenientes para que los lectores aprendan e investiguen.