El lanzamiento de Iflytek del modelo de interacción multimodal de Iflytek marca un nuevo hito en el campo de la inteligencia artificial. Este modelo rompe las limitaciones de la interacción de voz única en el pasado, se da cuenta de una integración perfecta de una sola vez de funciones de interacción humana de voz, visual y digital, lo que brinda a los usuarios una experiencia interactiva más vívida, más realista y más conveniente. Su tecnología humana digital súper antropomórfica puede igualar con precisión el contenido de voz para generar expresiones y acciones, y admite la interacción súper antropomórfica, ajustar los parámetros de sonido de acuerdo con las instrucciones y proporcionar servicios personalizados. La función de interacción visual multimodal le da al modelo la capacidad de "comprender el mundo y reconocer todo", percibir con precisión la información ambiental y hacer respuestas más apropiadas.

El lanzamiento del modelo de interacción multimodal de IFLYTEK no solo refleja la posición principal de IFLYTEK en la tecnología de interacción multimodal, sino que también proporciona nuevas ideas para la dirección de desarrollo futuro de las aplicaciones de inteligencia artificial. Al integrar múltiples métodos de interacción, este modelo puede comprender mejor las necesidades del usuario y proporcionar servicios más precisos y ricos. Su SDK abierto también ofrece a los desarrolladores más posibilidades para promover la popularización y aplicación de tecnología de inteligencia artificial multimodal. En el futuro, podemos esperar aplicaciones más innovadoras basadas en este modelo para mejorar aún más la eficiencia de la vida de las personas y la calidad de la experiencia.

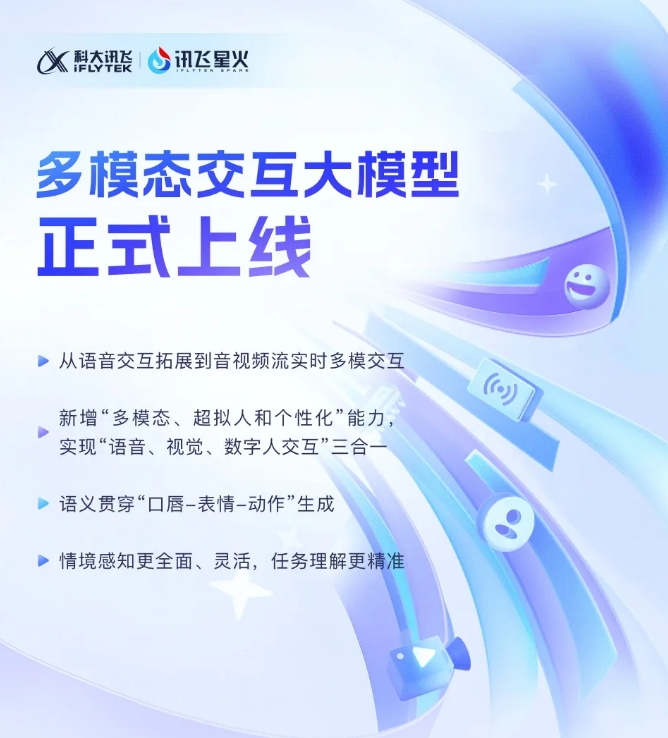

Iflytek anunció recientemente que su último desarrollo del modelo de interacción multimodal Iflytek se ha puesto oficialmente en funcionamiento. Este avance tecnológico marca una nueva etapa en la expansión de Iflytek de una sola tecnología de interacción de voz a una nueva etapa de interacción multimodal en tiempo real de transmisiones de audio y video. El nuevo modelo integra funciones de interacción humana de voz, visual y digital, y los usuarios pueden lograr una combinación perfecta de los tres a través de un clic.

El lanzamiento del modelo de interacción multimodal Iflytek ha introducido la tecnología humana digital súper antropomórfica por primera vez. y real. Al integrar el texto, el habla y las expresiones, el nuevo modelo puede lograr la consistencia semántica intermodal, haciendo que la expresión emocional sea más realista y coherente.

Además, Iflytek Spark admite la tecnología de interacción súper antropomórfica súper rápida, utilizando una red neuronal unificada para realizar directamente el modelado de la voz de la voz de extremo a extremo, lo que hace que la velocidad de respuesta sea más rápida y suave. Esta tecnología puede percibir profundamente los cambios emocionales y ajustar libremente el ritmo, el tamaño y el carácter del sonido de acuerdo con las instrucciones, proporcionando una experiencia interactiva más personalizada.

En términos de interacción visual multimodal, Iflytek Spark puede "comprender el mundo" y "reconocer todo", y percibir completamente escenas de fondo específicas, estado de logística y otra información, lo que hace que la comprensión de la tarea sea más precisa. Al integrar diversas información, como voz, gestos, comportamientos, emociones, etc., el modelo puede hacer las respuestas apropiadas, proporcionando a los usuarios una experiencia interactiva más rica y precisa.

Interacción multimodal Big Modelo SDK: https://www.xfyun.cn/solutions/multimodel

En resumen, la aparición del modelo de interacción multimodal IFLYTEK indica que la tecnología de inteligencia artificial ha entrado en una nueva etapa de desarrollo y su conveniente experiencia interactiva traerá más posibilidades y promover la inteligencia artificial. Esperar a Iflytek Spark traerá más sorpresas en el futuro.