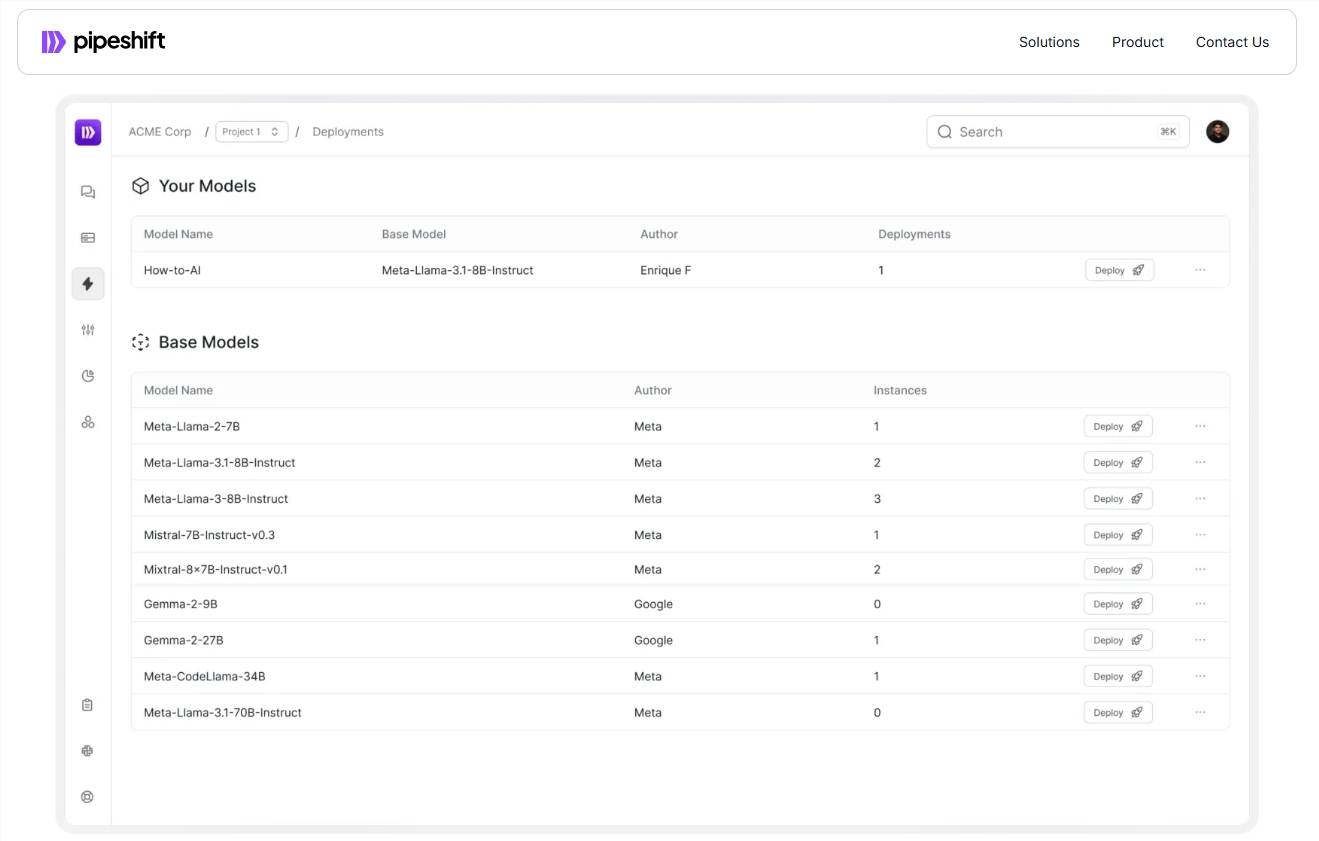

La startup Pipeshift ha lanzado una nueva plataforma de extremo a extremo diseñada para ayudar a las empresas a entrenar, implementar y escalar modelos de IA generativos de código abierto de manera más eficiente. La plataforma es compatible con una variedad de entornos en la nube y GPU locales, mejorando significativamente la velocidad de inferencia y reduciendo los costos, resolviendo el problema de la conmutación eficiente entre múltiples modelos por parte de las empresas. Adopta un marco mágico de motor de inferencia modular, que permite una combinación flexible de diferentes componentes de inferencia para optimizar el rendimiento de inferencia sin un trabajo de ingeniería tediosa. Sin duda, este es un gran beneficio para las empresas que enfrentan desafíos en la implementación y administración de modelos de IA.

Recientemente, Startup Pipeshift lanzó una nueva plataforma de extremo a extremo diseñada para ayudar a las empresas a entrenar, implementar y escalar modelos de IA generativos de código abierto de manera más eficiente. La plataforma no solo se ejecuta en cualquier entorno en la nube o GPU local, sino que también mejora significativamente la velocidad de inferencia y reduce los costos.

Con el rápido desarrollo de la tecnología de IA, muchas compañías enfrentan el desafío de cómo cambiar entre múltiples modelos de manera eficiente. Tradicionalmente, los equipos deben construir un sistema MLOPS complejo que involucre múltiples enlaces, como la adquisición de recursos informáticos, capacitación modelo, ajuste y despliegue a nivel de producción. a la gestión de infraestructura.

Arko Chattopadhyay, cofundador y CEO de Pipeshift, señaló que desarrollar un motor de razonamiento flexible y modular a menudo lleva años de experiencia, y las soluciones de Pipeshift están diseñadas para simplificar este proceso con su motor de razonamiento modular. La plataforma adopta un marco llamado Magic (arquitectura modular del clúster de inferencia de GPU), que permite a los equipos combinar de manera flexible diferentes componentes de inferencia de acuerdo con requisitos de carga de trabajo específicos, optimizando así el rendimiento de inferencia sin la necesidad de ingeniería engorrosa.

Por ejemplo, una empresa minorista Fortune 500, después de usar la plataforma Pipeshift, integra cuatro modelos que originalmente requirieron cuatro instancias de GPU independientes para ejecutarse en una sola instancia de GPU. De esta manera, la compañía no solo logró un aumento de cinco veces en la velocidad de razonamiento, sino que también redujo los costos de infraestructura en un 60%. Este logro permite a las empresas seguir siendo competitivas en un mercado de rápido crecimiento.

Pipeshift ha alcanzado acuerdos anuales de licencia con 30 compañías y planes para lanzar herramientas para ayudar a los equipos a construir y escalar conjuntos de datos en el futuro. Esto acelerará aún más el proceso experimental y de preparación de datos y mejorará la productividad del cliente.

Entrada oficial: https://pipeshift.com/

Agujas:

El motor de inferencia modular de Pipeshift puede reducir significativamente el uso de la GPU de la inferencia de IA y reducir los costos hasta en un 60%.

A través del marco mágico, las empresas pueden combinar rápidamente componentes de inferencia, mejorar la velocidad de inferencia y reducir la carga de ingeniería.

Pipeshift se ha asociado con varias compañías y lanzará más herramientas en el futuro para ayudar a las empresas a administrar las cargas de trabajo de IA de manera más eficiente.

Con sus características eficientes, flexibles y rentables, la plataforma Pipeshift proporciona a las empresas una solución efectiva para simplificar la implementación y gestión de los modelos de IA, a la que vale la pena prestar atención. También vale la pena esperar su desarrollo futuro y el lanzamiento de nuevas herramientas.