El equipo de investigación de Salesforce AI publicó el último modelo de lenguaje multimodal, Blip-3-Video, con el objetivo de procesar eficientemente los datos de video crecientes. El modelo de comprensión de video tradicional es ineficiente. Este movimiento resuelve el problema de tratar con videos largos y proporciona capacidades de comprensión de video más sólidas para industrias como la conducción y el entretenimiento autónomos.

Recientemente, el equipo de investigación de Salesforce AI lanzó un nuevo modelo de lenguaje multimodal: Blip-3-Video. Con el rápido aumento del contenido de video, cómo procesar los datos de video de manera eficiente se ha convertido en un problema urgente. La aparición de este modelo está diseñada para mejorar la eficiencia y la efectividad de la comprensión de video y es adecuado para las industrias, desde la conducción autónoma hasta el entretenimiento.

Los modelos tradicionales de comprensión de video a menudo procesan el cuadro de video por cuadro, generando una gran cantidad de información visual. Este proceso no solo consume muchos recursos informáticos, sino que también limita en gran medida la capacidad de procesar videos largos. A medida que la cantidad de datos de video continúa creciendo, este enfoque se vuelve cada vez más ineficiente, por lo que es crucial encontrar una solución que capture la información crítica del video al tiempo que reduce la carga informática.

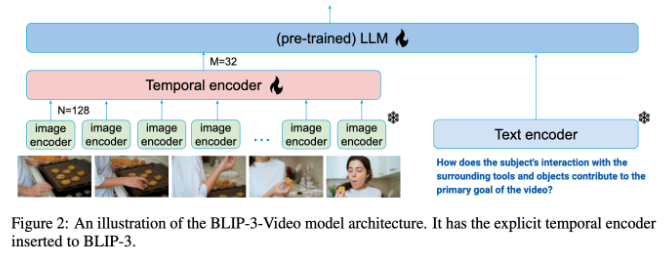

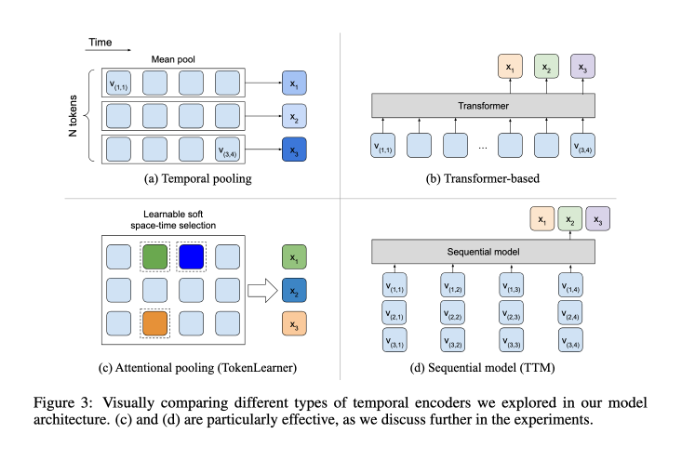

En este sentido, Blip-3-Video funcionó bastante bien. Al introducir un "codificador de secuencia de tiempo", el modelo redujo con éxito la cantidad de información visual requerida en el video a 16 a 32 marcadores visuales. Este diseño innovador mejora enormemente la eficiencia de la computación, lo que permite que los modelos completen tareas de video complejas a un costo menor. Este codificador de tiempo utiliza un mecanismo de agrupación de atención espacio -temporal aprendible que extrae la información más importante de cada cuadro y la integra en un conjunto compacto de marcadores visuales.

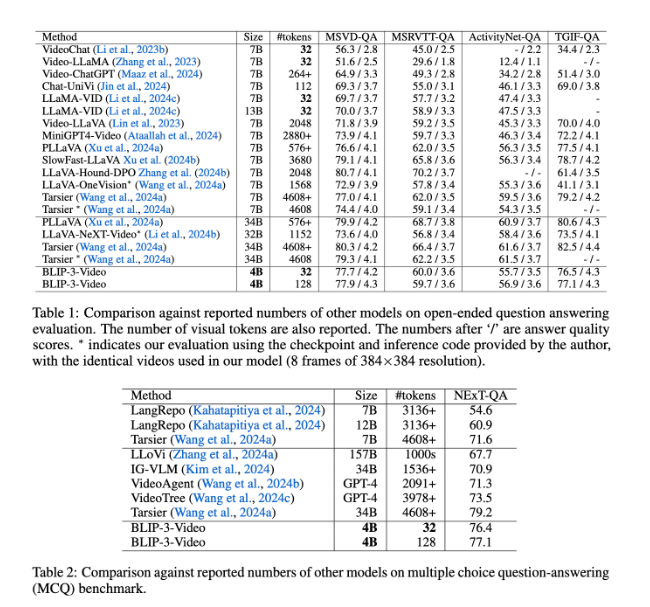

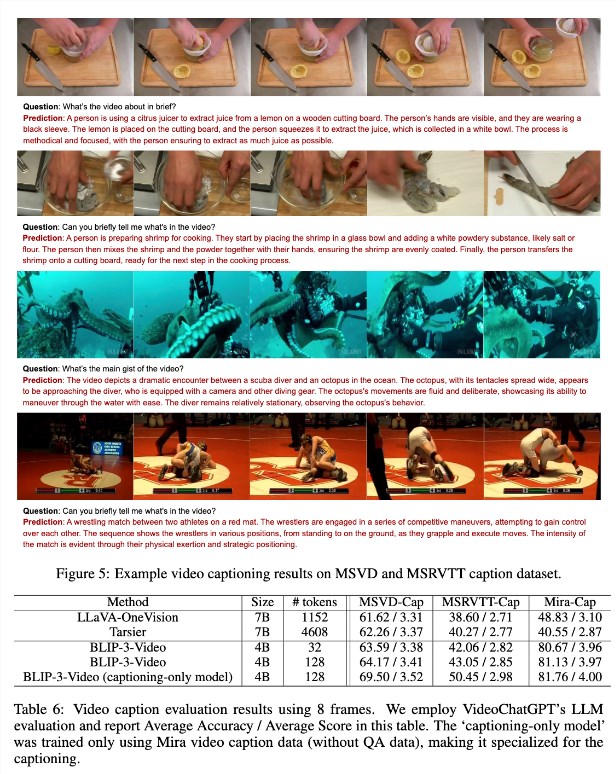

Blip-3-Video también funcionó muy bien. A través de la comparación con otros modelos grandes, el estudio encontró que el modelo tiene una tasa de precisión de modelos superiores comparables en tareas de preguntas y respuestas de video. Por ejemplo, el modelo Tarsier-34B requiere 4608 marcas para procesar 8 cuadros de video, mientras que Blip-3-Video solo necesita 32 marcas para lograr un puntaje de referencia MSVD-QA 77.7% 77.7%. Esto muestra que Blip-3-Video reduce significativamente el consumo de recursos al tiempo que mantiene un alto rendimiento.

Además, el rendimiento de Blip-3-Video en tareas de preguntas y respuestas de opción múltiple no debe subestimarse. En el siguiente conjunto de datos de QA, el modelo logró una puntuación alta del 77.1%, mientras que en el conjunto de datos TGIF-QA, también logró una tasa de precisión del 77.1%. Todos estos datos indican la eficiencia de Blip-3-Video cuando se trata de problemas de video complejos.

Blip-3-Video abre nuevas posibilidades en el campo del procesamiento de videos a través de codificadores de tiempo innovadores. El lanzamiento de este modelo no solo mejora la eficiencia de la comprensión de video, sino que también proporciona más posibilidades para futuras aplicaciones de video.

Entrada del proyecto: https://www.salesforceairesearch.com/opensource/xgen-mm-vid/index.html

Puntos clave:

-** El nuevo lanzamiento del modelo **: Salesforce AI Research lanza Blip-3-Video, un modelo de lenguaje multimodal, centrado en el procesamiento de videos.

- ** Procesamiento eficiente **: El uso de un codificador de tiempo reduce en gran medida el número de marcas visuales requeridas y mejora significativamente la eficiencia informática.

- ** Rendimiento superior **: Excelente rendimiento en las tareas de preguntas y respuestas de videos, mantenga una alta precisión al tiempo que reduce el consumo de recursos.

En resumen, Blip-3-Video ha traído un progreso significativo al campo de la comprensión de video con sus capacidades de procesamiento eficientes y su excelente rendimiento, y sus perspectivas de aplicación son amplias. El código abierto de este modelo también proporciona una buena base para futuras investigaciones y aplicaciones.