Con el rápido desarrollo del modelo de lenguaje grande (MLLM) multimodal, el procesamiento eficiente de los videos ultra largos se ha convertido en un tema candente en la investigación actual. Los modelos existentes a menudo están limitados por la longitud del contexto y el costo computacional, lo que dificulta la comprensión de los videos por hora de manera efectiva. En respuesta a este desafío, el Instituto de Investigación de Zhiyuan y varias universidades han lanzado Video-XL, un modelo de lenguaje visual ultra largo diseñado específicamente para una comprensión de videos de nivel eficiente.

Actualmente, el modelo multimodal de lenguaje grande (MLLM) ha hecho un progreso significativo en el campo de la comprensión de video, pero el manejo de videos ultra largos sigue siendo un desafío. Esto se debe a que los MLLM a menudo luchan por manejar miles de marcadores visuales que exceden la longitud máxima del contexto y se ven afectados por la atenuación de la información causada por la agregación de Mark. Al mismo tiempo, una gran cantidad de etiquetas de video también traerán altos costos informáticos.

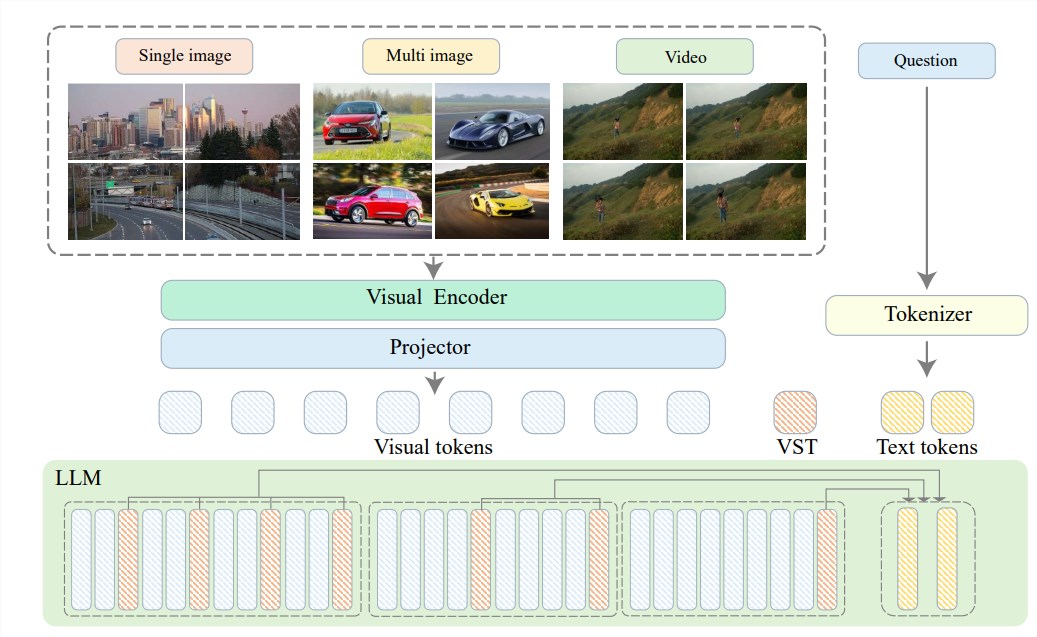

Para resolver estos problemas, el Instituto de Investigación de Zhiyuan ha propuesto Video-XL en conjunto con la Universidad de Shanghai Jiaotong, la Universidad de Renmin de China, la Universidad de Pekín y la Universidad de Publicaciones y Telecomunicaciones de Beijing, un súper diseñado especializado para una comprensión de videos de hora eficiente. modelo de idioma. En el corazón de Video-XL se encuentra en la tecnología de "Resumen de potencial de contexto visual", que utiliza las capacidades de modelado de contexto inherentes a LLM para comprimir efectivamente representaciones visuales largas en formas más compactas.

En pocas palabras, es comprimir el contenido de video en una forma más aerodinámica, al igual que concentrar una carne entera en un tazón de esencia de carne de res, que es conveniente para que el modelo digiera y absorber.

Esta tecnología de compresión no solo mejora la eficiencia, sino que también conserva efectivamente la información clave del video. Debe saber que los videos largos a menudo están llenos de mucha información redundante, al igual que la encuadernación de una anciana, lo cual es largo y maloliente. Video-XL puede eliminar con precisión esta información inútil y retener solo la esencia, lo que garantiza que el modelo no pierda su dirección al comprender el contenido largo de video.

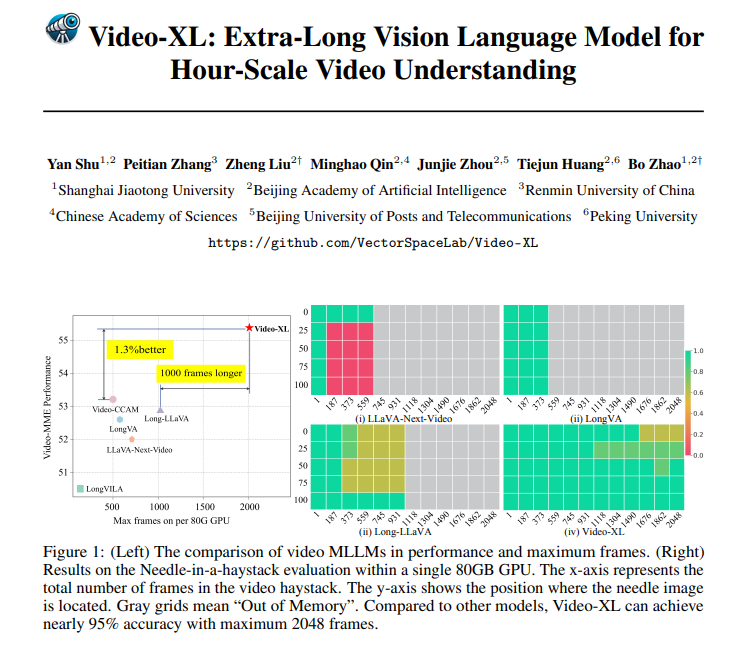

Video-XL no solo es muy poderoso en teoría, sino que también tiene una capacidad práctica muy poderosa. Video-XL ha liderado el camino en múltiples puntos de referencia de comprensión de video largo, especialmente en la prueba de VNBench, con una precisión de casi un 10% más alta que los mejores métodos existentes.

Lo que es aún más impresionante es que Video-XL logra un equilibrio sorprendente entre la eficiencia y la efectividad, puede procesar 2048 cuadros de video en un solo 80GB GPU y al mismo tiempo mantener casi un 95% de precisión en la tasa de evaluación de "encontrar una aguja en un pajar".

Video-XL tiene una perspectiva de aplicación muy amplia. Además de comprender los videos largos generales, también puede ser competente para ciertas tareas, como el resumen de la película, el monitoreo de la detección de anomalías y el reconocimiento de implantes publicitarios.

Esto significa que no tiene que soportar la larga trama al ver películas en el futuro. eventos, que es mucho más eficiente que el acecho manual.

Dirección del proyecto: https://github.com/vectorspacelab/video-xl

Documento: https://arxiv.org/pdf/2409.14485

En resumen, Video-XL ha avanzado en el campo de la comprensión de video ultra largo.