Investigadores de la Universidad de Princeton y la Universidad de Yale realizaron una investigación en profundidad sobre la capacidad de razonamiento de la "cadena de pensamiento (cot)" de los modelos de idiomas grandes (LLM) y publicaron informes relevantes. El estudio tomó la contraseña de cambio como una tarea de prueba y seleccionó tres LLMS GPT-4, Claude3 y Llama3.1 para su análisis, con el objetivo de revelar el mecanismo detrás de la inferencia de cuna. La investigación ha encontrado que el razonamiento COT de LLM no es un razonamiento lógico simbólico simple, sino el resultado de la interacción compleja de múltiples factores, lo que proporciona una nueva perspectiva para que comprendamos la capacidad de razonamiento de LLM.

Investigadores de la Universidad de Princeton y Yale publicaron recientemente un informe sobre la capacidad de razonamiento de la "cadena de vinculación (cot)" en el modelo de lenguaje grande (LLM), revelando el misterio del razonamiento de la cuna: no es un razonamiento simbólico basado únicamente en reglas lógicas, sino Combina el razonamiento de memoria, probabilidad y ruido.

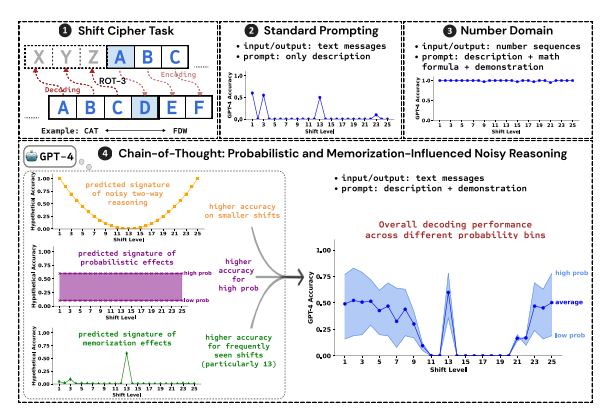

Los investigadores utilizaron el descifrado de la contraseña de cambio como una tarea de prueba para analizar el rendimiento de los tres LLM, GPT-4, Claude3 y Llama3.1. Las contraseñas de cambio son un método de codificación simple, y cada letra se reemplaza por letras que avanzan en el alfabeto con dígitos fijos. Por ejemplo, mueva el alfabeto hacia adelante por 3 dígitos y "Cat" se convierte en "FDW".

Los resultados de la investigación muestran que los tres factores clave que afectan la efectividad de la inferencia de cuna son:

Probabilidad: LLM tiende a generar salidas con mayor probabilidad, incluso si el paso de inferencia apunta a respuestas con menor probabilidad. Por ejemplo, si el paso de razonamiento apunta a "Staz", pero "Stay" es la palabra más común, LLM puede "corregirse a sí mismo" y salir "permanecer".

Memoria: LLM recuerda una gran cantidad de datos de texto durante la capacitación previa, lo que afecta la precisión de su inferencia de cuna. Por ejemplo, ROT-13 es la contraseña de cambio más común, y LLM tiene una precisión significativamente mayor en ROT-13 que otros tipos de contraseñas de turno.

Razonamiento de ruido: el proceso de razonamiento de LLM no es completamente preciso, pero hay un cierto grado de ruido. A medida que aumenta el desplazamiento de la contraseña de cambio, los pasos intermedios requeridos para la decodificación también aumentan, y el impacto de la inferencia de ruido se vuelve más obvio, lo que resulta en una disminución en la precisión de la LLM.

Los investigadores también encontraron que el razonamiento COT de LLM se basa en el autocondicionamiento, es decir, LLM necesita generar explícitamente el texto como el contexto para los pasos de razonamiento posteriores. Si se instruye al LLM para que "piense en silencio" sin emitir ningún texto, su capacidad de razonamiento se reducirá considerablemente. Además, la efectividad del paso de demostración tiene poco impacto en la inferencia de cuna.

Este estudio muestra que el razonamiento COT de LLM no es un razonamiento simbólico perfecto, pero combina múltiples factores como la memoria, la probabilidad y el razonamiento de ruido. LLM no solo muestra las características de un maestro de memoria en el proceso de razonamiento de COT, sino que también muestra el estilo de un maestro de probabilidad. Esta investigación nos ayuda a tener una comprensión más profunda de las capacidades de razonamiento de LLM y proporcionar información valiosa para el desarrollo futuro de sistemas de IA más poderosos.

Dirección en papel: https://arxiv.org/pdf/2407.01687

En resumen, este estudio es de gran importancia para comprender el mecanismo de razonamiento de los modelos de idiomas grandes, y sus hallazgos proporcionan una valiosa referencia para mejorar las capacidades de razonamiento de LLM en el futuro y desarrollar sistemas de IA más potentes. El estudio enfatiza el impacto de factores como la probabilidad, la memoria y el ruido en el razonamiento de LLM, proporcionando nuevas direcciones para los investigadores en el campo de la IA.