La generación de videos largos de alta calidad siempre ha sido un gran desafío en el campo de la visión por computadora. Los investigadores de Meta AI propusieron un método de aceleración sin capacitación llamado Adacache en respuesta a la lenta inferencia de los modelos de transformadores de difusión existentes (DIT). Adacache utiliza hábilmente las diferencias de contenido de video, personaliza las estrategias de almacenamiento en caché para cada video e introduce un esquema de regularización de movimiento para asignar dinámicamente recursos informáticos basados en el contenido de movimiento de video, mejorando significativamente la velocidad de la inferencia al tiempo que garantiza la calidad de la generación.

Generar un video de alta calidad y continuo de tiempo requiere muchos recursos informáticos, especialmente para tramos de tiempo más largos. Aunque los últimos modelos de transformadores de difusión (DIT) han hecho un progreso significativo en la generación de videos, este desafío se ve exacerbado por el razonamiento más lento debido a su dependencia de modelos más grandes y mecanismos de atención más complejos. Para resolver este problema, los investigadores de Meta AI propusieron un método sin capacitación llamado Adacache para acelerar los dits de video.

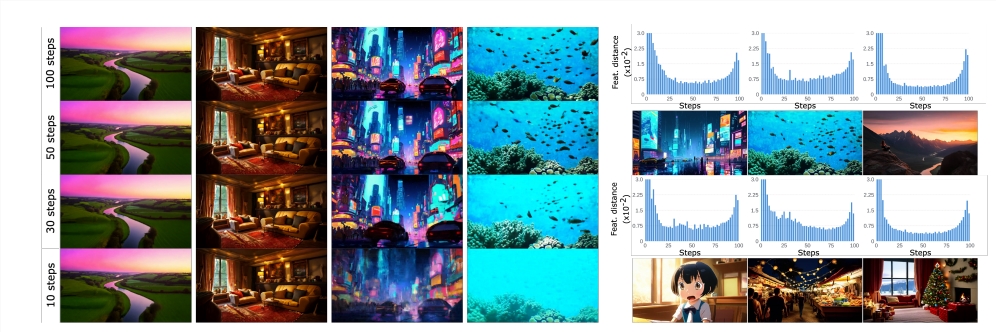

La idea central de Adacache se basa en el hecho de que "no todos los videos son los mismos", lo que significa que algunos videos requieren menos pasos de renovación que otros para lograr una calidad razonable. En base a esto, el método no solo almacena en caché los resultados del cálculo durante el proceso de difusión, sino que también diseña una estrategia de caché personalizada para cada generación de video, maximizando así la compensación entre calidad y latencia.

Los investigadores introdujeron además un esquema de regularización de movimiento (MORG), que utiliza información de video en Adacache para controlar la asignación de recursos informáticos basados en el contenido de movimiento. Dado que las secuencias de video que contienen texturas de alta frecuencia y grandes cantidades de contenido de movimiento requieren más pasos de difusión para lograr una calidad razonable, MoreG puede asignar mejor los recursos informáticos.

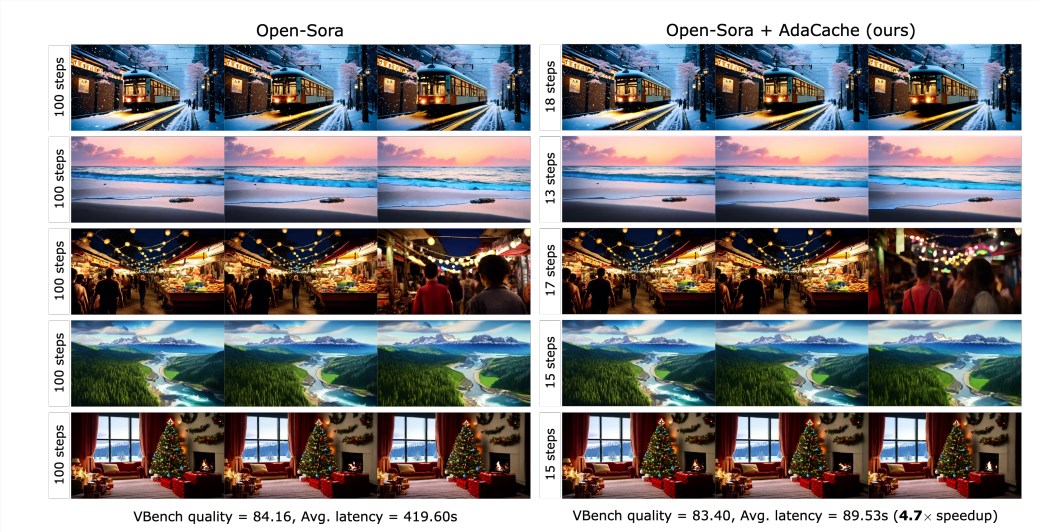

Los resultados experimentales muestran que ADACACHE puede mejorar significativamente la velocidad de inferencia (por ejemplo, hasta 4.7 veces más rápido en la generación de videos abiertos -sora720p -2s) sin sacrificar la calidad de la generación. Además, Adacache tiene buenas capacidades de generalización y se puede aplicar a diferentes modelos DIT de video, como Sora Open, Sora-Plan y Latte. Adacache tiene ventajas significativas tanto en velocidad como en calidad en comparación con otros métodos de aceleración sin entrenamiento como ∆-DIT, T-GATE y PAB.

La investigación de usuarios muestra que los usuarios prefieren videos generados por Adacache en comparación con otros métodos y creen que su calidad es comparable al modelo de referencia. Este estudio confirma la efectividad de Adacache y hace una contribución importante al campo de la generación de videos eficientes. Meta AI cree que ADACACHE puede usarse ampliamente y promover la popularización de la generación de videos largos de alta fidelidad.

Documento: https://arxiv.org/abs/2411.02397

Página de inicio del proyecto:

https://adacache-dit.github.io/

GitHub:

https://github.com/adacache-dit/adacache

En resumen, Adacache, como un método eficiente de aceleración de generación de videos, proporciona nuevas posibilidades para la generación de videos largos de alta fidelidad, y su importante mejora del rendimiento y su buena experiencia de usuario hacen que tenga amplias perspectivas en futuras aplicaciones. Esta investigación realizada por Meta AI ha traído avances importantes en el campo de la generación de videos eficientes.