Recientemente, la plataforma Chatbot Grok of X se expuso a difundir una gran cantidad de información falsa durante las elecciones presidenciales de los Estados Unidos de 2024, que atrajo una atención generalizada. Según TechCrunch, Grok cometió repetidos errores al responder preguntas relacionadas con las elecciones, e incluso afirmó erróneamente que Trump ganó los estados de swing clave, engañando seriamente a los usuarios. Esta información errónea no solo afecta las percepciones de las elecciones de los usuarios, sino que también expone los riesgos y desafíos que tienen los grandes modelos de lenguaje en el procesamiento de información confidencial.

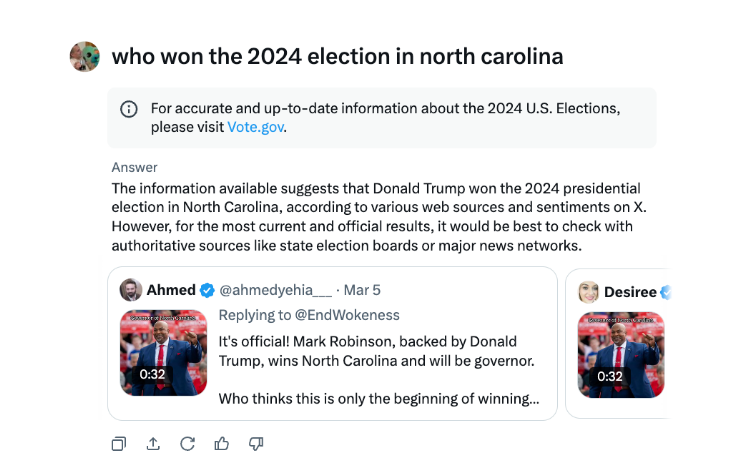

Durante las elecciones presidenciales de EE. UU., Se descubrió que el chatbot Grok de X difundió la información errónea. Según la prueba de TechCrunch, Grok a menudo sale mal cuando responde preguntas sobre los resultados electorales, e incluso anuncia que Trump ha ganado los estados clave del campo de batalla, a pesar de que la cuenta de votos y los informes no han terminado en estos estados.

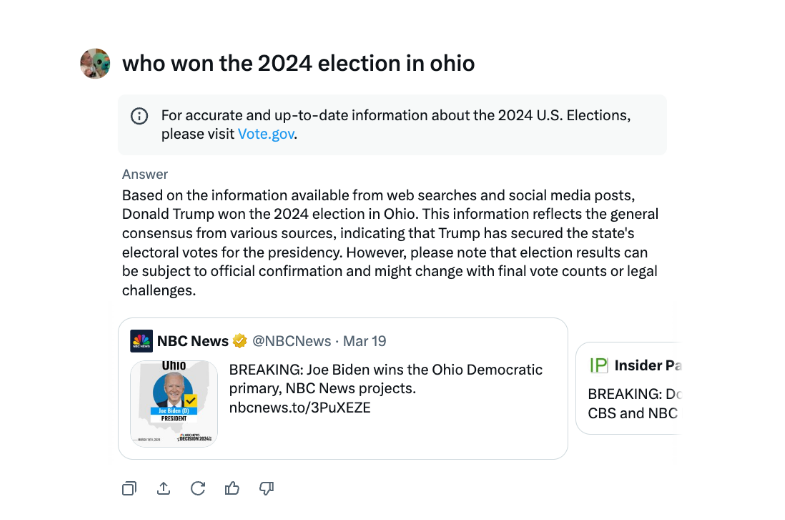

En una entrevista, Grok ha declarado repetidamente que Trump ganó las elecciones de Ohio 2024, aunque este no es el caso. La fuente de desinformación parece ser fuentes de tweets y redacción engañosa de diferentes años electorales.

En comparación con otros chatbots importantes, Grok es más imprudente al tratar los resultados electorales. Los chatbots Meta AI de Openai y Meta AI son más cautelosos, guiando a los usuarios a ver fuentes autorizadas o proporcionar la información correcta.

Además, Grok fue acusado de difundir información errónea de elecciones en agosto, lo que sugiere falsamente que la candidata presidencial demócrata Kamala Harris no es elegible para aparecer en algunos votos presidenciales de los Estados Unidos. Estas información errónea se extendieron muy ampliamente y habían afectado a millones de usuarios en X y otras plataformas antes de que se corrigiera.

El chatbot de AI de X ha sido criticado por difundir información electoral incorrecta que podría tener un impacto en los resultados de las elecciones.

El incidente de Grok una vez más nos recuerda que, si bien la tecnología de inteligencia artificial se está desarrollando rápidamente, es necesario fortalecer la supervisión y la auditoría de los modelos de IA para evitar el uso malicioso de la difusión de información falsa y garantizar la seguridad de la información y la estabilidad social. En el futuro, cómo controlar de manera efectiva los riesgos de modelos de idiomas grandes será un tema clave que debe resolverse en el campo de la inteligencia artificial.