La tecnología de generación de videos ha progresado significativamente en los últimos años, pero los modelos existentes aún tienen limitaciones en la captura de un movimiento complejo y fenómenos físicos. El equipo de investigación de Meta propuso el marco de VideoJam, con el objetivo de mejorar la expresividad de movimiento de los modelos de generación de videos a través de la representación conjunta de apariencia de apariencia.

En el campo de la generación de videos, a pesar del progreso significativo en los últimos años, los modelos generativos existentes aún luchan por capturar el movimiento complejo, los fenómenos dinámicos y físicos en la realidad. Esta limitación se deriva principalmente de los objetivos tradicionales de reconstrucción de píxeles, que tienden a tender a mejorar el realismo de la apariencia e ignorar la consistencia del movimiento.

Para abordar este problema, el equipo de investigación de Meta propuso un nuevo marco llamado VideoJam, que tiene como objetivo inyectar prioras de movimiento efectivas en modelos de generación de video alentando a los modelos a aprender representaciones conjuntas de movimiento de apariencia.

El marco de VideoJam contiene dos unidades complementarias. Durante la fase de entrenamiento, el marco extiende el objetivo de predecir tanto los píxeles generados como el movimiento correspondiente, ambos de una sola representación de aprendizaje.

Durante la fase de razonamiento, el equipo de investigación introdujo un mecanismo llamado "guía intrínseca" que guía el proceso de generación hacia una dirección de movimiento consistente al utilizar la propia predicción de movimiento en evolución del modelo como una señal de guía dinámica. Vale la pena señalar que VideoJam se puede aplicar a cualquier modelo de generación de videos sin modificar los datos de capacitación o extender el modelo.

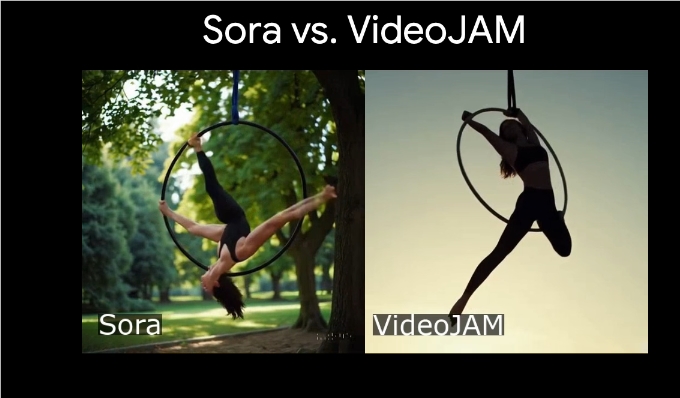

VideoJam ha demostrado ser una consistencia en el movimiento líder de la industria, superando múltiples modelos patentados altamente competitivos al tiempo que mejora la calidad visual de las imágenes generadas. Los resultados de este estudio enfatizan la relación complementaria entre la apariencia y el movimiento, lo que puede mejorar significativamente el efecto visual y la coherencia de movimiento de la generación de videos cuando los dos se combinan de manera efectiva.

Además, el equipo de investigación demostró el excelente rendimiento de VideoJam-30B en la generación de tipos de deportes complejos, incluidas escenas como el salto de skaters y los bailarines de ballet girando en el lago. Al comparar el modelo Bibase DIT-30B, el estudio encontró que VideoJam ha mejorado significativamente la calidad de la generación de movimiento.

Entrada del proyecto: https://hila-chefer.github.io/videojam-paper.github.io/

Puntos clave:

El marco de VideoJam mejora la expresividad de movimiento de los modelos de generación de videos a través de la representación conjunta de apariencia de apariencia.

Durante el entrenamiento, VideoJam puede predecir píxeles y movimiento simultáneamente, mejorando la consistencia del contenido generado.

Se ha demostrado que VideoJam supera múltiples modelos competitivos tanto en consistencia de movimiento como en calidad visual.

El marco de VideoJam de Meta ha traído nuevos avances a la tecnología de generación de videos.