Los equipos de investigación de la Universidad de Stanford y la Universidad de Washington publicaron recientemente un método de capacitación de IA innovador llamado S1. A diferencia de la dependencia pasada de una gran potencia informática o algoritmos complejos, el método S1 logra hábilmente un salto de rendimiento al controlar la asignación de recursos informáticos del modelo durante las pruebas.

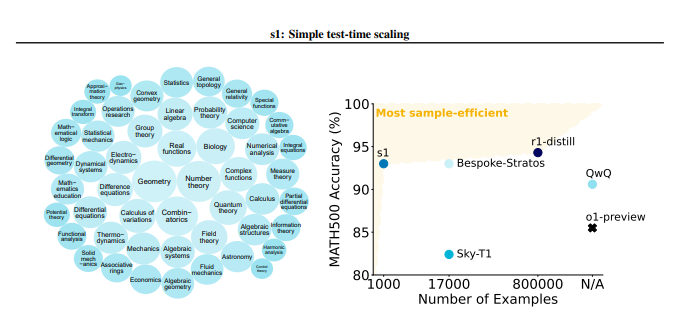

El método S1 primero construyó cuidadosamente un pequeño conjunto de datos llamado S1K que contenía 1000 problemas de inferencia de alta calidad. Los estándares de detección de este conjunto de datos son muy estrictos y deben cumplir con las tres condiciones de alta dificultad, fuerte diversidad y excelente calidad al mismo tiempo. El equipo de investigación verificó la importancia de estos tres criterios a través de experimentos detallados de ablación, y los resultados mostraron que la selección aleatoria o el enfoque en un solo criterio conduciría a una disminución significativa en el rendimiento. Vale la pena mencionar que incluso si se entrena utilizando un superset que contiene 59,000 muestras, su efecto es mucho menor que el de 1,000 muestras cuidadosamente seleccionadas, lo que resalta la criticidad de la selección de datos.

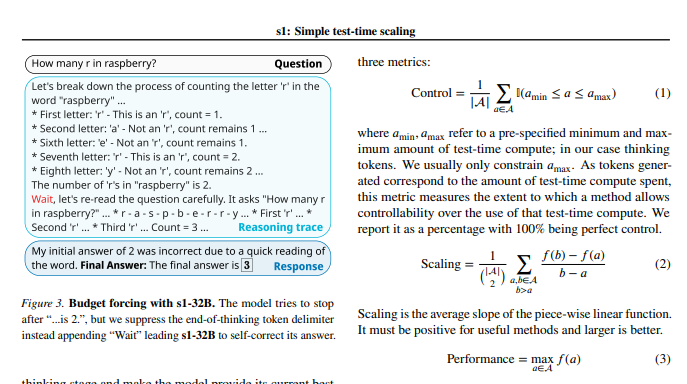

Después de que se completó la capacitación modelo, los investigadores utilizaron una técnica llamada "presupuesto obligatorio" para controlar la cantidad de cálculos durante las pruebas. En pocas palabras, este método extiende el tiempo de pensamiento del modelo terminando por la fuerza el proceso de pensamiento del modelo o agregando instrucciones de "espera", guiando así al modelo para una exploración y verificación más profunda. De esta manera, el modelo puede verificar repetidamente los pasos de inferencia y corregir efectivamente los errores.

Los resultados experimentales muestran que con el ajuste de fino en el conjunto de datos S1K y el soporte de la tecnología "presupuestaria obligatoria", el rendimiento del modelo S1-32B en problemas matemáticos a nivel de competencia excedió el modelo de previsión O1 de OpenAI en hasta un 27%. Lo que es aún más sorprendente es que a través de la escala de "presupuesto obligatoria", el modelo S1-32B también mostró capacidad de generalización más allá de su propio nivel de entrenamiento, y su puntaje en el conjunto de pruebas AIME24 aumentó del 50% al 57%.

La contribución central de este estudio es que proporciona un método simple y eficiente para crear conjuntos de datos con capacidades de alta inferencia y lograr la escala de rendimiento al probar. Según esto, el equipo de investigación creó el modelo S1-32B, cuyo rendimiento es comparable o incluso supera el modelo de código cerrado, y al mismo tiempo logra una fuente abierta y una alta eficiencia de muestra. El código, el modelo y los datos del estudio tienen un origen abierto en GitHub.

Los investigadores también realizaron experimentos de ablación en profundidad sobre las sutilezas de los datos y la técnica de escala durante las pruebas. En el lado de los datos, les pareció crucial considerar la dificultad, la diversidad y la calidad al mismo tiempo. En términos de escala en el tiempo de prueba, el enfoque "obligatorio presupuestario" muestra una excelente capacidad de control y mejoras de rendimiento. El estudio también explora dos métodos diferentes, escala paralela y escala secuencial, e introduce tecnologías avanzadas como Rebase, proporcionando una inspiración importante para futuras direcciones de investigación.

Este estudio no solo aporta una nueva idea de bajo costo y alta eficiencia al campo del entrenamiento de IA, sino que también sienta una base sólida para una gama más amplia de aplicaciones de IA.

Dirección en papel: https://arxiv.org/pdf/2501.19393

Este estudio demuestra que a través de una cuidadosa construcción de datos y prueba de tiempo de gestión de recursos informáticos, las capacidades de inferencia de los modelos de IA pueden mejorarse significativamente, proporcionando nuevas direcciones para el desarrollo futuro de la IA.