Obtenir de l'aide - FAQ Discussions Discord Documentation website

Feuille de route des modèles de démarrage rapide ? Démo ? Explorateur ? Exemples

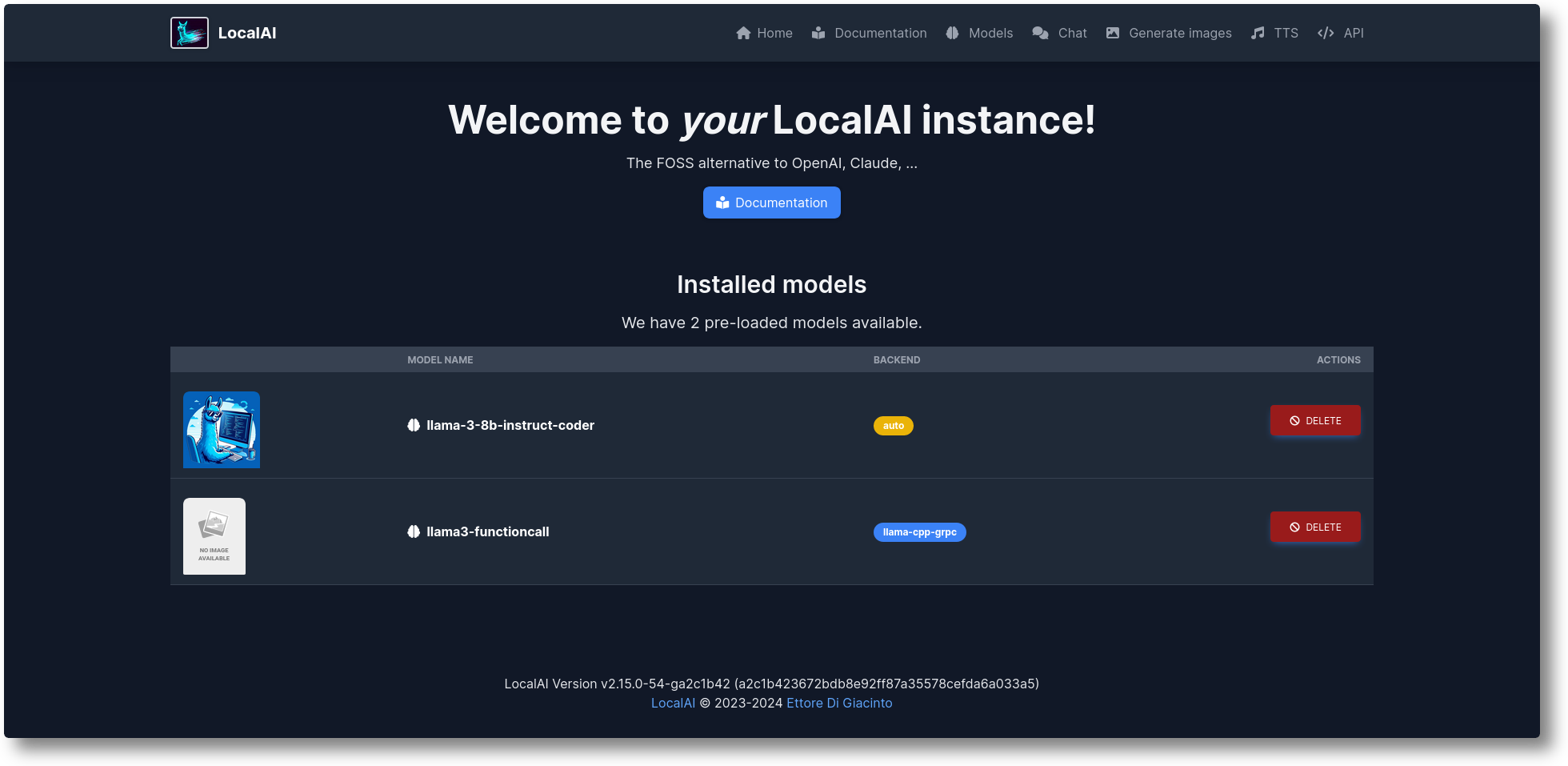

LocalAI est l'alternative gratuite et Open Source OpenAI. LocalAI agit comme une API REST de remplacement compatible avec les spécifications de l'API OpenAI (Elevenlabs, Anthropic... ) pour l'inférence d'IA locale. Il vous permet d'exécuter des LLM, de générer des images, de l'audio (et pas seulement) localement ou sur site avec du matériel grand public, prenant en charge plusieurs familles de modèles. Ne nécessite pas de GPU. Il est créé et maintenu par Ettore Di Giacinto.

Exécutez le script d'installation :

boucle https://localai.io/install.sh | merde

Ou exécutez avec docker :

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu# Images alternatives :# - si vous avez un GPU Nvidia :# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12# - sans modèles préconfigurés# docker run -ti --name local-ai -p 8080:8080 localai/localai:latest# - sans modèles préconfigurés pour les GPU Nvidia# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai :dernier-gpu-nvidia-cuda-12

Pour charger des modèles :

# Depuis la galerie de modèles (voir les modèles disponibles avec la « liste de modèles local-ai », dans l'interface Web depuis l'onglet modèle, ou en visitant https://models.localai.io) local-ai run llama-3.2-1b-instruct : q4_k_m# Démarrez LocalAI avec le modèle phi-2 directement depuis huggingfacelocal-ai exécutez huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf# Installer et exécuter un modèle à partir du registre Ollama OCIlocal-ai, exécutez ollama://gemma:2b# Exécutez un modèle à partir d'un fichier de configurationlocal-ai, exécutez https://gist.githubusercontent.com/.../phi-2.yaml# Installez et exécutez un modèle à partir d'un registre OCI standard (par exemple, Docker Hub)local-ai run oci://localai/phi-2:latest

Commencer

Octobre 2024 : exemples déplacés vers LocalAI-examples

Août 2024 : ? FLUX-1, Explorateur P2P

Juillet 2024 : ? Tableau de bord P2P, mode fédéré LocalAI et AI Swarms : #2723

Juin 2024 : ? Vous pouvez désormais parcourir la galerie de modèles sans LocalAI ! Découvrez https://models.localai.io

Juin 2024 : Prise en charge des modèles issus des registres OCI : #2628

Mai 2024 : llama.cpp P2P décentralisé : #2343 (peer2peer lama.cpp !) Docs https://localai.io/features/distribute/

Mai 2024 : Openvoice : #2334

Mai 2024 : ? Appels de fonctions sans grammaires et mode mixte : #2328

Mai 2024 : Inférence distribuée : #2324

Mai 2024 : Chat, TTS et génération d'images dans l'interface Web : #2222

Avril 2024 : API Reranker : #2121

Éléments de la feuille de route : liste des problèmes

Multimodal avec vLLM et compréhension vidéo : #3729

API temps réel #3714

Pools communautaires mondiaux P2P distribués : #3113

Améliorations de l'interface Web : #2156

Backends v2 : #1126

Améliorer l'UX v2 : #1373

API de l'assistant : #1273

Point final de modération : #999

Vulkan : #1647

API anthropique : #1808

Si vous souhaitez aider et contribuer, des problèmes à gagner : https://github.com/mudler/LocalAI/issues?q=is%3Aissue+is%3Aopen+label%3A%22up+for+grabs%22

Génération de texte avec des GPT ( llama.cpp , gpt4all.cpp , ... et plus)

Texte en audio

Audio vers texte (transcription audio avec whisper.cpp )

Génération d'images avec diffusion stable

API d'outils similaires à OpenAI

Génération d'intégrations pour les bases de données vectorielles

Grammaires contraintes

Téléchargez des modèles directement depuis Huggingface

API Vision

API de reclassement

Inférence P2P

Interface Web intégrée !

Consultez la section Mise en route de notre documentation.

Créez et déployez des conteneurs personnalisés :

https://github.com/sozercan/aikit

Interfaces Web :

https://github.com/Jirubizu/localai-admin

https://github.com/go-skynet/LocalAI-frontend

QA-Pilot (Un projet de chat interactif qui exploite les LLM LocalAI pour une compréhension et une navigation rapides du référentiel de code GitHub) https://github.com/reid41/QA-Pilot

Galeries de modèles

https://github.com/go-skynet/model-gallery

Autre:

Graphique de barre https://github.com/go-skynet/helm-charts

Extension VSCode https://github.com/badgooooor/localai-vscode-plugin

Utilitaire de terminal https://github.com/djcopley/ShellOracle

Assistant intelligent local https://github.com/mudler/LocalAGI

Assistant à domicile https://github.com/sammcj/homeassistant-localai / https://github.com/drndos/hass-openai-custom-conversation / https://github.com/valentinfrlch/ha-gpt4vision

Bot Discord https://github.com/mudler/LocalAGI/tree/main/examples/discord

Bot Slack https://github.com/mudler/LocalAGI/tree/main/examples/slack

Shell-Pilot (Interagissez avec LLM à l'aide de modèles LocalAI via des scripts shell purs sur votre système Linux ou MacOS) https://github.com/reid41/shell-pilot

Bot télégramme https://github.com/mudler/LocalAI/tree/master/examples/telegram-bot

Actions Github : https://github.com/marketplace/actions/start-localai

Exemples : https://github.com/mudler/LocalAI/tree/master/examples/

Guide de mise au point du LLM

Comment construire localement

Comment installer dans Kubernetes

Projets intégrant LocalAI

Section Comment faire (organisée par notre communauté)

Exécutez le code Visual Studio avec LocalAI (SUSE)

Exécutez LocalAI sur Jetson Nano Devkit

Exécutez LocalAI sur AWS EKS avec Pulumi

Exécutez LocalAI sur AWS

Créer un slackbot pour les équipes et les projets OSS qui répondent à la documentation

LocalAI rencontre k8sgpt

Réponse aux questions sur les documents localement avec LangChain, LocalAI, Chroma et GPT4All

Tutoriel pour utiliser k8sgpt avec LocalAI

Si vous utilisez ce référentiel de données dans un projet en aval, pensez à le citer avec :

@misc{localai,

author = {Ettore Di Giacinto},

title = {LocalAI: The free, Open source OpenAI alternative},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/go-skynet/LocalAI}},Trouvez-vous LocalAI utile ?

Soutenez le projet en devenant bailleur de fonds ou sponsor. Votre logo apparaîtra ici avec un lien vers votre site Web.

Un immense merci à nos généreux sponsors qui soutiennent ce projet en couvrant les dépenses de CI, et à notre liste de sponsors :

LocalAI est un projet communautaire créé par Ettore Di Giacinto.

MIT - Auteur Ettore Di Giacinto [email protected]

LocalAI n'aurait pas pu être construit sans l'aide d'excellents logiciels déjà disponibles auprès de la communauté. Merci!

lama.cpp

https://github.com/tatsu-lab/stanford_alpaca

https://github.com/cornelk/llama-go pour les premières idées

https://github.com/antimatter15/alpaca.cpp

https://github.com/EdVince/Stable-Diffusion-NCNN

https://github.com/ggerganov/whisper.cpp

https://github.com/saharNooby/rwkv.cpp

https://github.com/rhasspy/piper

Il s'agit d'un projet communautaire, un merci spécial à nos contributeurs ! ?