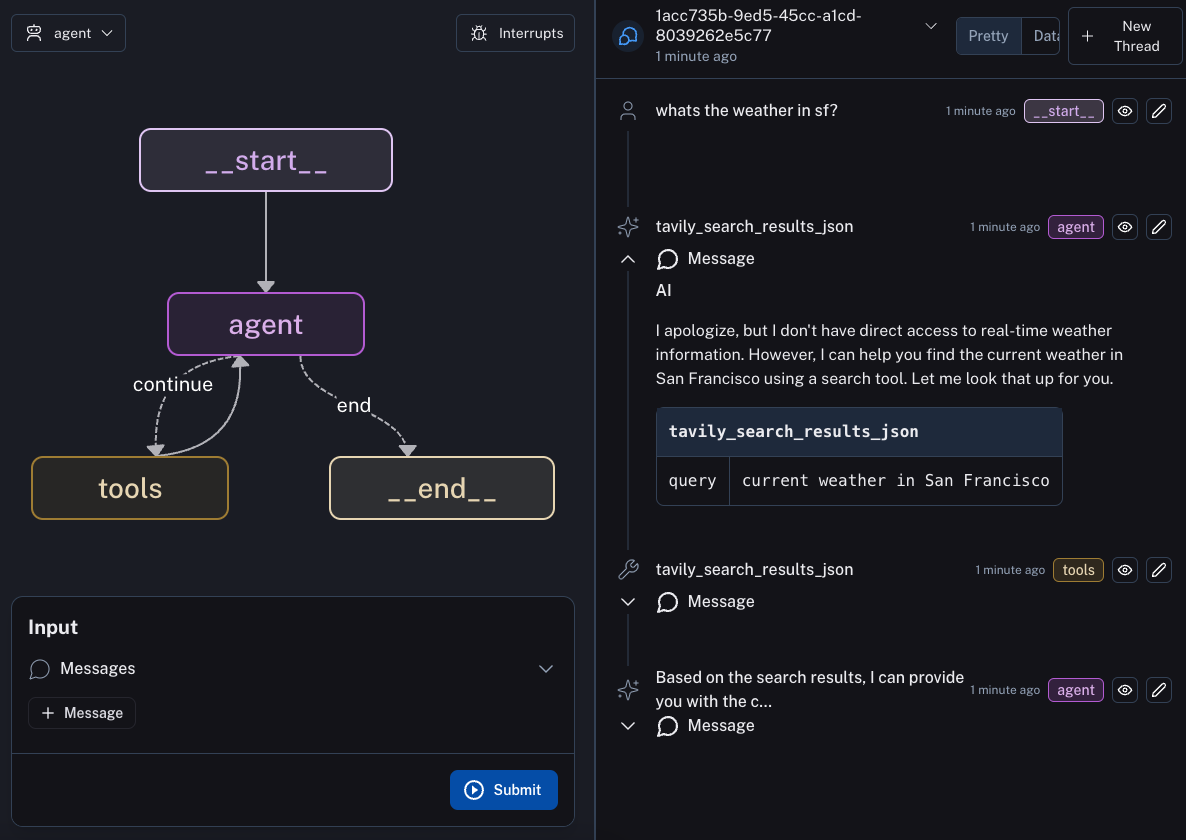

Il s'agit d'un exemple d'agent à déployer avec LangGraph Cloud.

Conseil

Si vous préférez utiliser pyproject.toml pour gérer les dépendances dans votre projet LangGraph Cloud, veuillez consulter ce référentiel.

LangGraph est une bibliothèque permettant de créer des applications multi-acteurs avec état avec des LLM. Les principaux cas d'utilisation de LangGraph sont les agents conversationnels et les applications LLM à exécution longue et en plusieurs étapes ou toute application LLM qui bénéficierait d'une prise en charge intégrée des points de contrôle persistants, des cycles et des interactions humaines dans la boucle (c.-à-d. LLM et collaboration humaine).

LangGraph réduit le délai de mise sur le marché pour les développeurs utilisant LangGraph, avec une commande unique pour démarrer un microservice HTTP prêt pour la production pour vos applications LangGraph, avec persistance intégrée. Cela vous permet de vous concentrer sur la logique de votre graphique LangGraph et de nous confier la mise à l'échelle et la conception de l'API. L'API est inspirée de l'API des assistants OpenAI et est conçue pour s'intégrer à vos services existants.

Afin de déployer cet agent sur LangGraph Cloud, vous devez d'abord créer ce dépôt. Après cela, vous pouvez suivre les instructions ici pour déployer sur LangGraph Cloud.