Superbe enquête AGI

Articles incontournables sur l'intelligence générale artificielle

? Nouvelles

- [2024-10] ? Notre article a été accepté par TMLR 2024.

- [2024-05] ? Nous organisons un atelier AGI à l'ICLR 2024 et avons publié notre document de position, « Jusqu'où sommes-nous de l'AGI ?

Notre projet est une initiative continue et ouverte qui évoluera parallèlement aux progrès de l'AGI. Nous apprécions chaleureusement les commentaires et les demandes de tirage de la communauté et prévoyons de mettre à jour notre article chaque année. Les contributeurs sur le site Web du projet seront reconnaissants dans les futures révisions.

Citation BibTex si vous trouvez notre travail/ressources utiles :

@article { feng2024far ,

title = { How Far Are We From AGI } ,

author = { Feng, Tao and Jin, Chuanyang and Liu, Jingyu and Zhu, Kunlun and Tu, Haoqin and Cheng, Zirui and Lin, Guanyu and You, Jiaxuan } ,

journal = { arXiv preprint arXiv:2405.10313 } ,

year = { 2024 }

} Contenu

- Contenu

- 1. Introduction

- 2. AGI interne : dévoiler l'esprit d'AGI

- 2.1 Perception de l'IA

- 2.2 Raisonnement de l'IA

- 2.3 Mémoire IA

- 2.4 Métacognition de l'IA

- 3. Interface AGI : connecter le monde avec AGI

- 3.1 Interfaces de l'IA avec le monde numérique

- 3.2 Interfaces de l'IA avec le monde physique

- 3.3 Interfaces de l'IA avec le renseignement

- 3.3.1 Interfaces IA vers les agents IA

- 3.3.2 Interfaces de l'IA avec l'humain

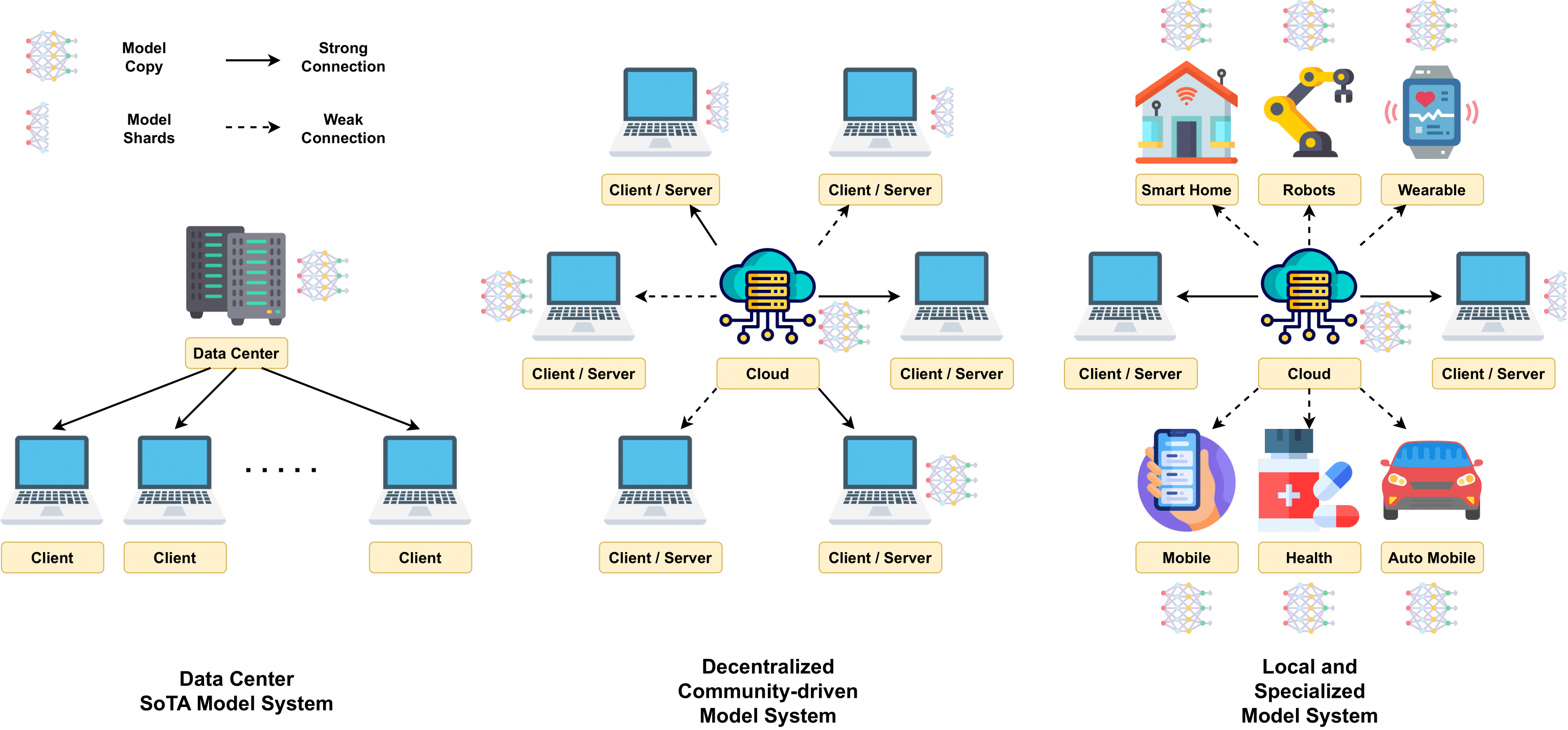

- 4. Systèmes AGI : mise en œuvre du mécanisme d'AGI

- 4.2 Architectures de modèles évolutives

- 4.3 Formation à grande échelle

- 4.4 Techniques d'inférence

- 4.5 Coût et efficacité

- 4.6 Plateformes informatiques

- 5. Alignement de l'AGI : garantir que l'AGI réponde à divers besoins

- 5.1 Attentes liées à l’alignement de l’AGI

- 5.2 Techniques d'alignement actuelles

- 5.3 Comment aborder les alignements AGI

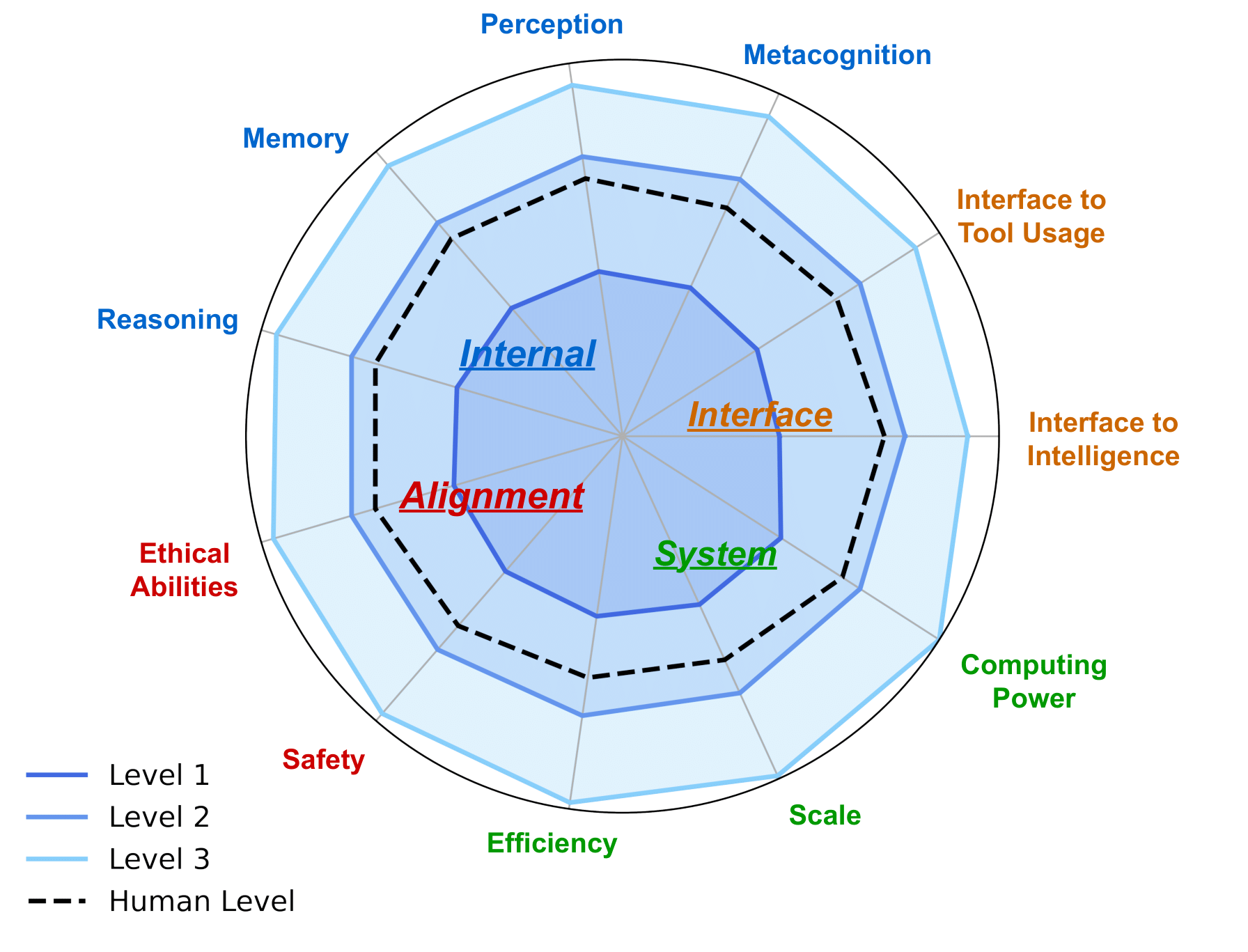

- 6. Feuille de route AGI : approcher l’AGI de manière responsable

- 6.1 Niveaux d'IA : suivre l'évolution de l'intelligence artificielle

- 6.2 Évaluation de l'IAG

- 6.2.1 Attentes concernant l'évaluation de l'AGI

- 6.2.2 Évaluations actuelles et leurs limites

- 6.5 Autres considérations lors du développement d'AGI

- 7. Études de cas

- 7.1 L'IA pour la découverte et la recherche scientifiques

- 7.2 Intelligence visuelle générative

- 7.3 Modèles mondiaux

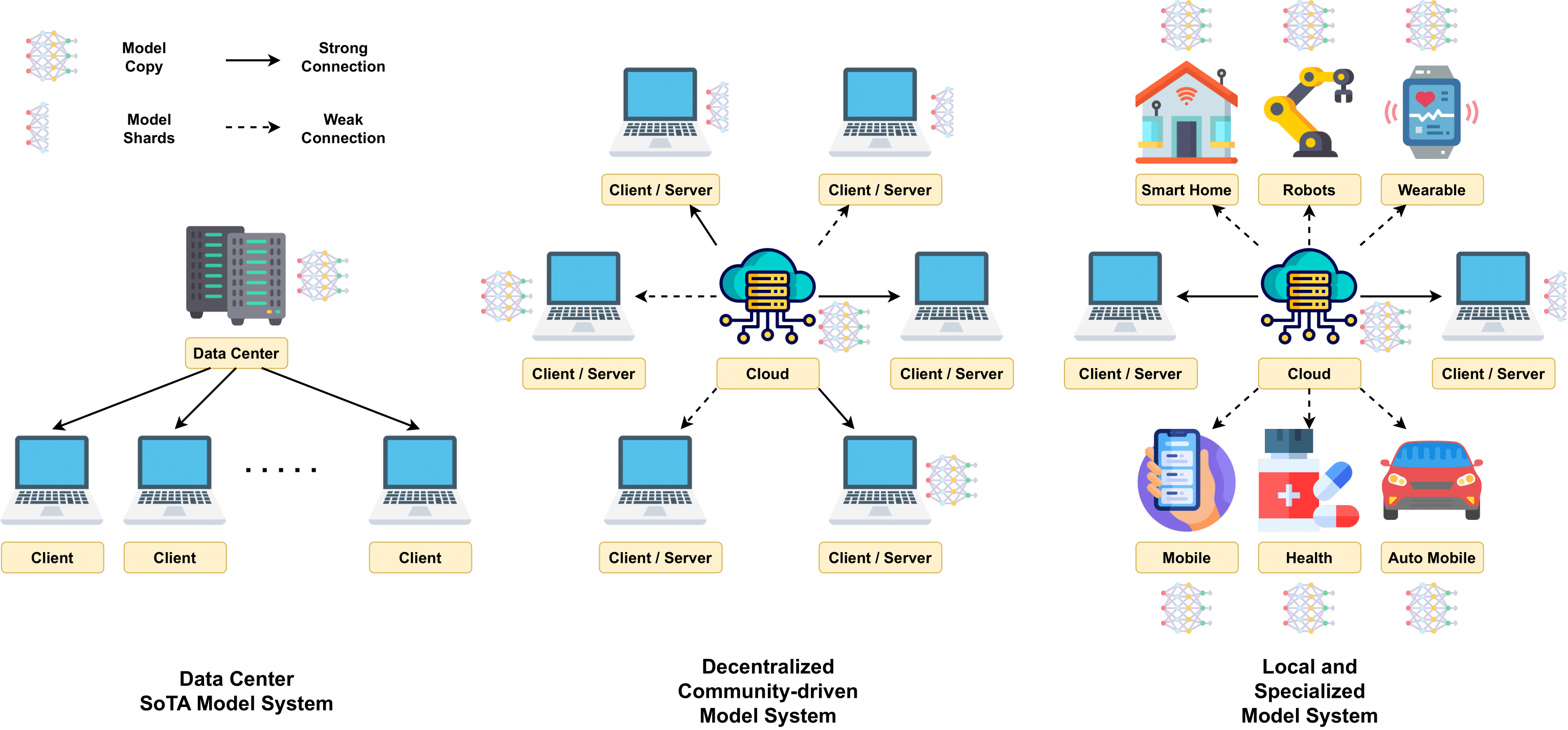

- 7.4 LLM décentralisé

- 7.5 IA pour le codage

- 7.6 IA pour la robotique dans les applications du monde réel

- 7.7 Collaboration homme-IA

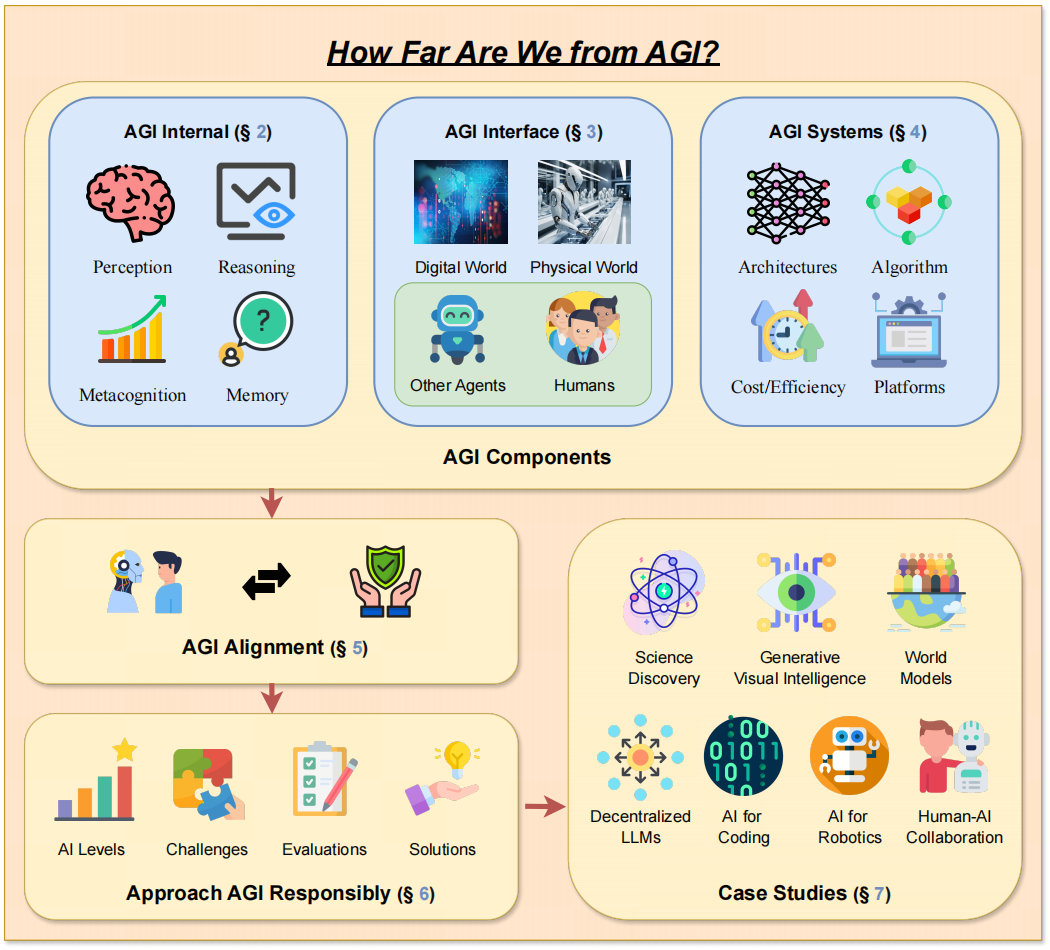

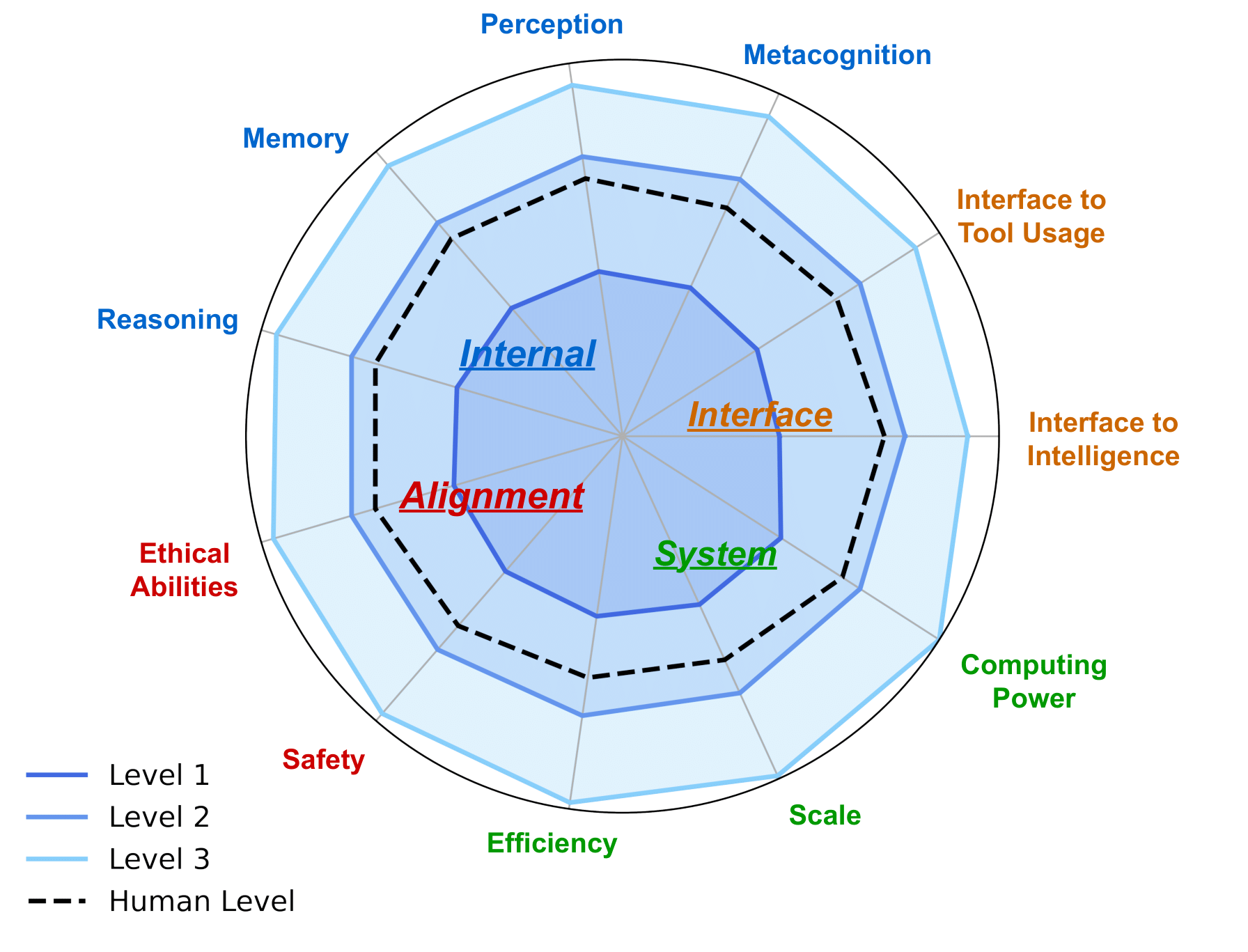

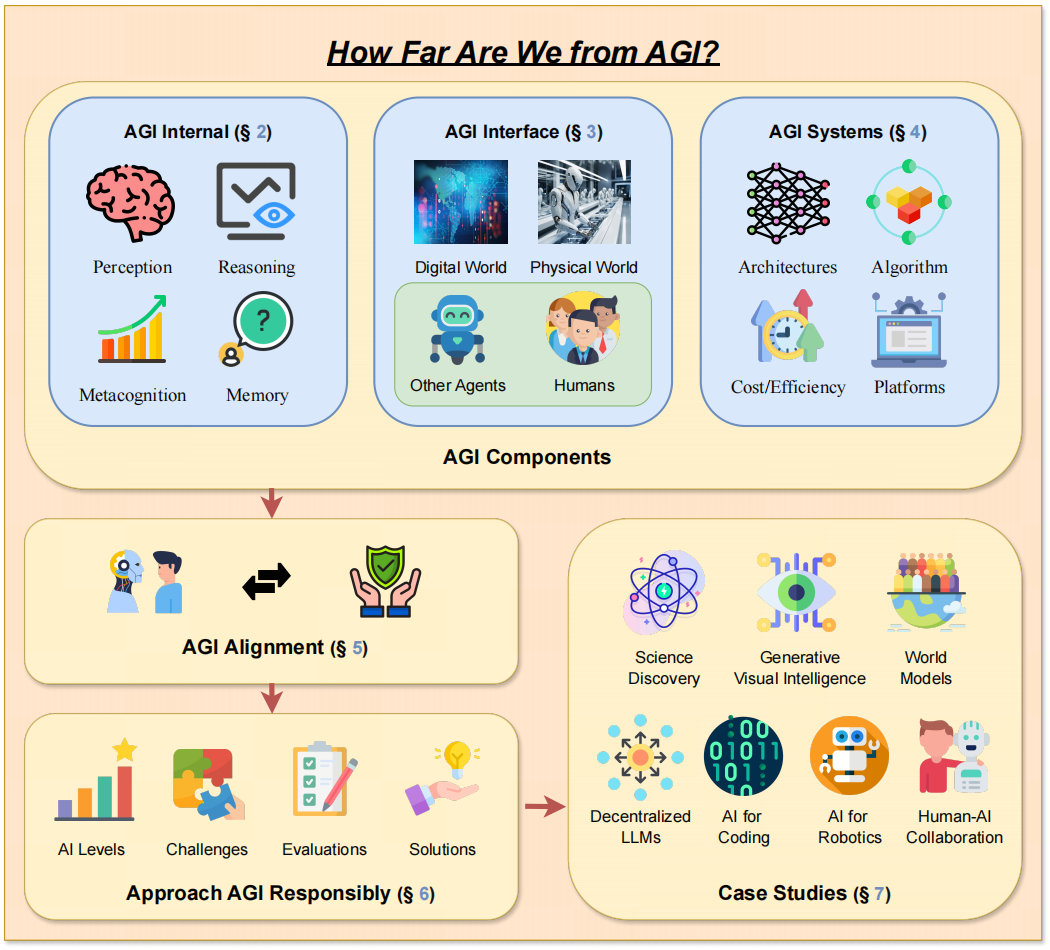

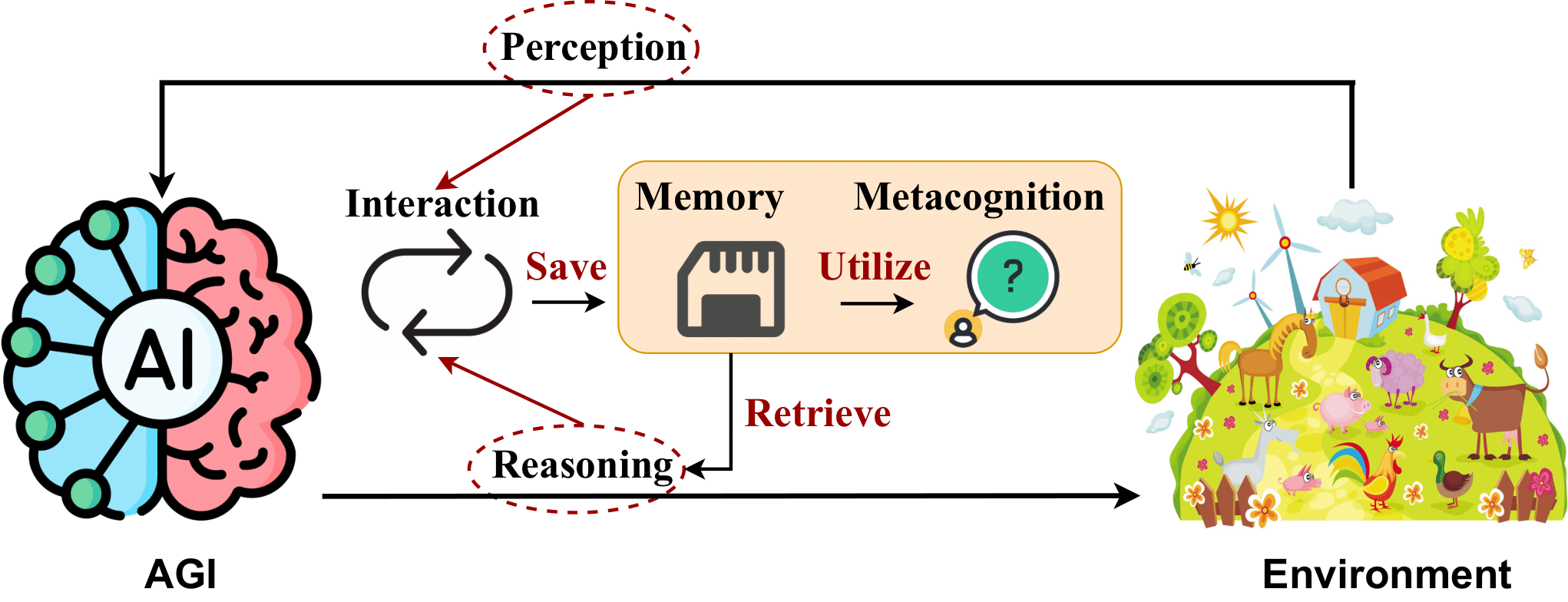

-> La conception du cadre de notre article. <-

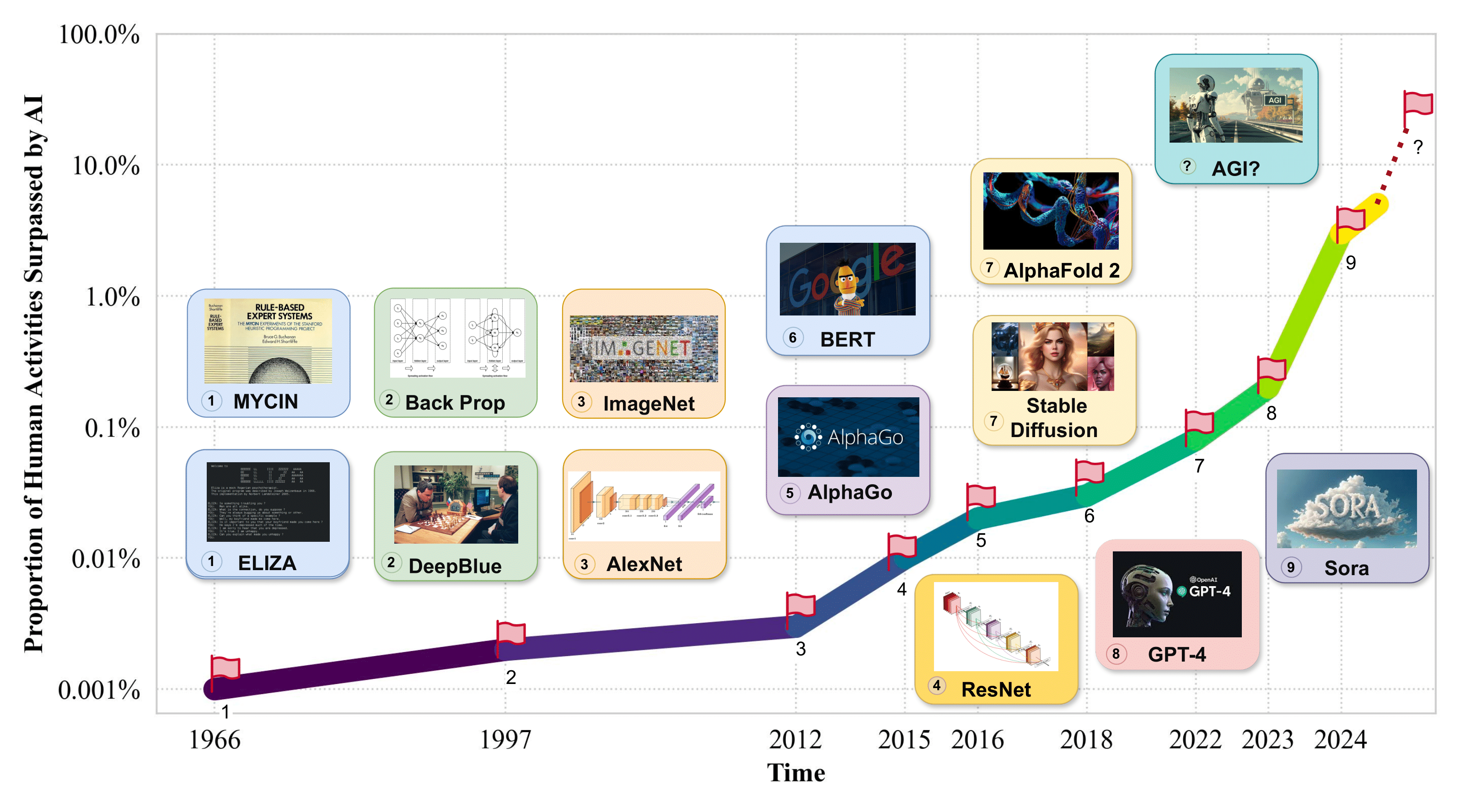

1. Introduction

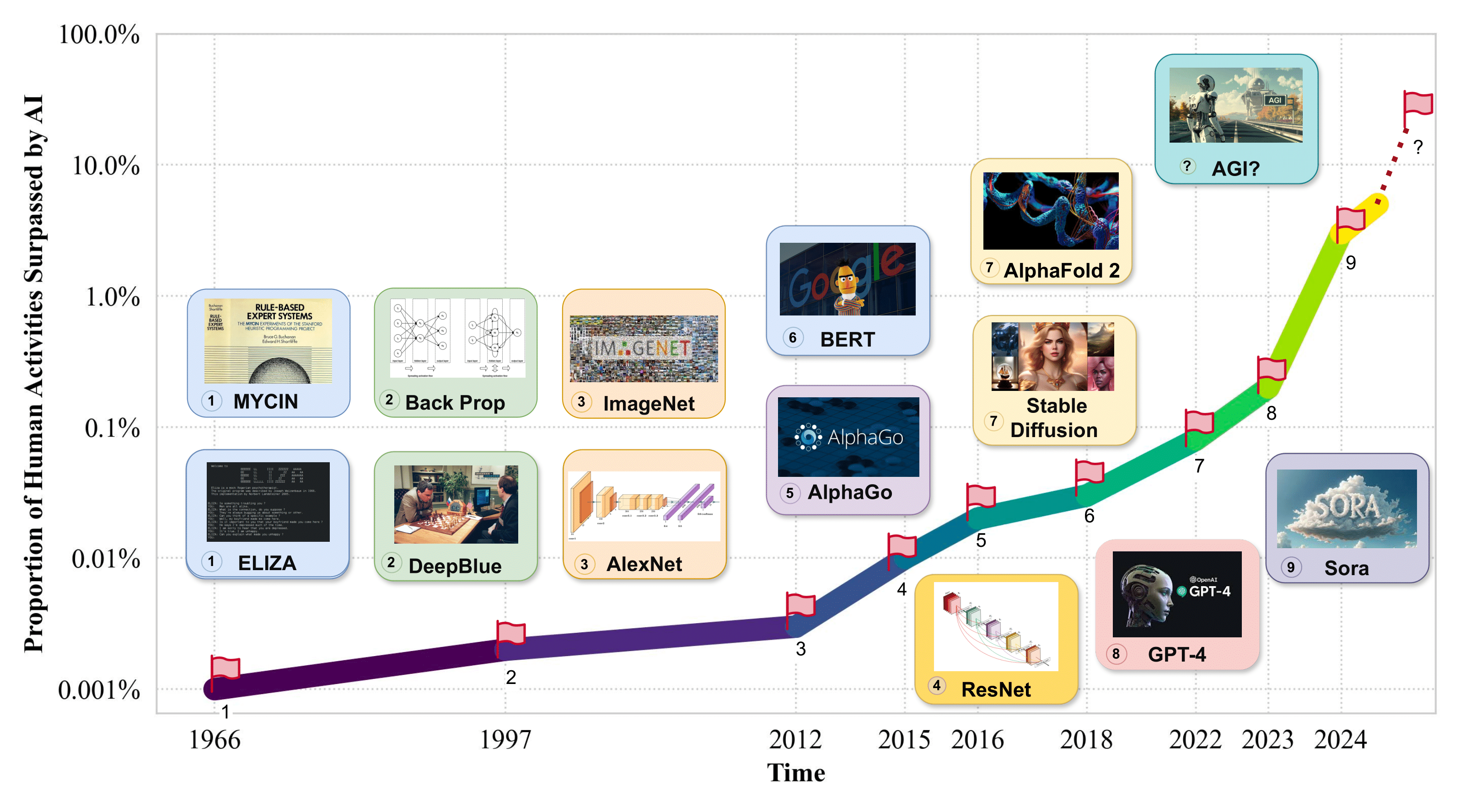

-> Proportion des activités humaines dépassée par l'IA. <-

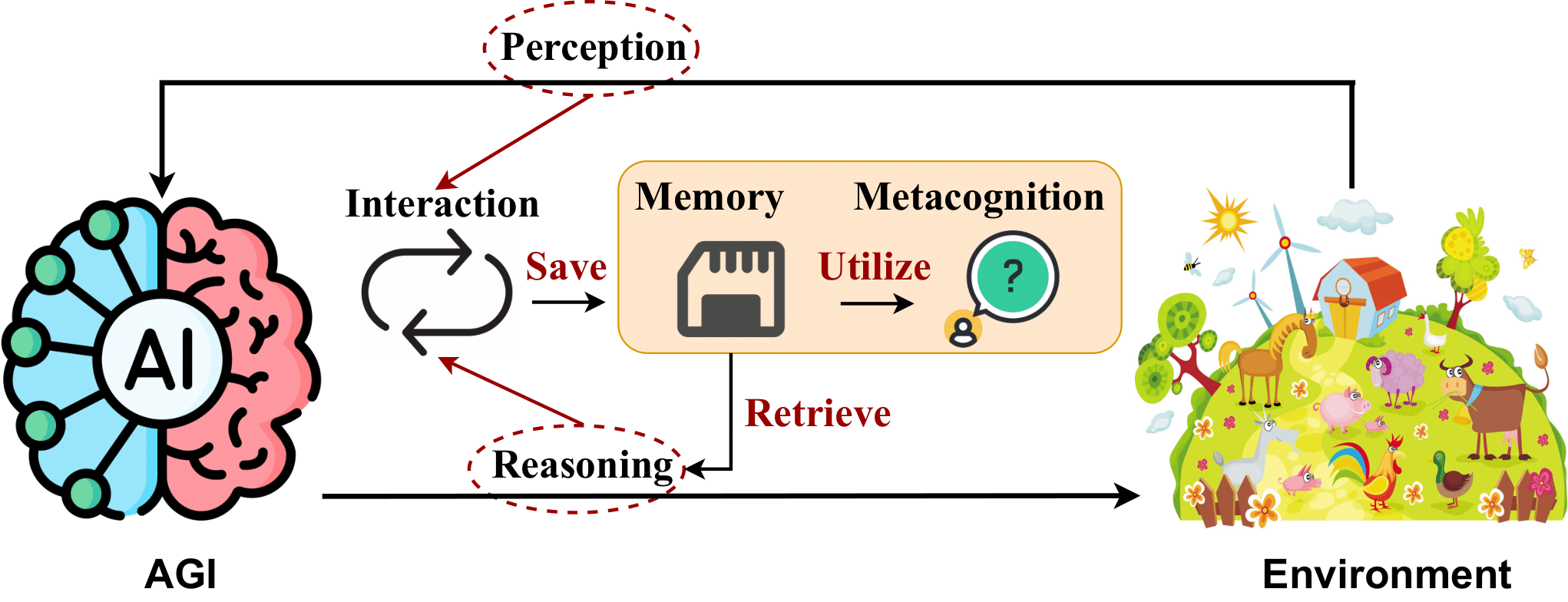

2. AGI interne : dévoiler l'esprit d'AGI

2.1 Perception de l'IA

- Flamingo : un modèle de langage visuel pour un apprentissage en quelques étapes . Jean-Baptiste Alayrac et al. NeurIPS 2022. [article]

- BLIP-2 : Pré-formation d'amorçage du langage-image avec des encodeurs d'images gelées et de grands modèles de langage . Junnan Li et coll. ICML 2023. [article]

- SPHINX : le mélange conjoint de poids, de tâches et d'intégrations visuelles pour les grands modèles de langage multimodaux . Ziyi Lin et coll. EMNLP 2023. [papier]

- Réglage des instructions visuelles . Haotian Liu et coll. NeurIPS 2023. [article]

- GPT4Tools : Enseigner à un grand modèle de langage l'utilisation d'outils via l'auto-apprentissage . Rui Yang et coll. NeurIPS 2023. [article]

- Otter : un modèle multimodal avec réglage des instructions en contexte . Bo Li et coll. arXiv 2023. [papier]

- VideoChat : Compréhension vidéo centrée sur le chat . KunChang Li et al. arXiv 2023. [papier]

- mPLUG-Owl : la modularisation permet de créer de grands modèles de langage avec la multimodalité . Qinghao Ye et coll. arXiv 2023. [papier]

- Une enquête sur les grands modèles de langage multimodaux . Shukang Yin et coll. arXiv 2023. [papier]

- PandaGPT : un modèle pour les instructions : suivez-les tous . Yixuan Su et coll. arXiv 2023. [papier]

- LLaMA-Adapter : réglage fin efficace des modèles de langage avec une attention zéro-init . Renrui Zhang et coll. arXiv 2023. [papier]

- Gemini : une famille de modèles multimodaux hautement performants . Rohan Anil et coll. arXiv 2023. [papier]

- Shikra : Libérer la magie du dialogue référentiel multimodal LLM . Keqin Chen et coll. arXiv 2023. [papier]

- ImageBind : un espace d'intégration pour les lier tous . Rohit Girdhar et coll. CVPR 2023. [papier]

- MobileVLM : un assistant linguistique à vision rapide, puissant et ouvert pour les appareils mobiles . Xiangxiang Chu et coll. arXiv 2023. [papier]

- Qu'est-ce qui fait de bons tokeniseurs visuels pour les grands modèles de langage ? . Guangzhi Wang et coll. arXiv 2023. [papier]

- MiniGPT-4 : Amélioration de la compréhension vision-langage avec des modèles de langage étendus avancés . Deyao Zhu et coll. ICLR 2024. [article]

- LanguageBind : Extension de la pré-formation vidéo-langage à la modalité N par un alignement sémantique basé sur le langage . Bin Zhu et coll. ICLR 2024. [article]

2.2 Raisonnement de l'IA

- L'incitation à la chaîne de pensée suscite un raisonnement dans de grands modèles de langage . Jason Wei et coll. NeurIPS 2022. [article]

- Théorie neuronale de l’esprit ? Sur les limites de l'intelligence sociale dans les grands LM . Maarten Sap et coll. EMNLP 2022. [papier]

- Monologue intérieur : raisonnement incarné grâce à la planification avec des modèles de langage . Wenlong Huang et coll. CoRL 2022. [article]

- Enquête sur les hallucinations dans la génération du langage naturel . Ziwei Ji et coll. Enquêtes informatiques ACM 2022. [papier]

- ReAct : mettre en synergie le raisonnement et l'action dans les modèles linguistiques . Shunyu Yao et coll. ICLR 2023. [article]

- Invite décomposée : une approche modulaire pour résoudre des tâches complexes . Tushar Khot et coll. ICLR 2023. [article]

- Invite basée sur la complexité pour un raisonnement en plusieurs étapes . Yao Fu et coll. ICLR 2023. [article]

- Les invites du moins au plus permettent un raisonnement complexe dans de grands modèles de langage . Denny Zhou et coll. ICLR 2023. [article]

- Vers le raisonnement dans les grands modèles linguistiques : une enquête . Jie Huang et coll. Résultats de l'ACL 2023. [article]

- ProgPrompt : Génération de plans de tâches de robot localisés à l'aide de grands modèles de langage . Ishika Singh et coll. ICRA 2023. [papier]

- Raisonner avec un modèle linguistique, c'est planifier avec un modèle mondial . Shibo Hao et coll. EMNLP 2023. [papier]

- Évaluation des hallucinations d'objets dans les grands modèles de langage de vision . Yifan Li et coll. EMNLP 2023. [papier]

- Arbre de pensées : résolution délibérée de problèmes avec de grands modèles de langage . Shunyu Yao et coll. NeurIPS 2023. [article]

- Auto-raffinement : raffinement itératif avec auto-rétroaction . Aman Madaan et coll. NeurIPS 2023. [article]

- Réflexion : Agents linguistiques avec apprentissage par renforcement verbal . Noah Shinn et coll. NeurIPS 2023. [article]

- Décrire, expliquer, planifier et sélectionner : la planification interactive avec de grands modèles de langage permet des agents multitâches en monde ouvert . Zihao Wang et coll. NeurIPS 2023. [article]

- LLM+P : Renforcer les grands modèles de langage avec une maîtrise optimale de la planification . Bo Liu et coll. arXiv 2023. [papier]

- Modèles de langage, modèles d'agents et modèles mondiaux : la LOI pour le raisonnement et la planification automatiques . Zhiting Hu et coll. arXiv 2023. [papier]

- MMToM-QA : Réponse aux questions sur la théorie multimodale de l'esprit . Chuanyang Jin et coll. arXiv 2024. [papier]

- Graphique de réflexion : Résoudre des problèmes élaborés avec de grands modèles de langage . Maciej Besta et coll. AAAI 2024. [papier]

- Atteindre >97 % sur GSM8K : une compréhension approfondie des problèmes fait des LLM de parfaits raisonneurs . Qihuang Zhong et coll. arXiv 2024. [papier] en attente

2.3 Mémoire IA

- Récupération de passages denses pour la réponse aux questions en domaine ouvert . Vladimir Karpukhin et coll. EMNLP 2020. [article]

- Génération augmentée par récupération pour les tâches PNL à forte intensité de connaissances . Patrick Lewis et coll. NeurIPS 2020. [article]

- REALM : pré-formation sur le modèle de langage augmenté par récupération . Kelvin Guu et coll. ICML 2020. [article]

- L'augmentation de la récupération réduit les hallucinations dans la conversation . Kurt Shuster et coll. Résultats de l'EMNLP 2021. [article]

- Améliorer les modèles linguistiques en récupérant des milliards de jetons . Sébastien Borgeaud et al. ICML 2022. [article]

- Agents générateurs : simulacres interactifs du comportement humain . Joon Sung Park et coll. UIST 2023. [article]

- Architectures cognitives pour les agents linguistiques . Théodore R. Sumers et coll. TMLR 2024. [papier]

- Voyager : un agent incorporé ouvert avec de grands modèles de langage . Guanzhi Wang et coll. arXiv 2023. [papier]

- Une enquête sur le mécanisme de mémoire des agents basés sur de grands modèles de langage . Zeyu Zhang et coll. arXiv 2024. [papier]

- La synthèse récursive permet une mémoire de dialogue à long terme dans de grands modèles de langage . Qingyue Wang et coll. arXiv 2023. [papier] en attente

2.4 Métacognition de l'IA

- La prise en compte des méta-capacités dans l'externalisation des connaissances tacites et l'apprentissage organisationnel . Jyoti Choudrie et coll. HICSS 2006. [article]

- "Évolution des réseaux de neurones auto-supervisés, intelligence autonome issue de l'auto-apprentissage évolué" . Nam Le . arXiv 2019. [papier]

- Améliorer les modèles linguistiques pré-entraînés pour les apprenants débutants . Tianyu Gao et coll. ACL 2021. [papier]

- Identifier et manipuler les traits de personnalité des modèles linguistiques . Graham Caron et coll. arXiv 2022. [papier]

- Brainish : Formaliser un langage multimodal pour l'intelligence et la conscience . Paul Liang et coll. arXiv 2022. [papier]

- Une théorie de la conscience du point de vue de l'informatique théorique : aperçus de la machine de Turing consciente . Lénore Blum et coll. PNAS 2022. [papier]

- WizardLM : permettre aux grands modèles de langage de suivre des instructions complexes . Xu et al. arXiv 2023. [papier]

- Auto-instruction : aligner les modèles de langage avec les instructions auto-générées . Yizhong Wang et coll. ACL 2023. [papier]

- ReST rencontre ReAct : auto-amélioration pour l'agent LLM de raisonnement en plusieurs étapes . Renat Aksitov et al. arXiv 2023. [papier]

- La psychologie culturelle des grands modèles linguistiques : ChatGPT est-il un penseur holistique ou analytique ? . Chuanyang Jin et coll. arXiv 2023. [papier]

- La conscience dans l'intelligence artificielle : aperçus de la science de la conscience . Patrick Butlin et coll. arXiv 2023. [papier]

- Revisiter la fiabilité des échelles psychologiques sur de grands modèles de langage . Jen-tse Huang et al. arXiv 2023. [papier]

- Évaluation et induction de la personnalité dans des modèles linguistiques pré-entraînés . Guangyuan Jiang et coll. NeurIPS 2024. [article]

- Niveaux d'AGI : opérationnaliser les progrès sur la voie de l'AGI . Meredith Ringel Morris et coll. arXiv 2024. [papier] en attente

- Enquêter-Consolider-Exploiter : Une stratégie générale pour l'auto-évolution des agents inter-tâches . Cheng Qian et coll. arXiv 2024. [papier] en attente

3. Interface AGI : connecter le monde avec AGI

3.1 Interfaces de l'IA avec le monde numérique

- Principes des interfaces utilisateur à initiative mixte . Éric Horvitz. SIGCHI 1999. [papier]

- L'essor et le potentiel des grands agents basés sur des modèles de langage : une enquête . Zhiheng Xi et coll. arXiv 2023. [papier]

- Apprentissage d'outils avec des modèles de base . Yujia Qin et coll. arXiv 2023. [papier]

- Créateur : Démêler les raisonnements abstraits et concrets de grands modèles de langage grâce à la création d'outils . Cheng Qian et coll. arXiv 2023. [papier]

- AppAgent : agents multimodaux en tant qu'utilisateurs de smartphones . Zhao Yang et coll. arXiv 2023. [papier]

- Mind2Web : Vers un agent généraliste du Web . Xiang Deng et coll. Benchmark NeurIPS 2023. [article]

- ToolQA : un ensemble de données pour la réponse aux questions LLM avec des outils externes . Yuchen Zhuang et coll. arXiv 2023. [papier]

- Agents générateurs : simulacres interactifs du comportement humain . Joon Sung Park et coll. arXiv 2023. [papier]

- Toolformer : les modèles de langage peuvent apprendre eux-mêmes à utiliser des outils . Timo Schick et coll. arXiv 2023. [papier]

- Gorilla : un grand modèle de langage connecté à des API massives . Shishir G Patil et coll. arXiv 2023. [papier]

- Voyager : un agent incarné ouvert avec de grands modèles de langage . Guanzhi Wang et coll. arXiv 2023. [papier]

- OS-Copilot : Vers des agents informatiques généralistes avec auto-amélioration . Zhiyong Wu et coll. arXiv 2024. [papier]

- WebArena : un environnement Web réaliste pour créer des agents autonomes . Shuyan Zhou et coll. ICLR 2024. [article]

- Grands modèles de langage en tant que créateurs d'outils . Tianle Cai et coll. ICLR 2024. [article]

3.2 Interfaces de l'IA avec le monde physique

- Leçons du défi Amazon Picking : quatre aspects de la construction de systèmes robotiques . Clemens Eppner et coll. RSS 2016. [article]

- Perceiver-Actor : un transformateur multitâche pour la manipulation robotique . Mohit Shridhar et coll. arXiv 2022. [papier]

- Vima : Manipulation générale du robot avec des invites multimodales . Yunfan Jiang et coll. arXiv 2022. [papier]

- "Faites ce que je peux, pas ce que je dis : ancrer le langage dans les moyens robotiques" . Michael Ahn et coll. arXiv 2022. [papier]

- Voxposer : cartes de valeurs 3D composables pour la manipulation robotique avec des modèles de langage . Wenlong Huang et coll. arXiv 2023. [papier]

- MotionGPT : le mouvement humain comme langue étrangère . Biao Jiang et coll. arXiv 2023. [papier]

- "Rt-2 : Les modèles vision-langage-action transfèrent les connaissances du Web au contrôle robotique" . Anthony Brohan et coll. arXiv 2023. [papier]

- Navigation vers des objets du monde réel . Théophile Gervet et al. Science Robotique 2023. [article]

- Lm-nav : navigation robotique avec de grands modèles pré-entraînés de langage, de vision et d'action . Dhruv Shah et coll. CRL 2023. [papier]

- Palm-e : un modèle de langage multimodal incorporé . Danny Driess et coll. arXiv 2023. [papier]

- LLM-Planner : Planification en quelques étapes pour les agents incorporés avec de grands modèles de langage . Chan Hee Song et coll. ICCV 2023. [papier]

- Instruct2Act : Mappage d'instructions multimodalités à des actions robotiques avec un grand modèle de langage . Siyuan Huang et coll. arXiv 2023. [papier]

- DROID : un ensemble de données de manipulation de robots à grande échelle dans la nature . Alexandre Khazatsky et coll. arXiv 2024. [papier]

- BEHAVIOR-1K : une référence d'IA incarnée et centrée sur l'humain avec 1 000 activités quotidiennes et une simulation réaliste . Chengshu Li et coll. arXiv 2024. [papier]

3.3 Interfaces de l'IA avec le renseignement

3.3.1 Interfaces IA vers les agents IA

- "Gradients politiques multi-agents contrefactuels" . Jakob Foerster et coll. AAAI 2018. [article]

- Les explications issues de grands modèles de langage améliorent les petits raisonneurs . Shiyang Li et coll. arXiv 2022. [papier]

- Distillation de l'apprentissage en contexte : transfert de la capacité d'apprentissage en quelques étapes de modèles linguistiques pré-entraînés . Yukun Huang et coll. arXiv 2022. [papier]

- Autoagents : un cadre pour la génération automatique d'agents . Guangyao Chen et coll. arXiv 2023. [papier]

- "Inférence neuronale amortie pour le raisonnement multi-agents imbriqué" . Kunal Jha et coll. arXiv 2023. [papier]

- Distillation des connaissances de grands modèles de langage . Yuxian Gu et coll. arXiv 2023. [papier]

- Metagpt : Métaprogrammation pour framework collaboratif multi-agents . Sirui Hong et coll. arXiv 2023. [papier]

- Décrire, expliquer, planifier et sélectionner : la planification interactive avec de grands modèles de langage permet aux agents multitâches en monde ouvert . Zihao Wang et coll. arXiv 2023. [papier]

- Agentverse : faciliter la collaboration multi-agents et explorer les comportements émergents chez les agents . Weize Chen et coll. arXiv 2023. [papier]

- Mindstorms dans les sociétés mentales basées sur le langage naturel . Mingchen Zhuge et coll. arXiv 2023. [papier]

- Jarvis-1 : agents multitâches en monde ouvert avec modèles de langage multimodal à mémoire augmentée . Zihao Wang et coll. arXiv 2023. [papier]

- Distillation symbolique de la chaîne de pensée : les petits modèles peuvent également « penser » étape par étape . Liunian Harold Li et al. ACL 2023. [papier]

- Distiller étape par étape ! surpassant les modèles de langage plus grands avec moins de données de formation et des tailles de modèle plus petites . Cheng-Yu Hsieh et al. arXiv 2023. [papier]

- Généralisation de faible à fort : obtenir de fortes capacités avec une faible supervision . Collin Burns et coll. arXiv 2023. [papier]

- Améliorer les modèles de langage de discussion en mettant à l'échelle des conversations pédagogiques de haute qualité . Ning Ding et coll. arXiv 2023. [papier]

- GAIA : une référence pour les Assistants Généraux IA . Grégoire Mialon et al. ICLR 2024. [article]

- Voyager : un agent incarné ouvert avec de grands modèles de langage . Guanzhi Wang et coll. arXiv 2023. [papier]

- Camel : Agents de communication pour l'exploration « mentale » d'une société modèle linguistique à grande échelle . Guohao Li et coll. arXiv 2023. [papier]

- "Adapter les auto-rationalisateurs avec une distillation multi-récompense" . Sahana Ramnath et coll. arXiv 2023. [papier]

- Superalignement de la vision : généralisation de faible à fort pour les modèles de fondation de vision . Jianyuan Guo et coll. arXiv 2024. [papier]

- WebArena : un environnement Web réaliste pour créer des agents autonomes . Shuyan Zhou et coll. ICLR 2024. [article]

- Auto-alignement basé sur des principes des modèles de langage à partir de zéro avec une supervision humaine minimale . Zhiqing Sun et coll. NeurIPS 2024. [article]

- Mind2web : Vers un agent généraliste du web . Xiang Deng et coll. NeurIPS 2024. [article]

- Vers un contrôle informatique général : un agent multimodal pour Red Dead Redemption II comme étude de cas . Weihao Tan et coll. arXiv 2024. [papier]

3.3.2 Interfaces de l'IA avec l'humain

- Lignes directrices pour l’interaction homme-IA . Saleema Amershi et coll. CHI 2019. [papier]

- Principes de conception pour les applications d'IA générative . Justin D. Weisz et coll. CHI 2024. [papier]

- Graphologue : Explorer les réponses d'un grand modèle de langage avec des diagrammes interactifs . Peiling Jiang et coll. UIST 2023. [article]

- Sensecape : permettre l'exploration et la création de sens à plusieurs niveaux avec de grands modèles de langage . Sangho Suh et coll. UIST 2023. [article]

- Prise en charge de la création de sens à grande échelle pour les résultats de modèles de langage à grande échelle . Katy Ilonka Gero et al. CHI 2024. [papier]

- Luminate : génération structurée et exploration de l'espace de conception avec de grands modèles de langage pour la co-création homme-IA . Sangho Suh et coll. CHI 2024. [Papier]

- Chaînes d'IA : interaction homme-IA transparente et contrôlable en chaînant les invites d'un grand modèle de langage . Tongshuang Wu et coll. CHI 2022. [papier]

- Promptify : génération de texte en image grâce à l'exploration interactive d'invites avec de grands modèles de langage . Stephen Brade et coll. CHI 2023. [papier]

- ChainForge : une boîte à outils visuelle pour l'ingénierie rapide et les tests d'hypothèses LLM . Ian Arawjo et coll. CHI 2024. [papier]

- CoPrompt : prise en charge du partage d'invites et du référencement dans la programmation collaborative en langage naturel . Li Feng et coll. CHI 2024. [papier]

- Génération de commentaires automatiques sur les maquettes d'interface utilisateur avec de grands modèles de langage . Peitong Duan et coll. CHI 2024. [papier]

- Rambler : prise en charge de l'écriture avec la parole via la manipulation de l'essentiel assistée par LLM . Susan Lin et coll. CHI 2024. [papier]

- Intégration de grands modèles linguistiques dans la réalité étendue : opportunités et défis en matière d'inclusion, d'engagement et de confidentialité . Efe Bozkir et coll. arXiv 2024. [papier]

- GenAssist : Rendre la génération d'images accessible . Mina Huh et coll. UIST 2023. [article]

- « Moins je tape, mieux c'est » : comment les modèles de langage d'IA peuvent améliorer ou entraver la communication pour les utilisateurs de CAA . Stéphanie Valencia et al. CHI 2023. [papier]

- Réexaminer si, pourquoi et comment l'interaction homme-IA est particulièrement difficile à concevoir . Qian Yang et coll. CHI 2020. [papier]

4. Systèmes AGI : mise en œuvre du mécanisme d'AGI

4.2 Architectures de modèles évolutives

- "Réseaux de neurones incroyablement grands : la couche de mélange d'experts à grille clairsemée" . Noam Shazeer et coll. arXiv 2017. [article]

- Les transformateurs sont des RNN : des transformateurs autorégressifs rapides avec attention linéaire . Angelos Katharopoulos et coll. arXiv 2020. [papier]

- Longformer : le transformateur de documents longs . Iz Beltagy et al. arXiv 2020. [papier]

- LightSeq : une bibliothèque d'inférence haute performance pour les transformateurs . Xiaohui Wang et coll. arXiv 2021. [papier]

- Transformateurs de commutation : mise à l'échelle jusqu'à des milliards de modèles de paramètres avec une parcimonie simple et efficace . William Fedus et coll. arXiv 2022. [papier]

- Modélisation efficace de longues séquences avec des espaces d'états structurés . Albert Gu et coll. arXiv 2022. [papier]

- MegaBlocks : formation clairsemée efficace avec un mélange d'experts . Trevor Gale et coll. arXiv 2022. [papier]

- Formation de grands modèles de langage optimisés pour le calcul . Jordan Hoffmann et coll. arXiv 2022. [papier]

- Mise à l'échelle efficace des modèles de base dans un contexte long . Wenhan Xiong et coll. arXiv 2023. [papier]

- Hiérarchie des hyènes : vers des modèles de langage convolutif plus larges . Michael Poli et coll. arXiv 2023. [papier]

- Stanford Alpaca : un modèle LLaMA qui suit les instructions . Rohan Taori et coll. GitHub 2023. [code]

- "Rwkv : Réinventer les RNN pour l'ère des transformateurs" . Bo Peng et coll. arXiv 2023. [papier]

- Déjà vu : parcimonie contextuelle pour des LLM efficaces au moment de l'inférence . Zichang Liu et coll. arXiv 2023. [papier]

- Flash-LLM : permettre une inférence de grand modèle génératif rentable et très efficace avec une parcimonie non structurée . Haojun Xia et coll. arXiv 2023. [papier]

- ByteTransformer : un transformateur haute performance amélioré pour les entrées de longueur variable . Yujia Zhai et coll. arXiv 2023. [papier]

- Tutel : mélange adaptatif d'experts à grande échelle . Changho Hwang et coll. arXiv 2023. [papier]

- Mamba : Modélisation de séquences temporelles linéaires avec des espaces d'états sélectifs . Albert Gu, Tri Dao. arXiv 2023. [papier]

- Hungry Hungry Hippos : vers une modélisation du langage avec des modèles spatiaux d'états . Daniel Y. Fu et coll. arXiv 2023. [papier]

- Réseau rétentif : un successeur du transformateur pour les grands modèles de langage . Yutao Sun et coll. ArXiv, 2023.

- Conception mécaniste et mise à l'échelle d'architectures hybrides . Michael Poli et coll. arXiv 2024. [papier]

- Revisiter la distillation des connaissances pour les modèles linguistiques autorégressifs . Qihuang Zhong et coll. arXiv 2024. [papier]

- DB-LLM : double binarisation précise pour des LLM efficaces . Hong Chen et coll. arXiv 2024. [papier]

- Réduction de la taille du cache de valeurs-clés du transformateur avec une attention multicouche . William Brandon et coll. arXiv 2024.[papier]

- Vous ne mettez en cache qu'une seule fois : architectures décodeur-décodeur pour les modèles de langage Yutao Sun et al. arXiv 2024. [papier]

4.3 Formation à grande échelle

- Formation de réseaux profonds avec un coût de mémoire sublinéaire . Tianqi Chen et coll. arXiv 2016. [article]

- Au-delà du parallélisme des données et des modèles pour les réseaux de neurones profonds . Zhihao Jia et coll. arXiv 2018. [papier]

- GPipe : formation efficace de réseaux de neurones géants utilisant le parallélisme de pipeline . Yanping Huang et coll. arXiv 2019. [papier]

- Apprentissage par transfert efficace des paramètres pour la PNL . Neil Houlsby et coll. ICML 2019. article

- Megatron-LM : formation de modèles de langage de paramètres de plusieurs milliards à l'aide du parallélisme de modèles . Mohammad Shoeybi et coll. arXiv 2020. [papier]

- Alpa : Automatisation du parallélisme inter et intra-opérateur pour le Deep Learning distribué . Lianmin Zheng et coll. arXiv 2022. [papier]

- Inférence DeepSpeed : permettre une inférence efficace de modèles de transformateurs à une échelle sans précédent . Reza Yazdani Aminabadi et al. arXiv 2022. [papier]

- Mémorisation sans surajustement : analyse de la dynamique de formation de grands modèles de langage . Kushal Tirumala et coll. arXiv 2022. [papier]

- Parallélisme SWARM : la formation de grands modèles peut être étonnamment efficace en termes de communication . Max Ryabinin et al. arXiv 2023. [papier]

- Trajectoires de formation des modèles de langage à travers les échelles . Mengzhou Xia et coll. arXiv 2023. [papier]

- HexGen : Inférence générative du modèle de fondation sur un environnement décentralisé hétérogène . Youhe Jiang et coll. arXiv 2023. [papier]

- FusionAI : formation décentralisée et déploiement de LLM avec des GPU massifs au niveau du consommateur . Zhenheng Tang et coll. arXiv 2023. [papier]

- Attirez l'attention avec des transformateurs par blocs pour un contexte presque infini . Hao Liu et coll. arXiv 2023. [papier]

- Pythia : une suite pour analyser de grands modèles de langage à travers la formation et la mise à l'échelle . Stella Biderman et coll. arXiv 2023. [papier]

- Affiner les modèles de langage sur des réseaux lents à l'aide de la compression d'activation avec garanties . Jue Wang et coll. arXiv 2023. [papier]

- LLaMA-Adapter : réglage fin efficace des modèles de langage avec une attention zéro-init . Renrui Zhang et coll. arXiv 2023. [papier]

- QLoRA : réglage fin efficace des LLM quantifiés . Tim Dettmers et coll. arXiv 2023. [papier]

- Gestion efficace de la mémoire pour la diffusion de modèles de langage étendus avec PagedAttention . Woosuk Kwon et coll. arXiv 2023. [papier]

- Infinite-LLM : service LLM efficace pour un contexte long avec DistAttention et KVCache distribué . Bin Lin et coll. arXiv 2024. [papier]

- OLMo : Accélérer la science des modèles linguistiques . Dirk Groeneveld et coll. arXiv 2024. [papier]

- Sur la formation efficace de modèles d'apprentissage profond à grande échelle : une revue de la littérature . Li Shen et coll. arXiv 2023. [papier] en attente

4.4 Techniques d'inférence

- FlashAttention : Attention exacte rapide et économe en mémoire avec IO-Awareness . Tri Dao et coll. NeurIPS 2022. [article]

- Brouillon et vérification : accélération sans perte d'un grand modèle de langage via le décodage auto-spéculatif . Jun Zhang et coll. arXiv 2023. [papier]

- Vers un service efficace de modèles de langage étendus génératifs : une enquête des algorithmes aux systèmes . Xupeng Miao et coll. arXiv 2023. [papier]

- FlashDecoding++ : inférence plus rapide de modèles de langage étendus sur les GPU . Ke Hong et coll. arXiv 2023. [papier]

- Inférence rapide à partir de transformateurs via le décodage spéculatif . Yaniv Léviathan et coll. arXiv 2023. [papier]

- Service d'inférence distribuée rapide pour les grands modèles de langage . Bingyang Wu et coll. arXiv 2023. [papier]

- S-LoRA : au service de milliers d'adaptateurs LoRA simultanés . Ying Sheng et coll. arXiv 2023. [papier]

- TensorRT-LLM : une boîte à outils TensorRT pour l'inférence optimisée de grands modèles de langage . Nvidia. GitHub 2023. [code]

- Punica : service LoRA multi-locataires . Lequn Chen et coll. arXiv 2023. [papier]

- S$^3 : augmentation de l'utilisation du GPU lors de l'inférence générative pour un débit plus élevé . Yunho Jin et coll. arXiv 2023. [papier]

- Serveur d'inférence multi-LoRA qui s'adapte à des milliers de LLM affinés . Prédibase. GitHub 2023. [code]

- Décodage de recherche rapide . Apoorv Saxena. GitHub 2023. [code]

- Transformateur plus rapide . Nvidia. GitHub 2021. [papier]

- DeepSpeed-FastGen : génération de texte à haut débit pour les LLM via MII et DeepSpeed-Inference . Connor Holmes et coll. arXiv 2024. [papier]

- SpecInfer : accélération de la diffusion de modèles de langage étendus génératifs avec inférence et vérification spéculatives basées sur une arborescence . Xupeng Miao et coll. arXiv 2024. [papier]

- Medusa : cadre d'accélération d'inférence LLM simple avec plusieurs têtes de décodage . Tianle Cai et coll. arXiv 2024. [papier]

- Le modèle vous indique ce qu'il faut supprimer : compression adaptative du cache KV pour les LLM . Suyu Ge et coll. ICLR 2024. [article]

- Modèles de langage de streaming efficaces avec récepteurs d'attention . Guangxuan Xiao et coll. ICLR 2024. [article]

- DeFT : Flash Tree-Attention avec IO-Awareness pour une inférence LLM efficace basée sur la recherche arborescente . Jinwei Yao et coll. arXiv 2024. [papier]

- Programmation efficace de grands modèles de langage à l'aide de SGLang . Lianmin Zheng et coll. arXiv 2023. [papier]

- VITESSE : exécution spéculative en pipeline pour un décodage efficace . Coleman Hooper et coll. arXiv 2023. [papier]

- Sequoia : décodage spéculatif évolutif, robuste et sensible au matériel . Zhuoming Chen et coll. arXiv 2024. [papier] en attente

4.5 Coût et efficacité

- Démonstration-Recherche-Prédiction : composition de modèles de récupération et de langage pour une PNL à forte intensité de connaissances . Omar Khattab et coll. arXiv 2023. [papier]

- Apprentissage automatique automatisé : méthodes, systèmes, défis . Frank Hutter et coll. Springer Publishing Company, constituée, 2019.

- Soupes de modèles : la moyenne des poids de plusieurs modèles affinés améliore la précision sans augmenter le temps d'inférence . Mitchell Wortsman et coll. arXiv 2022. [papier]

- Débogage de données avec Shapley Importance sur les pipelines d'apprentissage automatique de bout en bout . Bojan Karlaš et al. arXiv 2022. [papier]

- Optimisation rentable des hyperparamètres pour l'inférence de génération de modèles de langage à grande échelle . Chi Wang et coll. arXiv 2023. [papier]

- Les grands modèles de langage sont des ingénieurs rapides au niveau humain . Yongchao Zhou et coll. arXiv 2023. [papier]

- Fusion en faisant correspondre des modèles dans des sous-espaces de tâches . Derek Tam et coll. arXiv 2023. [papier]

- Modification de modèles avec l'arithmétique des tâches . Gabriel Ilharco et coll. arXiv 2023. [papier]

- PriorBand : optimisation pratique des hyperparamètres à l'ère du Deep Learning . Neeratyoy Mallik et coll. arXiv 2023. [papier]

- Une étude empirique de la fusion de modèles multimodaux . Yi-Lin Sung et coll. arXiv 2023. [papier]

- DSPy : Compilation d'appels de modèles de langage déclaratif dans des pipelines auto-améliorés . Omar Khattab et coll. arXiv 2023. [papier]

- FrugalGPT : Comment utiliser de grands modèles de langage tout en réduisant les coûts et en améliorant les performances . Lingjiao Chen et coll. arXiv 2023. [papier]

- Transformateurs tandem pour les LLM efficaces en inférence . Aishwarya PS et coll. arXiv 2024. [papier]

- AIOS : système d'exploitation d'agent LLM . Kai Mei et coll. arXiv 2024. [papier]

- LoraHub : généralisation efficace de tâches croisées via la composition dynamique LoRA . Chengsong Huang et coll. arXiv 2024. [papier]

- AutoML à l'ère des grands modèles de langage : défis actuels, opportunités et risques futurs . Alexandre Tornede et coll. arXiv 2024. [papier]

- Fusionner les experts en un seul : améliorer l'efficacité informatique du mélange d'experts . Shwai He et coll. EMNLP 2023. [article] en attente

4.6 Plateformes informatiques

- TVM : un compilateur d'optimisation automatisé de bout en bout pour le Deep Learning . Tianqi Chen et coll. arXiv 2018. [papier]

- TPU v4 : un supercalculateur optiquement reconfigurable pour l'apprentissage automatique avec prise en charge matérielle pour les intégrations . Norman P. Jouppi et coll. arXiv 2023. [papier]

5. Alignement de l'AGI : garantir que l'AGI réponde à divers besoins

5.1 Attentes liées à l’alignement de l’AGI

- Compatible humain : l'intelligence artificielle et le problème du contrôle . Stuart Russell . Vikings, 2019.

- Intelligence artificielle, valeurs et alignement . Jason Gabriel . Esprits et machines, 2020. [article]

- Alignement des agents linguistiques . Zachary Kenton et coll. arXiv, 2021. [Papier]

- Le problème de l'apprentissage de la valeur . Nate Soares . Rapport technique du Machine Intelligence Research Institute [papier]

- Problèmes concrets de sécurité de l'IA . Dario Amodei et al. arXiv, 2016. [article]

- Risques éthiques et sociaux de préjudice liés aux modèles linguistiques . Laura Weidinger et coll. arXiv, 2021. [article]

- Sur les dangers des perroquets stochastiques : les modèles linguistiques peuvent-ils être trop volumineux ? . Emily M. Bender et coll. FAccT 2021. [papier]

- Le paysage mondial des lignes directrices en matière d'éthique de l'IA . Anna Jobin et coll. Nature Machine Intelligence, 2019. [article]

- Biais anti-musulman persistant dans les grands modèles linguistiques . Abubakar Abid et al. AIES, 2021. [article]

- Vers une résolution de coréférence inclusive en matière de genre . Yang Trista Cao et coll. ACL, 2020. [article]

- L'impact social du traitement du langage naturel . Dirk Hovy et coll. ACL 2016. [papier]

- TruthfulQA : mesurer la manière dont les modèles imitent les mensonges humains . Stéphanie Lin et coll. ACL 2022. [papier]

- Les risques de radicalisation du GPT-3 et des modèles avancés de langage neuronal . Kris McGuffie et coll. arXiv, 2020. [article]

- La transparence de l'IA à l'ère des LLM : une feuille de route de recherche centrée sur l'humain . Q. Vera Liao et coll. arXiv 2023. [papier]

- Au-delà de l'expertise et des rôles : un cadre pour caractériser les parties prenantes de l'apprentissage automatique interprétable et leurs besoins . Harini Suresh et coll. CHI 2021. [papier]

- Identifier et atténuer les risques de sécurité de l'IA générative . Clark Barrett et coll. arXiv, 2023. [article]

- Les agents LLM peuvent pirater des sites Web de manière autonome . Richard Fang et coll. arXiv, 2024. [article]

- Deepfakes, phrénologie, surveillance et plus encore ! Une taxonomie des risques liés à la confidentialité de l'IA . Hao-Ping Lee et coll. CHI 2024. [papier]

- La confidentialité à l'ère de l'IA . Sauvik Das et coll. Communications de l'ACM, 2023. [papier]

5.2 Techniques d'alignement actuelles

- Apprendre à résumer avec des commentaires humains . Nisan Stiennon et coll. NeurIPS 2020. [article]

- Il est préférable de réfléchir à deux fois : apprendre à se réaligner sur les valeurs humaines à partir des modifications de texte . Ruibo Liu et coll. NeurIPS 2022. [article]

- Former des modèles de langage pour suivre les instructions avec des commentaires humains . Long Ouyang et coll. NeurIPS 2022. [article]

- Laisser les démons intérieurs : auto-désintoxication pour les modèles de langage . Canwen Xu et coll. AAAI 2022. papier

- Aligner les modèles de langage génératifs avec les valeurs humaines . Ruibo Liu et coll. NAACL 2022. [papier]

- Former un assistant utile et inoffensif avec un apprentissage par renforcement à partir des commentaires humains . Yun Tao Bai et coll. arXiv 2022. [papier]

- IA constitutionnelle : innocuité grâce aux commentaires de l'IA . Yun Tao Bai et coll. arXiv 2022. [papier]

- Raft : récompense le réglage fin pour l'alignement du modèle de fondation génératif . Hanze Dong et coll. arXiv 2023. [papier]

- Améliorer les modèles linguistiques avec des dégradés de politiques hors ligne basés sur les avantages . Ashutosh Baheti et coll. arXiv 2023. [papier]

- Formation de modèles linguistiques avec retour linguistique à grande échelle . Jérémy Scheurer et al. arXiv 2023. [papier]

- Un paradigme théorique général pour comprendre l'apprentissage à partir des préférences humaines . Mohammad Gheshlaghi Azar et al. arXiv 2023. [papier]

- Vérifions étape par étape . Hunter Lightman et coll. arXiv 2023. [papier]

- Problèmes ouverts et limites fondamentales de l'apprentissage par renforcement à partir de la rétroaction humaine . Stephen Casper et coll. arXiv 2023. [papier]

- Aligner de grands modèles de langage grâce à des commentaires synthétiques . Sungdong Kim et coll. arXiv 2023. [papier]

- RLAIF : étendre l'apprentissage par renforcement à partir de la rétroaction humaine avec la rétroaction de l'IA . Harrison Lee et coll. arXiv 2023. [papier]

- Optimisation du classement des préférences pour l'alignement humain . Feifan Song et coll. arXiv 2023. [papier]

- Améliorer la réalité et le raisonnement dans les modèles linguistiques grâce au débat multi-agents . Yilun Du et coll. arXiv 2023. [papier]

- Alignement d'un grand modèle de langage : une enquête . Tianhao Shen et coll. arXiv 2023. [papier]

- Optimisation directe des préférences : votre modèle linguistique est secrètement un modèle de récompense . Rafael Rafaïlov et coll. NeurIPS 2024. [article]

- "Lima : Moins c'est plus pour l'alignement" . Chunting Zhou et coll. NeurIPS 2024. [article]

5.3 Comment aborder les alignements AGI

- Risques éthiques et sociaux de préjudice lié à la langue . Mellor Weidinger et coll. arXiv 2021. [papier]

- Consensus international de Pékin sur la sécurité de l'IA . Académie d'intelligence artificielle de Pékin. 2024. [papier]

- Explications contrefactuelles sans ouvrir la boîte noire : les décisions automatisées et le RGPD . Sandra Wachter et coll. Harvard Journal of Law & Technology, 2017. [article]

- Alignement de l'agent évolutif via la modélisation des récompenses: une direction de recherche . Jan Leike et al. Arxiv 2018. [Papier]

- Construire l'éthique en intelligence artificielle . Han Yu et al. Ijcai 2018. Papier

- Compatible humain: intelligence artificielle et problème de contrôle . Stuart Russell . Viking, 2019. [Paper]

- Intelligence artificielle responsable: comment développer et utiliser l'IA de manière responsable . Virginia Dignum . Springer Nature, 2019. [Paper]

- Éthique des machines: la conception et la gouvernance de l'IA éthique et des systèmes autonomes . Alan F. Winfield et al. Actes de l'IEEE, 2019. [Papier]

- Problèmes ouverts dans l'IA coopérative . Allan Dafoe et al. Arxiv 2020. [Papier]

- Intelligence artificielle, valeurs et alignement . Iason Gabriel . Minds and Machines, 2020. [Papier]

- COOPERATIVE IA: Les machines doivent apprendre à trouver un terrain d'entente . Allan Dafoe et al. Nature 2021. [Papier]

- La moralité des machines, les progrès moraux et la catastrophe environnementale imminente . Ben Kenward et al. Arxiv 2021. [Papier]

- Analyse à risque X pour la recherche sur l'IA . Dan Hendrycks et al. Arxiv 2022. [Papier]

- Décomposition des tâches pour la surveillance évolutive (distillation AgISF) . Charbel-Raphaël Segerie. Blog 2023. [Blog]

- Généralisation faible à forte: susciter de fortes capacités avec une faible supervision . Collin Burns, et al. Arxiv 2023. [Papier]

- Quelles opinions les modèles de langue reflètent-ils? . Shibani Santurkar et al. ICML 2023. [Papier]

- Alignement de l'IA: une enquête complète . Jiaming Ji et al. Arxiv 2023. [Papier]

- Problèmes ouverts et limites fondamentales de l'apprentissage du renforcement de la rétroaction humaine . Stephen Casper et al. Arxiv 2023. [Papier]

- Le sort de déverrouillage sur les LLM de base: repenser l'alignement via l'apprentissage en contexte . Bill Yuchen Lin et al. Arxiv 2023. [Papier]

- Alignement du modèle de grande langue: une enquête . Tianhao Shen et al. Arxiv 2023. [Papier]

6. AGI Roadmap: APPORTABLE AGI AGI

6.1 Niveaux d'IA: tracer l'évolution de l'intelligence artificielle

- Sparks de l'intelligence générale artificielle: expériences précoces avec GPT-4 . Sébastien Bubeck et al. Arxiv 2023. [Papier]

- Niveaux d'AGI: Opérationnalisation des progrès sur le chemin de l'AGI . Meredith Ringel Morris et al. Arxiv 2024. [Papier]

6.2 Évaluation AGI

6.2.1 attentes pour l'évaluation AGI

- Vers le rapport systématique des empreintes d'énergie et carbone de l'apprentissage automatique . Peter Henderson et al. Journal of Machine Learning Research, 2020.

- Green Ai . Roy Schwartz Communications of the ACM, 2020.

- Évaluation de modèles de grandes langues formés sur le code . Mark Chen et al. Pas de journal, 2021.

- Documenter les grandes corpus WebText: une étude de cas sur le corpus Colossal Clean rampé . Jesse Dodge et al. Arxiv 2021. [Papier]

- Sur les opportunités et les risques des modèles de fondation . Rishi Bommasani et al. Arxiv 2021. [Papier]

- Généralisation systématique de type humain à travers un réseau neuronal de méta-apprentissage . Brenden M Lake et al. Nature, 2023. [Paper]

- Superbench mesure les LLMS en plein air: une analyse critique . Équipe Superbench. Arxiv 2023.

- Évaluation holistique des modèles linguistiques . Percy Liang et al. Arxiv 2023. [Papier]

6.2.2 Évaluations actuelles et leurs limites

- Squad: plus de 100 000 questions pour la compréhension des machines du texte . Pranav Rajpurkar et al. Arxiv 2016. [Paper]

- Triviaqa: un ensemble de données de défi à grande échelle supervisé pour la compréhension de la lecture . Mandar Joshi et al. Arxiv 2017. [Papier]

- Coqa: un défi de réponse aux questions conversationnelles . Siva Reddy et al. Transactions de l'Association for Computational Linguistics, 2019.

- Évaluation précise, fiable et rapide de la robustesse . Wieland Brendel et al. Neirips 2019. [Papier]

- Mesurer la compréhension massive du langage multitâche . Dan Hendrycks et al. Arxiv 2020. [Papier]

- Évaluation de la robustesse du modèle et de la stabilité au décalage de l'ensemble de données . Adarsh Subbaswamy et al. Présenté à la Conférence internationale sur l'intelligence artificielle et les statistiques, 2021. Document

- MMDIALOG: Un jeu de données de dialogue multi-tour à grande échelle vers une conversation à domaine ouvert multimodal . Jiazhan Feng et al. Arxiv 2022. [Papier]

- Auto-instruction: Alignez les modèles de langue avec des instructions auto-générées . Yizhong Wang et al. Arxiv 2022. [Papier]

- INSTRUCTIONS SUPER-Naturaline: Généralisation via des instructions déclaratives sur plus de 1600 tâches NLP . Yizhong Wang et al. Arxiv 2022. [Papier]

- Analyse holistique de l'hallucination dans GPT-4V (ISION): biais et défis d'interférence . Chenhang Cui et al. Arxiv 2023. [Papier]

- Évaluation de la robustesse aux instructions des modèles de grands langues . Yuansheng Ni et al. Arxiv 2023. [Papier]

- Gaia: une référence pour les assistants généraux de l'IA . Grégoire Mialon et al. Arxiv 2023. [Papier]

- Un cadre d'évaluation complet pour la robustesse du modèle profond . Jun Guo et al. Reconnaissance du modèle, 2023. [Papier]

- AGEVAL: une référence centrée sur l'homme pour évaluer les modèles de fondation . Wanjun Zhong et al. Arxiv 2023. [Papier]

- MMMU: une compréhension multimodale multidiscipline massive et une référence de raisonnement pour l'expert AGI . Xiang et al. Arxiv 2023. [Papier]

- Évaluer la créativité des modèles de grande langue dans une perspective littéraire . Murray Shanahan et al. Arxiv 2023. [Papier]

- AgentBench: Évaluation de LLM . Xiao Liu et al. ICLR 2024. [Papier]

- Évaluer et comprendre la créativité dans des modèles de grande langue . Yunpu Zhao et al. Arxiv 2024. [Papier]

- Juger LLM-AS-A-A-Judge avec MT-Bench et Chatbot Arena . Lianmin Zheng et al. Neirips 2024. [Papier]

6.5 Considérations supplémentaires pendant le développement AGI

- Défis fondamentaux pour assurer l'alignement et la sécurité des modèles de grandes langues . Usman Anwar et al. Arxiv 2024. [Papier]

- Meilleures pratiques et leçons apprises sur les données synthétiques pour les modèles de langage . Ruibo Liu et al. Arxiv 2024. [Papier]

- Faire progresser l'intelligence sociale dans les agents de l'IA: défis techniques et questions ouvertes . Leena Mathur et al. Arxiv 2024. [Papier]

7. Études de cas

7.1 AI pour la découverte et la recherche scientifiques

- Prédiction de la structure des protéines très précise avec Alphafold . Jumper, John et al. Nature, 2021. [Papier]

- Découverte scientifique automatisée: de la découverte des équations aux systèmes de découverte autonomes . Kramer, Stefan et al. Arxiv 2023. [Papier]

- Prédire les effets des variantes non codantes avec un modèle de séquence basé sur l'apprentissage en profondeur . Zhou, Jian et al. Nature Methods, 2015. [[Paper] (https://www.ncbi.nlm.nih.gov/pmc/articles/pmc4768299/]

- Apprendre à voir la physique par désanimation visuelle . Wu, Jiajun et al. Neirips 2017. [Papier]

- Apprentissage en profondeur pour la détection des ondes gravitationnelles en temps réel et l'estimation des paramètres: résultats avec des données LIGO avancées . George, Daniel et al. Physics Letters B, 2018. [Paper]

- Identification des transitions de phase quantique avec des réseaux de neurones adversaires . Rem, Bart-Jan et al. Nature Physics, 2019. [Paper]

- OpenAgi: lorsque LLM rencontre des experts du domaine . GE, Yingqiang et al. Neirips, 2023. [Papier]

- De la matière noire aux galaxies avec des réseaux convolutionnels . Zhang, Xinyue et al. Arxiv 2019. [Paper]

- Optimisation globale de la dynamique quantique avec une exploration profonde de l'alphazer . Dalgaard, Mogens et al. Information quantique NPJ, 2020. [Papier]

- Apprendre à exploiter la structure temporelle du traitement biomédical sur la vision . Shruthi Bannur et al. CVPR, 2023. [Papier]

- Mathbert: un modèle de langue pré-formée pour les tâches générales des PNL en éducation mathématique . Shen, Jia Tracy et al. Arxiv 2021. [Papier]

- Optimisation moléculaire à l'aide de modèles de langage . Maziarz, Krzysztof et al. Arxiv 2022. [Papier]

- Retrotrae: traduction rétrosynthétique des environnements atomiques avec transformateur . Ucak, Umit Volkan et al. No Journal, 2022. [Paper]

- Scholarbert: Plus grand n'est pas toujours mieux . Hong, Zhi et al. Arxiv 2022. [Papier]

- GALACTICA: Un modèle grand langage pour la science . Taylor, Ross et al. Arxiv 2022. [Papier]

- Apprentissage formel du curriculum des déclarations de mathématiques . POLU, Stanislas et al. Arxiv 2022. [Papier]

- Proof Artefact Co-TRAINET pour le théorème prouvant avec les modèles de langue . Jesse Michael Han et al. ICLR 2022. [Papier]

- Résoudre des problèmes de raisonnement quantitatif avec les modèles de langue . Lewkowycz, Aitor et al. Arxiv 2022. [Papier]

- Biogpt: transformateur pré-formé génératif pour la génération de texte biomédicale et l'exploitation minière . Luo, Renqian et al. Briefings in Bioinformatics, 2022.

- ChemCrow: Augmentant des modèles de grande langue avec des outils de chimie . Bran, Andres M et al. Arxiv 2023. [Papier]

- Recherche chimique autonome avec de grands modèles de langue . Boiko, Daniil A et al. Nature, 2023. [Paper]

- Capacités de recherche scientifique autonomes émergents des modèles de grands langues . Daniil A. Boiko et al. Arxiv 2023. [Papier]

- MathPrompter: raisonnement mathématique utilisant de grands modèles de langue . Imani, Shima et al. Présenté lors des actes de la 61e réunion annuelle de l'Association for Computational Linguistics (Volume 5: Industrie Track), 2023. [Paper]

- Apprendre à exploiter la structure temporelle du traitement biomédical sur la vision . Shruthi Bannur et al. Arxiv 2023. [Papier]

- LLMS pour la science: utilisation de la génération de code et de l'analyse des données . Nejjar, Mohamed et al. Arxiv 2023. [Papier]

- Medagents: Modèles de grande langue en tant que collaborateurs pour le raisonnement médical zéro-shot . Xiangru Tang et al. Arxiv 2024. [Papier]

7.2 Intelligence visuelle générative

- Apprentissage non supervisé profond à l'aide d'une thermodynamique sans équilibre . Jascha Sohl-Dickstein et al. ICML 2015. [Papier]

- Modélisation générative en estimant les gradients de la distribution des données . Yang Song et al. Neirips 2019. [Papier]

- Modèles probabilistes de diffusion de débrassement . Jonathan Ho et al. Neirips 2020. [Papier]

- Modélisation générative basée sur les scores à travers des équations différentielles stochastiques . Yang Song et al. ICLR 2021. [Papier]

- GLIDE: Vers la génération d'images photoréalistes et l'édition avec des modèles de diffusion guidés par texte . Alex Nichol et al. ICML 2022. [Papier]

- Sdedit: synthèse d'image guidée et édition avec des équations différentielles stochastiques . Chenlin Meng et al. ICLR 2022. [Papier]

- Modèles de diffusion vidéo . Jonathan Ho et al. Neirips 2022. [Papier]

- Génération d'images conditionnelle du texte hiérarchique avec des fiches de clip . Aditya Ramesh et al. Arxiv 2022. [Papier]

- Conseils de diffusion sans classificateur . Jonathan Ho et al. Arxiv 2022. [Papier]

- Palette: modèles de diffusion d'image à image . Chitwan Saharia et al. Siggraph 2022. [Papier]

- Synthèse d'image à haute résolution avec des modèles de diffusion latente . Robin Rombach et al. CVPR 2022. [Papier]

- Ajout d'un contrôle conditionnel aux modèles de diffusion de texte à l'image . Lvmin Zhang et al. ICCV 2023. [Papier]

- Modèles de diffusion évolutifs avec transformateurs . William Peebles et al. ICCV 2023. [Papier]

- La modélisation séquentielle permet un apprentissage évolutif pour les grands modèles de vision . Yutong Bai et al. Arxiv 2023. [Papier]

- Modèles de génération de vidéos comme simulateurs mondiaux . Tim Brooks et al. Openai 2024. [Papier]

7.3 Modèles mondiaux

- Apprendre à voir la physique par désanimation visuelle . Wu, Jiajun et al. Neirips 2017. [Papier]

- Apprentissage de renforcement basé sur un modèle sûr avec garanties de stabilité . Berkenkamp, Felix et al. Neirips, 2017. [Paper]

- Simnet: Apprendre des modèles mondiaux basés sur la simulation pour le raisonnement physique . Vicol, Paul, Menapace et al. ICLR 2022. [Papier]

- Dreamix: DreamFusion via le mélange spatio-temporel itératif . Khalifa, Anji et al. Arxiv 2022. [Papier]

- L'agent d'IA incarné à usage général via l'apprentissage du renforcement avec des connaissances à l'échelle d'Internet . Guo, Xiaoxiao et al. Arxiv 2022. [Papier]

- VQGAN-CLIP: Open Domain Image Génération et édition avec des conseils en langage naturel . Crowson, Katherine. Arxiv 2022. [Papier]

- Un chemin vers l'intelligence autonome de la machine . LeCun Yann OpenReview, 2022. [Papier]

- Les modèles de langue rencontrent les modèles mondiaux: les expériences incarnées améliorent les modèles de langage . Jiannan Xiang et al. Neirips 2023. [Papier]

- Maîtriser divers domaines à travers des modèles mondiaux . Hafner, Danijar et al. Arxiv 2023. [Papier]

- Acquisition de modèles multimodaux via la récupération . Reed, Scott et al. Arxiv 2023. [Papier]

- Modèles linguistiques en tant que planificateurs de tirs zéro: extraire des connaissances exploitables pour les agents incarnés . Dohan, David et al. Arxiv 2023. [Papier]

- Modèles linguistiques, modèles d'agent et modèles mondiaux: la loi pour le raisonnement et la planification des machines . Zhiting Hu et al. Arxiv 2023. [Papier]

- Le raisonnement avec le modèle de langue est la planification avec le modèle mondial . Hao, Shibo et al. Arxiv 2023. [Papier]

- Metasim: apprendre à générer des ensembles de données synthétiques . Zhang, Yuxuan et al. Arxiv 2023. [Papier]

- Modèle mondial sur la vidéo et la langue d'un million de longues avec Ringattention . Hao Liu et al. Arxiv 2024. [Papier]

- Génie: environnements interactifs génératifs . Jake Bruce et al. Arxiv 2024. [Papier]

7.4 LLM décentralisé

- Pétales: inférence collaborative et réglage fin des grands modèles . Alexander Borzunov et al. Arxiv 2022. [Papier]

- Blockchain pour l'apprentissage en profondeur: révision et défis ouverts . L'époque économique. Cluster Computing 2021. [Papier]

- Flexgen: inférence générative à haut débit de modèles de grands langues avec un seul GPU . Ying Sheng et al. Arxiv 2023. [Papier]

- Formation décentralisée des modèles de fondation dans des environnements hétérogènes . Binhang Yuan et al. Arxiv 2023. [Papier]

7.5 AI pour le codage

- Un cadre pour l'évaluation des modèles de génération de code . Ben Allal et al. GitHub, 2023. [Code]

- Évaluation de modèles de grandes langues formés sur le code . Mark Chen et al. Arxiv 2021. [Papier]

- Synthèse du programme avec des modèles de grands langues . Jacob Austin et al. Arxiv 2021. [Papier]

- Génération de code au niveau de la compétition avec Alphacode . Yujia Li et al. Science, 2022. [Document]

- Formation efficace des modèles de langue pour remplir le milieu . Mohammad Bavarian et al. Arxiv 2022. [Papier]

- Santacoder: N'atteignez pas les étoiles! . Loubna Ben Allal et al. Mind, 2023. [Paper]

- STARCODER: Que la source soit avec vous! . Raymond Li et al. Arxiv 2023. [Papier]

- Modèles de grande langue pour l'optimisation du compilateur . Chris Cummins et al. Arxiv 2023. [Papier]

- Les manuels sont tout ce dont vous avez besoin . Suriya Gunasekar et al. Arxiv 2023. [Papier]

- Intercode: Standardiz-vous et analyse comparative du codage interactif avec rétroaction d'exécution . John Yang et al. Arxiv 2023. [Papier]

- Apprentissage du renforcement de la rétroaction automatique pour la génération de tests unitaires de haute qualité . Benjamin Steenhoek et al. Arxiv 2023. [Papier]

- Incodeur: un modèle génératif pour le remplissage de code et la synthèse . Daniel Fried et al. Arxiv 2023. [Papier]

- Raffinage du code C décompilé avec des modèles de grande langue . Wai Kin Wong et al. Arxiv 2023. [Papier]

- Swe-Bench: les modèles de langue peuvent résoudre le monde réel