Prend en charge la sortie de streaming à haute vitesse, le dialogue multi-tours, le déploiement sans configuration et la prise en charge des jetons multicanaux.

Entièrement compatible avec l'interface ChatGPT.

Il existe également les huit API gratuites suivantes auxquelles il faut prêter attention :

Interface Moonshot AI (Kimi.ai) avec l'API kimi-free-api

Interface Zhipu AI (Zhipu Qingyan) avec l'API glm-free-api

Interface StepChat vers l'API step-free-api

Interface Alibaba Tongyi (Qwen) avec l'API qwen-free-api

Interface Metaso AI (Metaso) avec l'API metaso-free-api

Interface Iflytek Spark vers l'API spark-free-api

Interface MiniMax (Conch AI) avec l'API hailuo-free-api

Interface Lingxin Intelligence (Emohaa) avec l'API emohaa-free-api

L'API inversée est instable. Il est recommandé de se rendre sur le site officiel de DeepSeek https://platform.deepseek.com/ pour payer pour utiliser l'API afin d'éviter le risque d'être banni.

Cette organisation et ces individus n'acceptent aucun don ou transaction financière. Ce projet est purement destiné à la recherche, à l'échange et à l'apprentissage !

C'est pour un usage personnel uniquement, et il est interdit de fournir des services externes ou un usage commercial pour éviter de faire pression sur le service officiel, sinon c'est à vos risques et périls !

C'est pour un usage personnel uniquement, et il est interdit de fournir des services externes ou un usage commercial pour éviter de faire pression sur le service officiel, sinon c'est à vos risques et périls !

C'est pour un usage personnel uniquement, et il est interdit de fournir des services externes ou un usage commercial pour éviter de faire pression sur le service officiel, sinon c'est à vos risques et périls !

https://udify.app/chat/IWOnEupdZcfCN0y7

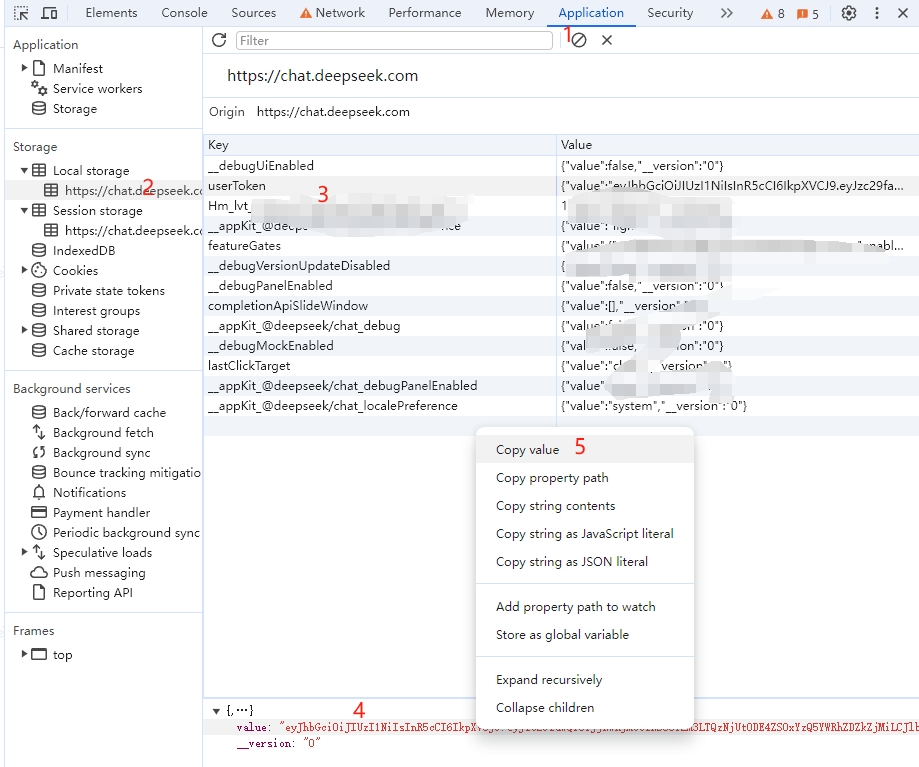

Obtenez la valeur userToken de DeepSeek

Entrez DeepSeek pour lancer une conversation, puis ouvrez les outils de développement avec F12 et recherchez la valeur dans userToken depuis Application > LocalStorage. Elle sera utilisée comme valeur du jeton du porteur d'autorisation : Authorization: Bearer TOKEN

Actuellement, le même compte ne peut avoir qu'une seule sortie à la fois. Vous pouvez fournir les valeurs userToken de plusieurs comptes , les utiliser pour fournir :

Authorization: Bearer TOKEN1,TOKEN2,TOKEN3

L’un d’eux sera sélectionné à chaque demande du service.

Veuillez préparer un serveur avec une adresse IP publique et ouvrir le port 8000.

Tirez l'image et démarrez le service

docker run -it -d --init --name deepseek-free-api -p 8000:8000 -e TZ=Asia/Shanghai vinlic/deepseek-free-api:latestAfficher les journaux de service en temps réel

docker logs -f deepseek-free-apiRedémarrer le service

docker restart deepseek-free-apiArrêter le service

docker stop deepseek-free-api version : ' 3 '

services :

deepseek-free-api :

container_name : deepseek-free-api

image : vinlic/deepseek-free-api:latest

restart : always

ports :

- " 8000:8000 "

environment :

- TZ=Asia/ShanghaiRemarque : Certaines zones de déploiement peuvent ne pas pouvoir se connecter à Deepseek. Si le journal du conteneur indique un délai d'attente de demande ou ne peut pas être connecté, veuillez passer à d'autres zones pour le déploiement ! Remarque : L'instance de conteneur du compte gratuit cessera automatiquement de s'exécuter après une période d'inactivité, ce qui entraînera un délai de 50 secondes ou plus lors de la prochaine requête. Il est recommandé de cocher Render containers keep Alive.

Forkez ce projet sur votre compte github.

Visitez Render et connectez-vous à votre compte github.

Créez votre service Web (Nouveau+ -> Créer et déployer à partir d'un référentiel Git -> Connectez votre projet forké -> Sélectionnez la zone de déploiement -> Sélectionnez le type d'instance comme Gratuit -> Créer un service Web).

Après avoir attendu la fin de la construction, copiez le nom de domaine attribué et collez l'URL pour y accéder.

Remarque : Le délai d'expiration de la réponse à la demande pour les comptes gratuits Vercel est de 10 secondes, mais la réponse de l'interface prend généralement plus de temps et vous pouvez rencontrer une erreur de délai d'attente 504 renvoyée par Vercel !

Veuillez vous assurer d'avoir d'abord installé l'environnement Node.js.

npm i -g vercel --registry http://registry.npmmirror.com

vercel login

git clone https://github.com/LLM-Red-Team/deepseek-free-api

cd deepseek-free-api

vercel --prodVeuillez préparer un serveur avec une adresse IP publique et ouvrir le port 8000.

Veuillez installer l'environnement Node.js, configurer d'abord les variables d'environnement, puis confirmer que la commande node est disponible.

Installer les dépendances

npm iInstallez PM2 pour la protection des processus

npm i -g pm2Compilez et construisez Lorsque vous voyez le répertoire dist, la construction est terminée.

npm run buildDémarrer le service

pm2 start dist/index.js --name " deepseek-free-api "Afficher les journaux de service en temps réel

pm2 logs deepseek-free-apiRedémarrer le service

pm2 reload deepseek-free-apiArrêter le service

pm2 stop deepseek-free-apiIl est plus rapide et plus facile d'utiliser le client de développement secondaire suivant pour accéder aux projets de la série d'API gratuites, et prend en charge le téléchargement de documents/images !

LobeChat développé par Clivia https://github.com/Yanyutin753/lobe-chat

ChatGPT Web https://github.com/SuYxh/chatgpt-web-sea développé par Guangguang@

Actuellement, il prend en charge l'interface /v1/chat/completions compatible avec openai. Vous pouvez utiliser l'interface d'accès client compatible avec openai ou d'autres clients, ou utiliser des services en ligne tels que dify pour y accéder.

Interface de complétion de conversation, compatible avec l'api chat-completions-api d'openai.

POST /v1/chat/achèvements

l'en-tête doit définir l'en-tête Authorization :

Authorization: Bearer [userToken value]

Demander des données :

{

// model必须为deepseek_chat或deepseek_code

"model" : " deepseek_chat " ,

"messages" : [

{

"role" : " user " ,

"content" : "你是谁? "

}

],

// 如果使用SSE流请设置为true,默认false

"stream" : false

}Données de réponse :

{

"id" : " " ,

"model" : " deepseek_chat " ,

"object" : " chat.completion " ,

"choices" : [

{

"index" : 0 ,

"message" : {

"role" : " assistant " ,

"content" : " 我是DeepSeek Chat,一个由中国深度求索公司开发的智能助手,基于人工智能技术构建,旨在通过自然语言处理和机器学习算法来提供信息查询、对话交流和解答问题等服务。我的设计理念是遵循社会主义核心价值观,致力于为用户提供准确、安全、有益的信息和帮助。 "

},

"finish_reason" : " stop "

}

],

"usage" : {

"prompt_tokens" : 1 ,

"completion_tokens" : 1 ,

"total_tokens" : 2

},

"created" : 1715061432

}Vérifiez si le userToken est vivant. Si vivant n'est pas vrai, sinon il est faux. Veuillez ne pas appeler cette interface fréquemment (moins de 10 minutes).

POST /jeton/chèque

Demander des données :

{

"token" : " eyJhbGciOiJIUzUxMiIsInR5cCI6IkpXVCJ9... "

}Données de réponse :

{

"live" : true

}Si vous utilisez le proxy inverse Nginx deepseek-free-api, veuillez ajouter les éléments de configuration suivants pour optimiser l'effet de sortie du flux et optimiser l'expérience.

# 关闭代理缓冲。当设置为off时,Nginx会立即将客户端请求发送到后端服务器,并立即将从后端服务器接收到的响应发送回客户端。

proxy_buffering off ;

# 启用分块传输编码。分块传输编码允许服务器为动态生成的内容分块发送数据,而不需要预先知道内容的大小。

chunked_transfer_encoding on ;

# 开启TCP_NOPUSH,这告诉Nginx在数据包发送到客户端之前,尽可能地发送数据。这通常在sendfile使用时配合使用,可以提高网络效率。

tcp_nopush on ;

# 开启TCP_NODELAY,这告诉Nginx不延迟发送数据,立即发送小数据包。在某些情况下,这可以减少网络的延迟。

tcp_nodelay on ;

# 设置保持连接的超时时间,这里设置为120秒。如果在这段时间内,客户端和服务器之间没有进一步的通信,连接将被关闭。

keepalive_timeout 120 ;Étant donné que le côté inférence n'est pas dans deepseek-free-api, le jeton ne peut pas être compté et sera renvoyé sous la forme d'un nombre fixe.