llm agent

1.0.0

LLM basé sur RAG utilisant la mémoire à long terme via une base de données vectorielles

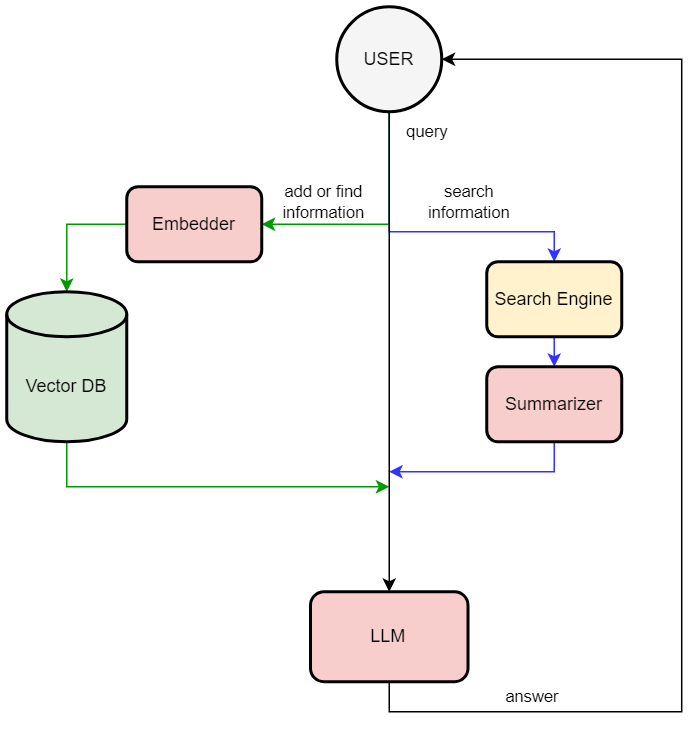

Ce référentiel permet au grand modèle de langage d'utiliser la mémoire à long terme via une base de données vectorielle (cette méthode est appelée RAG (Retrieval Augmented Generation) — il s'agit d'une technique qui permet à LLM de récupérer des faits à partir d'une base de données externe). L'application est construite avec mistral-7b-instruct-v0.2.Q4_K_M.gguf (en utilisant la liaison LAMA_cpp_python) et chromadb. L'utilisateur peut demander en langage naturel d'ajouter des informations à la base de données, rechercher des informations dans la base de données ou sur Internet en utilisant les conseils.

You > Hi

LOG: [Response]

Bot < Hello! How can I assist you today?

You > Please add information to db "The user name is Rustam Akimov"

LOG: [Adding to memory]

Bot < Done!

You > Can you find on the Internet who is Pavel Durov

LOG: [Extracting question]

LOG: [Searching]

LOG: [Summarizing]

Bot < According to the search results provided, Pavel Durov is a Russian entrepreneur who co-founded Telegram Messenger Inc.

You > Please find information in db who is Rustam Akimov

LOG: [Extracting question]

LOG: [Querying memory]

Bot < According to the input memories, your name is Rustam Akimov.