reweight gpt

1.0.0

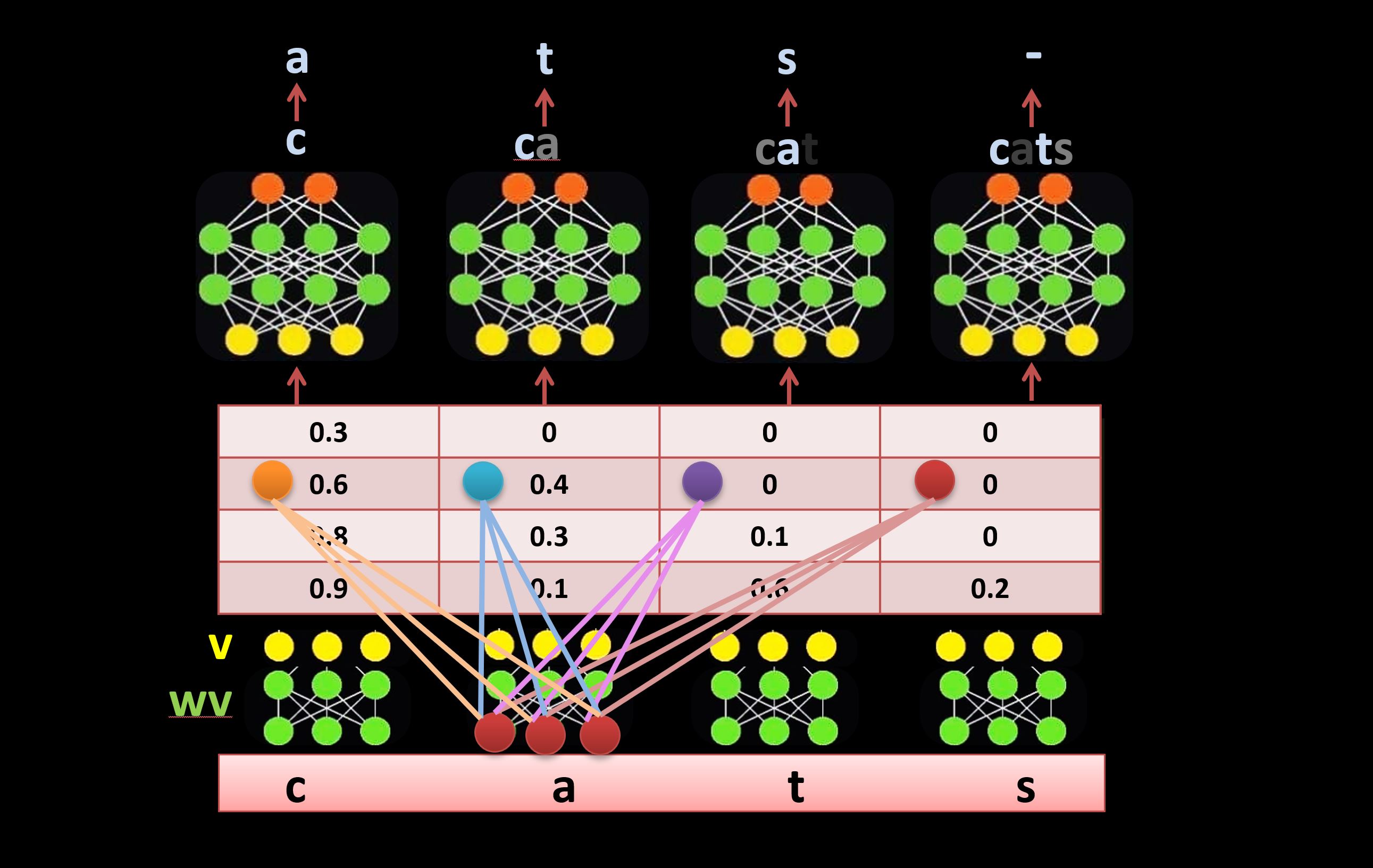

Une alternative au mécanisme d’auto-attention dans l’architecture Transformer. Il utilise des connexions latérales apprenables pour repondérer les entrées directement au lieu du mécanisme d'auto-attention (comme illustré ci-dessous). Pour en savoir plus sur la méthode, regardez cette vidéo (à partir de 41:26) : https://youtu.be/l-CjXFmcVzY