L'IA génère des romans en un clic

À propos du projet • Journal des modifications • Invite de génération de roman • Démarrage rapide • Guide d'utilisation de la démo • Contribution

Le projet comprend un nouveau générateur basé sur de grands modèles de langage tels que GPT, ainsi que diverses invites et didacticiels de nouvelle génération. Nous apprécions les contributions de la communauté et continuons à mettre à jour pour offrir la meilleure expérience d'écriture de roman.

Long-Novel-GPT est un nouveau générateur basé sur de grands modèles de langage tels que GPT. Il adopte une structure hiérarchique plan/chapitre/texte pour saisir l'intrigue cohérente du roman ; il obtient le contexte grâce à un mappage précis du plan->chapitre->texte, optimisant ainsi les coûts d'appel d'API et optimise en permanence en fonction de ses propres commentaires ou de ceux des utilisateurs ; . , jusqu'à ce que vous créiez le roman dans votre esprit.

Écriture structurée : La structure hiérarchique saisit efficacement le contexte de développement du roman.

Cycle de réflexion : optimiser en permanence le plan généré, les chapitres et le contenu du texte

Optimisation des coûts : la gestion intelligente du contexte garantit des coûts d'appel API fixes

Axé sur la communauté : bienvenue pour contribuer aux invites et aux suggestions d'amélioration afin de promouvoir conjointement le développement du projet

Démo en ligne : Démo Long-Novel-GPT

Prend en charge la recréation individuelle des paragraphes sélectionnés lors de la création (en citant le texte)

La génération d'invites pour les plans, les chapitres et le texte principal a été optimisée.

Vous avez le choix entre trois invites intégrées pour le plan, les chapitres et le texte : Nouveau, Étendu et Poli.

Prend en charge la saisie de votre propre invite

La logique d'interaction de l'aperçu rapide est meilleure

Prend en charge la génération en un clic et vous aidera automatiquement à générer tous les plans, chapitres et textes.

Ajout de la prise en charge du modèle GLM

Ajout de la prise en charge de plusieurs grands modèles de langage :

Série OpenAI : o1-preivew, o1-mini, gpt4o, etc.

Série Claude : Claude-3.5-Sonnet, etc.

Wen Xinyiyan : ERNIE-4.0, ERNIE-3.5, ERNIE-Roman

Pouf: série doubao-lite/pro

Prend en charge tout modèle personnalisé compatible avec l'interface OpenAI

Optimisation de l'interface de génération et de l'expérience utilisateur

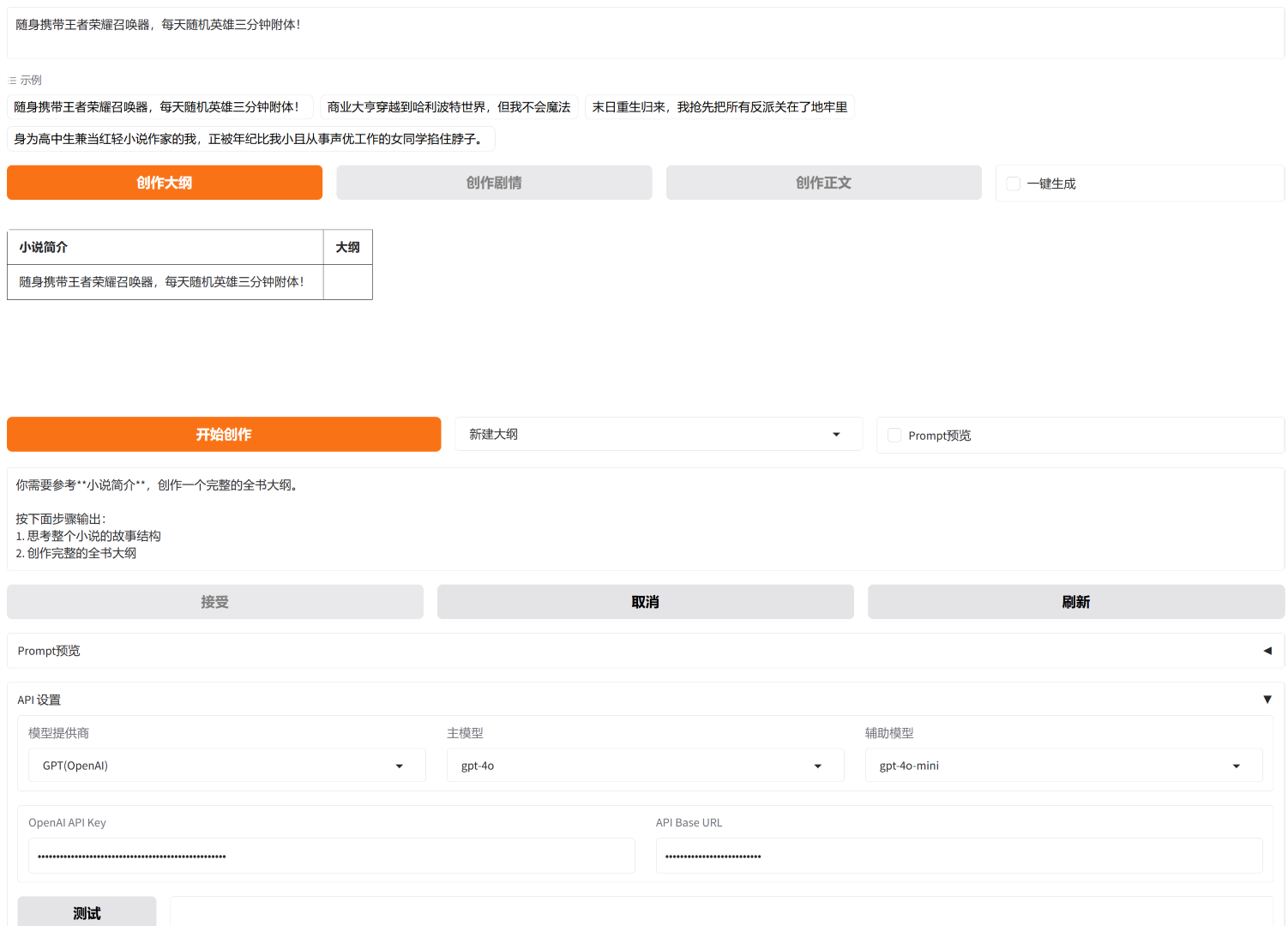

La démo prend en charge plusieurs grands modèles de langage (l'image montre l'interface de configuration de l'API)

Une démo en ligne est fournie pour prendre en charge la génération directe de l'intégralité du livre à partir d'une seule phrase d'idées.

Envisagez une interface d'édition plus belle et plus pratique (terminé)

Prise en charge du modèle Wenxin Novel (terminé)

Modèle de pouf de support (terminé)

Générez directement un roman complet en un clic à partir d'une idée (en cours)

Prise en charge de la génération de plans et de chapitres (en cours)

Long-Novel-GPT 1.5 et les versions précédentes fournissent une application complète de nouvelle génération, mais l'expérience de fonctionnement n'est pas parfaite. À partir de la version 1.6, nous accorderons plus d'attention à l'expérience utilisateur, réécrirons une nouvelle interface et déplacerons les fichiers du projet vers le répertoire principal. La démo précédente n'est plus prise en charge. Si vous souhaitez en faire l'expérience, vous pouvez choisir le commit précédent à télécharger.

| Rapide | décrire |

|---|---|

| À la manière de pommes de terre Cécilia | Utilisé pour créer un texte basé sur le contour, imitant le style d'écriture de Tiancan Tudou |

| Polir le brouillon | Polissez et améliorez la première ébauche de votre article en ligne |

Soumettez votre invite

Aucune installation requise, découvrez notre démo en ligne maintenant : Démo Long-Novel-GPT

Création parallèle multithread (l'image montre la scène de création du texte)

Prend en charge l'affichage de l'invite (l'image est la réponse du modèle o1-preview)

Si vous souhaitez exécuter Long-Novel-GPT localement :

conda create -n lngpt python conda activer lngpt pip install -r exigences.txt

cd Long-Roman-GPT pythoncore/frontend.py

Après avoir démarré, visitez simplement le lien dans le navigateur : http://localhost:7860/

Oui, Long-Novel-GPT-1.9 utilise la génération multi-thread et gère automatiquement le contexte pour assurer la continuité des intrigues générées. Dans la version 1.7, vous devez le déployer localement et utiliser votre propre clé API, et configurer le nombre maximum de threads utilisés lors de la génération dans config.py .

MAX_THREAD_NUM = 5 # Nombre maximum de threads utilisés lors de la génération

La démo en ligne n'est pas possible car le nombre maximum de threads est de 5.

Tout d’abord, vous devez le déployer localement, configurer la clé API et lever les restrictions de thread.

Ensuite, lors de la phase de création du plan , vous devez générer environ 40 lignes d'intrigue, chaque ligne contient 50 mots, il y a donc 2 000 mots ici. ( Développez tout le contour en cliquant continuellement)

Deuxièmement, lors de la phase de création de l’intrigue , le plan est passé de 2 000 mots à 20 000 mots. (10+ threads en parallèle)

Enfin, lors de la phase de création du texte , les 20 000 mots sont étendus à 100 000 mots. (plus de 50 threads en parallèle)

La version 1.7 est la première version à prendre en charge la génération de romans de niveau million. Elle garantit principalement le traitement multithread, la gestion des fenêtres de génération et fournit une interface complète.

La version 1.9 a considérablement optimisé les invites, fournissant trois types d'invites : des invites nouvelles, étendues et perfectionnées parmi lesquelles les utilisateurs peuvent choisir, et elle prend également en charge les invites de saisie.

En général, la version 1.9 peut générer des articles Web qui atteignent le seuil du contrat sous la supervision des utilisateurs.

Notre objectif ultime est toujours de générer le livre entier en un seul clic, qui sera officiellement lancé après 2-3 itérations de version.

Actuellement, la démo prend en charge GPT, Claude, Wenxin, Doubao, GLM et d'autres modèles, et la clé API a été configurée. Le modèle par défaut est GPT4o et le nombre maximum de threads est de 5.

Vous pouvez sélectionner n'importe quelle idée dans l'exemple et cliquer sur Créer un plan pour initialiser le plan.

Après l'initialisation, cliquez sur le bouton Démarrer la création pour continuer à créer le plan jusqu'à ce que vous soyez satisfait.

Après avoir créé le contour, cliquez sur le bouton Créer un tracé , puis répétez le processus ci-dessus.

Après avoir sélectionné la génération en un clic , cliquez à nouveau sur le bouton de gauche pour générer la génération en un clic.

Si vous rencontrez des problèmes non résolus, cliquez sur le bouton Actualiser .

Si le problème ne peut toujours pas être résolu, veuillez actualiser la page du navigateur. Cela entraînera la perte de toutes les données. Veuillez sauvegarder manuellement les textes importants.

Nous acceptons toutes les formes de contributions, qu'il s'agisse de suggestions de nouvelles fonctionnalités, d'améliorations du code ou de rapports de bogues. Veuillez nous contacter via les problèmes GitHub ou les demandes d'extraction.

Vous pouvez également rejoindre le groupe et discuter en groupe.